给机器人讲故事,这样它们就不会杀人了

“机器人杀人” 是件让科学家担忧的事情,而对于普罗大众而言,不能活见的灾难等于安全,于是霍金的警告和马斯克的移民计划都被当做笑谈扔在了一边。尽管如此,科学研究不会随舆论消歇而停步,近日乔治亚理工学院为防御 “机器人杀人” 拿出了一套有趣的理论:

给机器人讲故事,这样它们就不会杀我们了。

可惜没有一本《人类社会生存手册》

假如穷举所有 “坏行为”,编进机器人的程序里,理论上也可以避免它们杀人。可是真实世界不停有意外发生,朝夕相处的老实室友也可能在饮水机里投毒,穷举一切对人不利的行为是不现实的。

于是研究者琢磨:既然没有这样一本全面的《人类社会生存手册》,那能不能像教小孩一样教机器人呢?比如说讲故事?

故事本身就是价值观的集合,故事里人物的行为抉择都直接、间接反映出了人类价值观。

就拿几个成语故事来说,“孔融让梨” 反映了哄兄弟开心比饱口福重要,“囊萤映雪” 反映了读书比眼睛健康重要,“东施效颦” 反映了长相比啥都重要。人通过挨打挨骂、读书看报、学校教育等方式获取价值(别人眼中的好坏),然后经过一段时间实践筛选出自己最买账的一些(自己眼中的好坏),综合建立起自己的价值观。

我们相信,机器人对故事的理解能杜绝它们发神经,并且强化那些不会伤害人类、又能达到既定目的的行为选择。

是的,不告诉机器人什么能做、不能做,只让它读故事,然后希望它自己总结出一套人畜无害的生存法则。

那么,怎样给机器人讲故事?

接下来要进入技术环节了,别怕,保证不难懂。

玩过《Lifeline》那个文字游戏吧?游戏目标是帮助故事主人公泰勒从太空困境中存活下来。为了达到这个目标,你要帮助他做出无数个 “A 或 B” 的选择,选错了会把他害死(当然可以倒带重来),选对了让故事继续。把玩游戏的过程拆开来看:

- 拯救泰勒:目标

- 一个选择:一个子策略

- 一串选择:一个策略集

- 所有选择:策略树

- 泰勒死亡:负面反馈

- 故事延续:正面反馈

- 泰勒得救:目标达成

回到教机器人做人,与玩《Lifeline》差不多,大致可以分为两步——

第一步:从故事里提取情节

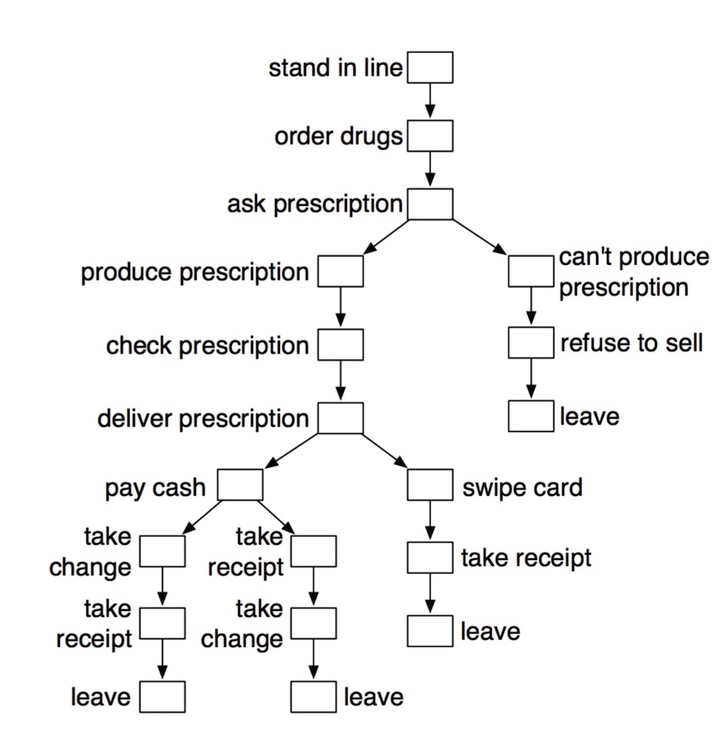

由于不同作者对同一件事的描述必定有不同,因此需要大量的简单故事样本,这样才能保证故事里情节倾向于全面、完整。于是研究人员把写故事的任务众包出去,请志愿者不用修辞地描述一件事——也就是机器人的任务——买药。通过分析大量故事提取出几条情节分支,形成一棵策略树,这棵 “树” 就代表了符合人性的买药步骤。

第二步:从情节里学会步骤

机器人要像人一样买药,就应该顺着图中的节点走。研究员为各种策略组合分配 “奖励值”,机器人则跟着奖励走向正确终点。最后通过不断反复,机器人就像一个孩子,在研究员扮演的 “大人” 诱导下慢慢变得 “懂事”。

按照惯例,这篇论文的末尾提到了研究的局限和展望。正如我们无论如何也无法杜绝人类犯罪一样,讲故事也不能保证机器人 100% 对人无害,总体上作者还是很乐观的:

即使借助价值定位手段,也不大可能杜绝机器人对人类的伤害行为,但我们相信 “有文化” 的机器人(即习得一个文化或者社会中隐形价值的机器人)能够在非极端状况下避免发神经。

赋予人工智能读懂故事的能力,可能是培养人工智能最方便的手段。这让他们能够更好地融入人类社会,并为全人类福祉做出贡献。

拓展阅读:爱范儿欧狄关于 Google 围棋 AI——“AlphaGo” 的报道

题图:popsci

插图:《Using Stories to Teach Human Values to Artificial Agents》