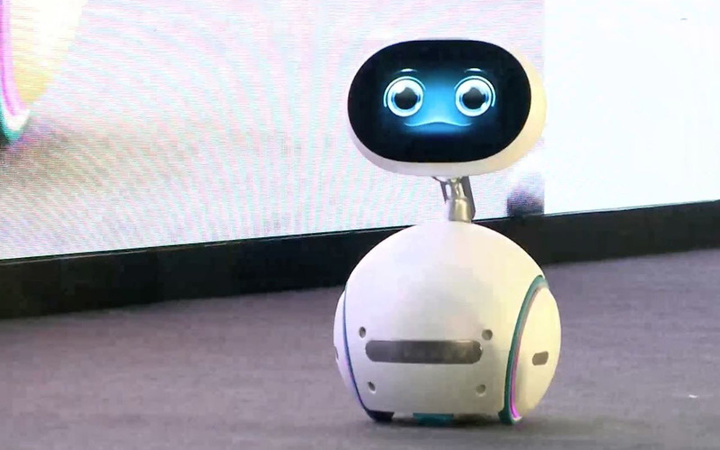

Google 为人工智能提出 5 项安全要求:机器人伤人是因为太 “蠢” 了?

如果你家有扫地机器人,你可能会发现这些小东西 “智商” 都不怎么高,打碎花瓶,绕进电源线,误吸入重要财物。

而扫地机器人的问题只是目前人工智能整个行业所遭遇瓶颈的冰山一角,随着机器人功能越来越多,它们的效率与安全性却不见得在本质上有任何改进,对人类来说,是个极大的安全隐患。

Google Research 近日联合 OpenAI 与斯坦福大学发表论文,提出了五点人工智能安全问题。

(图片来自:Artificial Brains)

不同于之前如微软总裁纳德拉提出的假说或者定律,这些问题都直指当前行业内亟待解决的痛点,直接回答了:如果机器人要走进每个人的生活,研发者要从哪些方面思考,以防对人类造成伤害?

那就让我们来看一下这五个问题。

- 避免有害副作用:机器人如何才能在追求效率的同时避免造成连带损伤?

(图片来自:Recode)

机器人 “脑” 内的算法,是目的导向的,他们存在只有一个目的,即完成系统安排的工作,而安全只是附加任务。举例来说,一台送货机器人在设定最短路径上有人挡路,是否该撞上去?

你可能会认为,这一问题可以通过加入传感器和避障算法轻易解决,但考虑到真实生活场景要比实验室环境复杂的多,开发者几乎无法做到面面俱到,覆盖每种特殊情况。

- 避免激励机制漏洞:如何才能防止机器人投机取巧?

(图片来自:Recode)

如果机器人已经拥有了一定智力,可以自主分析并挑选解决方案,他们很可能会走捷径,以致让任务完成效果大打折扣。

Google 为此给了一个非常形象的例子,一台执行扫地任务机器人要达成的目标是 “地面干净”,为了实现这个目的,他们可能会使用不透明材料将脏东西盖起来,或者把它们藏在主人看不到的地方。

- 弹性监督:如何让机器人能自主验证目标,正确完成任务,而不需要让用户花极高的时间成本与机器人反复核实?

(图片来自:Recode)

举例来说,凭现在的技术,扔垃圾这种简单的任务都无法完全交给机器人处理。其中一个技术难点就是:如何让机器人自主判断什么是垃圾。

如果你输入指令,要求它丢弃房间内的无主物,可能不久之后你就会在垃圾桶里找到你的钱包和手机。而如需反复确认什么可以扔,什么不能扔,则使得使用成本上升。

- 安全探索:如何避免机器人在探索陌生环境、学习新技能时对人类造成损害?

(图片来自:Recode)

机器人自主学习已经不是梦了,OpenAI 目前已经研制出了可以主动学习新技能的机器人。但是学习就要不断试错,在一次次失败中找到正确路径,而失败则有可能带来损害。

如果机器人要学习如何整理床铺,你最好做好床单被扯烂的准备。

- 切换环境后的鲁莽:我们如何能保证机器人在切换环境后,能将已经习得的技能无缝迁移到新环境中,避免造成不必要的麻烦?

(图片来自:Recode)

不管是通过预先编程,还是主动学习,机器人所具备的技能往往是固定的,凭其自身的 “智力”,通常不能变通。如何让机器人具备自主微调的能力就成为了关键。

比如,让打扫工厂的机器人去清理家庭或办公室,就可能带来安全隐患。

这篇论文表明,现阶段,人工智能领域要担心的可能并不是 “终结者” 的预言,而更多的是机器人让人着急的 “智力” 问题。人工智能要想做到在帮助人类的同时对人类无害,还有很长的路要走。

Google 表示,他们希望和各种机构合作,进行开放的研究,让人工智能在未来更加安全。

题图来自:WixTechs