你尽管「动脑」,话交给脑机接口来说

本文来自微信公众号脑极体(ID:unity007),作者为小豪,爱范儿经授权发布。

很多人都知道霍金拥有一台极高科技含量的轮椅,能在无法动弹或者言语的情况下,合成语音,以与外界进行交流,甚至还因此著书立说。

但也可能有很多人不知道这台轮椅是如何工作的。其实霍金一开始可以用手指来敲打键盘输出文字,但随着病情的加重,手指也无法动弹。于是相继采用过眼球跟踪和脑电波识别的技术,但最终由于病情的加重而放弃。

后来的霍金是戴着一副安装了红外探测器的眼镜,通过识别脸颊的一块儿肌肉运动,来代替原来的按键。

至少在霍金在世的时候,他采用的已经是世界上最先进的语音合成技术。但科技的进步往往神速而出乎意料,如果霍金多活几年,他连动「肉」的劲儿都省掉,直接动动脑子,就能合成语音了。

因为,脑机接口技术,又搞了个大事情。

让脑电波开口「说话」的前夜:先来打个字吧

以脑机接口的方式,捕捉大脑电波,然后实现打字的目的,再进行语音合成输出,并不是一个很难的课题。

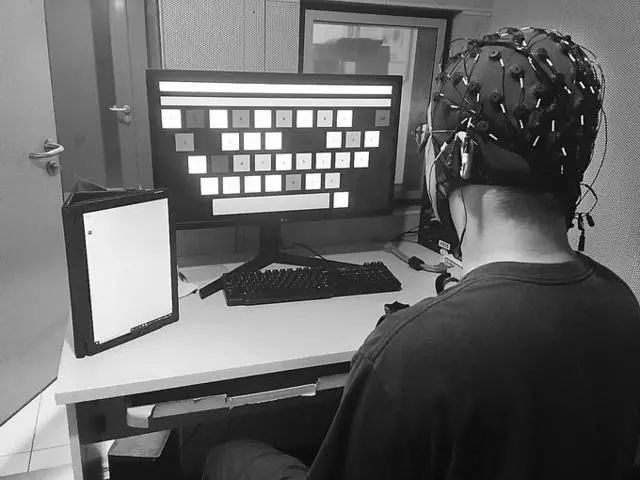

去年世界机器人大会上,清华大学研发的「动态窗稳态视觉诱发电位脑机接口系统」就「主导」了一场通过脑机接口来打字的比赛。参赛者们只要在头上戴上相关设备,将注意力集中到电脑屏幕上的虚拟键盘中的字母上,脑电波就会被捕捉,然后将对应的字母显示出来。

字母打得多了,字也就打出来了。

这种方式和对霍金的一小块儿肌肉进行捕捉原理上基本上没有差别,都是通过捕捉人对字母的强烈反应而实现语言的输出。不同之处在于,霍金由世界顶尖科技团队开发,可以采用单词联想的方式提高打字的效率。

这种方法听起来确实很高端,但也存在一定的不足。

第一,打字的速度较慢。英语还好一点,只要字母拼全就完成了打字的过程;而汉语还需要进行转化,遇到同音词还需要进一步进行选择,这就需要进行二次脑电波捕捉。逐字的打字方法令其在单位时间内能够打出的文字相当有限。

第二,对参与者的精神集中有要求,而且抗干扰较弱。脑电波是非常敏感而且活跃的。一方面人如果注意力无法高度集中,系统就将很难对字母进行定位;另一方面人的大脑在看到字母的时候往往会不由自主地产生联想,比如看到「c」会想到「copy」或者「car」等词,这也会对系统识别产生干扰。

正常人想要顺利打个字都极度耗费体力,就更不要说那些身患阿尔兹海默症或者其他病症导致无法言语的病人了。霍金之前没有采用类似的方案,就是考虑到无法承受如此的体力消耗。

当然,个人认为这种方案虽然目前仅仅还停留在科技「趣闻」或者「猎奇」的阶段,但其本身是一种突破性的。它的意义并不在于有多好用或是取得了多少实际的效果,而是在于探索出了一条脑机接口的新的道路。至少让人们看到,通过脑机接口来实现「意念」输处文本甚至是语音输出是完全可行的。

而这种可行性,被加州大学旧金山分校的一项研究成果,进一步证实并且加强。

把脑电波合成为语音,总共分几步?

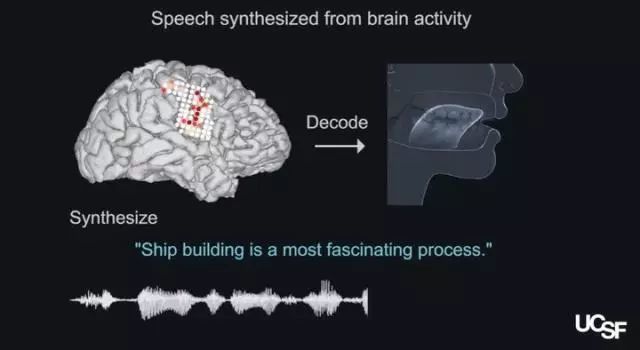

加州大学旧金山分校的神经科学家的解决方案,是从解剖学的角度出发,模拟真人发音时大脑发出的口腔喉咙肌电信号对发音系统的调动,比如在发「啊」这个音的时候,嘴唇、下巴、舌头和喉咙以及其他成分的动作,然后合成相应的语音。

那么,要把脑电信号合成为语音,总共分几步呢?

第一步,样本收集。研究者让5名完全健康的志愿者在UCSF Epileps接受了一项外科手术,在其大脑中临时植入了一块电极。接下来,志愿者被要求大声朗读指定的数百句话。在朗读的过程中,科学家记录了不同语言文字在朗读过程中在大脑区域内的活动信号。

第二步,破译信号。通过循环神经网络(RNN)的不断学习,研究者将大脑神经信号转换成了发音器官动作的信号,这些信号与发音器官的动作直接相关,比如嘴唇、下巴、舌头、喉咙等。

第三步,虚拟声道。虚拟不同声音所产生的声道运动,就像汉语中双唇音、唇齿音、舌尖中音等所需要调动的不同发音部位一样,正常来说,如果模拟的发音运动模式和人正常说话时一样,那么所发的音也一定是一样的。

最后一步,就可以进行语音输出了。

为了测试虚拟语音的流畅性,研究者们在亚马逊的任务众包平台Mechanical Turk上招募听众来对这些合成语音的325个单词和101个句子进行辨认,结果大部分的单词和句子都被人们成功识别。

这意味着,不用动嘴,通过脑电波来实现语音输出,完全是有可能的。这对于中风、脑损伤或其他疾病而导致的语言功能障碍的辅助,将具有里程碑式的意义。

技术落地尚远,「脑机」仍需努力

相较于「字母表模式」,这项研究的优势是显而易见的。

首先,语音合成速度会得到大大提高。字母表模式下,比如通过眼动或者肌肉块儿的捕捉,每分钟能成功输出10个单词左右。对于正常交流而言,一分钟说10个字,一方面的确很不便,另一方面确实很考验人的耐心。而通过声道模拟语音,每分钟输出的单词可以达到150个,这与自然语言中每分钟100-150个单词已经几乎没有差别。实现正常人般的交流,可以说毫无压力。

其次,相较于捕捉大脑信号对字母的感应,语音产生的机电信号更为强烈,也就更容易捕捉。所以,这在很大程度上可以缓解因信号识别缓慢而导致语音合成效率低下和患者焦虑的问题,更进一步而言,也增加了患者的接受度。

当然,作为一项尚未走出实验室的技术,它的缺陷也明显存在。

第一,人工智能识别的准确率和数据的丰富程度呈正相关。也就是说,利用RNN去进行学习破译脑电波信号并将其转化为发音器官动作的信号,要想实现较高的正确率,就需要大量的数据。目前的现实是,虽然语音输出的速度很快,但也只有一半的句子会被识别出来。就像说话的时候嘴里含着一口水,必然是会影响交流的感受和效率的。

第二,不同语言、不同方言之间的通用性很弱,即便是同一种语言,由于方言的差异性也会导致发音的时候各部位的运动存在着细节性的发音差异,会导致语音合成的混淆。比如在汉语中「六」的发音,不同地域之间的差别达到了二十多个。为一种语言建立一种样本?似乎有点过于繁琐。

所以,如果能找到一种更好的方法能够增强该技术的通用性尚可,如果仅仅停留在这个层面,其产品很可能无法走入寻常百姓家,而是成为显贵人群的私人订制。

研究者们自己也承认,声道运动和语音的最终形成是一个复杂的关系,目前该系统对合成较慢的发音比较擅长,对说话者的节奏和语调有一定的要求,距离最终的应用,仍然是有很长的一段路要走。

但不管怎样,这也应该属于脑机接口技术的一次重大突破了。试想在不远的将来,你只需要动动脑子,就会有准确无误的文本或者语音转化出来,人机交互将会变得多么顺畅而自然;而对于那些长期存在语言表达障碍的弱势群体而言,或许「福音」二字,已经远不足以表达其所蕴含的难以估量的价值。