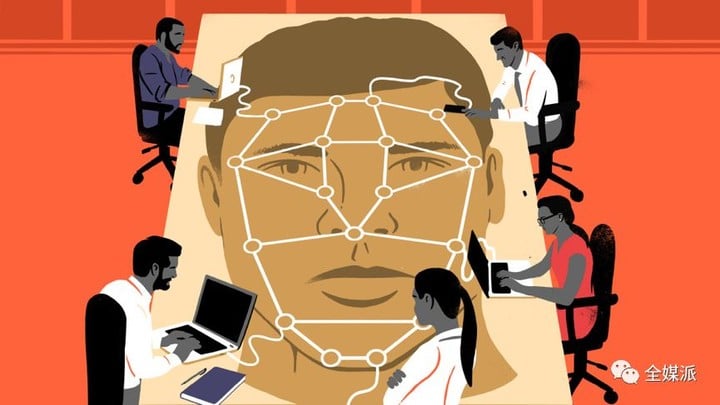

人脸识别的技术盲区与隐私边界:当面孔成为大数据养料,你的脸还好吗?

本文来自公众号全媒派(ID:quanmeipai),作者

「刷脸」进门,「靠脸」吃饭……在人脸识别技术日渐成熟的今天,这些曾经的想象已经无限接近于现实。根据前瞻行业研究院的预测,未来五年中国人脸识别整体市场将快速成长,实现多行业应用,预计到2021年中国人脸识别市场规模将突破50亿元。

▲在2018年北京安博会上,参观者走过一个展示面部识别软件的屏幕

但是,在人脸识别一路狂奔的同时,技术开发所涉及的隐私问题日渐暴露,应用中的弊病也逐渐凸显。

试想,在简单「刷脸」就能完成一切的同时,你的五官数据将永远成为网络数据集的一部分,甚至有可能被不同的机构调用。人脸识别所带来的并不只是便利、高效和未来感,在现阶段,它应该更多地与伦理、审查、规范化相联系。本期全媒派(ID:quanmeipai)带来独家编译,让我们放下对这项技术的想象与憧憬,从最现实的角度对其进行探讨和反思。

当研究数据被永久存储,如何划定隐私边界

当你走进一家坐着20个人的咖啡店,至少会有22个摄像头在你身边:每个人的手机里有一个,另一个通常高高悬挂在角落。你说的内容可能被偷听或被发布出去,你甚至可能出现在另一位顾客的自拍或视频会话背景中。但即使最注重隐私的人也不会因此而拒绝进入咖啡店,因为人们都能接受进入公共场所固有的风险。

正是这种对隐私的「合理」期望,使那些需要在公共场合采集人脸识别研究对象的研究者心安理得。但是,当公共场合采集的信息成为了永久且开放的数据集,如何划定「合理」的隐私边界,就成为了一片学术伦理尚未完善的灰色地带。

成为数据集的研究对象

杜克大学、斯坦福大学和科罗拉多州立大学多泉分校的学者们,都利用了校园监控作为捕捉研究对象的手段,但这一行为引起了强烈的反对。虽然人们对在咖啡店里被人偷听有心理准备,但却没有想过会突然变成研究对象,更何况,被录入的研究对象将永远成为数据集的一部分。

伦理委员会(IRB)批准了这三个使用学生数据来改进机器学习算法的研究项目。杜克大学研究员Carlo Tomasi在《杜克大学纪事报》(Duke Chronicle)的一份声明中表示,他「真诚地认为」自己遵循了委员会的指导方针。

为了开展研究,他和他的同事在公共区域的所有入口处张贴海报,告诉人们他们正在被记录,如果他们想要删除自己的数据,可以留下联系信息。Tomasi也告诉《纪事报》,没有人主动来联系研究团队删除数据。

但Tomasi承认,他没有通知IRB自己研究范围的变化。一般来说,微小的变化是可以不用上报的,但是Tomasi获得的批准是在室内录制,并且只有提交请求才能访问数据库。但现实中,他在室外录制,并且将数据库向所有人开放。他向《纪事报》表示,「IRB不应该受到指责,因为我没有在关键时刻咨询他们。我对我的错误承担全部责任,我向所有被记录的人和此举对杜克大学造成的影响道歉」。

有限的监管和失控的后果

在科罗拉多州立大学多泉分校,首席研究员表示虽然他们通过学生数据来测试技术,但是团队从未收集过具体到个人的识别信息。在独立声明中,大学们都重申IRB批准了所有研究,并强调了其对学生隐私的承诺。

但问题在于,大学伦理委员会的监管范围是有限的。他们主要关注研究是如何进行的,但对研究将会如何结束,后续会产生什么影响却并不关心。

正如盖辛格的IRB领导委员会主席、生物伦理学家Michelle Meyer所解释的那样,IRB主要关注的隐私问题是在公共场所开展观察研究时,研究对象是否被单独识别,以及对他们的识别是否会使他们面临实质利益或生理上的伤害。「从理论上讲,如果你正在制造一枚核弹,其中涉及调查或采访人类受试者,那么IRB考虑的风险将是直接参与该项目的人员面临的风险,而不是核爆炸的潜在风险。」

值得注意的是,在信息时代,大多数学术研究都依靠互联网,而互联网上的信息将永远存在。为其他研究人员开放数据集会增加伴生风险,但IRB在这一方面并没有多少管辖权。因为从根本上说,数据共享与研究本身并不是一回事,因此它处在「一个奇怪的灰色监管地带」,Meyer解释说。

如果IRB对研究可能导致的后果漠不关心,那么其他不受IRB标准约束的研究人员,就可以下载数据集并按照他们的意愿随意使用。而被研究的对象却对自己正在被研究这件事全然不知,这可能会导致各种消极的后果。

这些后果或许远远超出研究人员的想象。德国反监视专家Adam Harvey在全球范围内发现了100多个引用杜克数据集的机器学习项目。他创建了一张地图,用于追踪这一数据集在全球的传播情况,就像飞机的航线图一样,从杜克大学向各个方向延伸出长长的蓝线,指向世界各地的大学、初创企业和研究机构,包括中国的商汤科技(SenseTime)和旷视科技(Megvii)。

每次有新项目访问数据集时,损害可能导致的影响和范围都会发生变化。数据的可移植性和互联网的快速度结合在一起,大大扩展了一个研究项目的可能边界,也把风险扩展到远远超出任何一所大学能承担的范围。

解决尝试:建立学术审查系统

杜克大学最终决定删除与该研究相关的数据集。斯坦福大学清除了研究人员基于旧金山咖啡馆的顾客所创建的数据集。

科罗拉多大学博尔德分校信息科学系助理教授Casey Fiesler撰写了关于在研究中使用公共数据的伦理学。Fiesler提出了一种用于审查数据集访问的系统,与审查版权类似。她指出,系统中的使用条款主要关注请求者计划如何使用该数据。

「为这些数据集设置守门人是一个好主意」,她说,「因为只要明确使用目的,请求者就能够访问数据集。」类似的规则在开源软件和Creative Commons的标准化版权许可协议上已有应用。

Creative Commons是一种基于许可的系统,请求者只能将获得的作品作为非商业用途,而一旦他们隐瞒或歪曲意图,则需要承担责任。这些标准可能与学术环境并不完全匹配,但至少在切断后续伤害方面是有用的。「这并不是将规则繁琐化,但它提出了一种方法,使得你无论决定要做什么时,都把前后因果考虑进去」,Fiesler说。

种族歧视&影响执法,应用中暴露的技术盲区

当人脸识别技术走出实验室,走进现实生活,它就被赋予了更多意义——你的脸将不再只是一张具有生物属性的脸了。在足球比赛中,你的脸是货币,用于在体育场购买食物。在商场,它是一个账本,用于告诉销售人员你过去的购买行为以及购物偏好。在抗议中,你的脸会反映出你过去被逮捕的历史。即使在太平间,脸也能帮助官方机构识别遗体。

随着人脸承载的意义不断加强,技术错误导致的后果严重性也随之增强。在现阶段的应用中,人脸识别技术的一些弊端已经暴露。

识别准确度存在差异,加剧种族歧视

2016年麻省理工学院的研究员Joy Buolamwini研究表明,人脸识别技术的准确性在肤色较浅的男性中表现优于肤色较深的男性,而对于肤色较深的女性则表现最差。

美国公民联合会(ACLU)也发现了类似的问题。当ACLU将国会议员与犯罪数据库进行匹配时,亚马逊的Rekognition软件对黑人议员的错误识别比白人议员多得多,尽管黑人议员在总体数量中占比更小。其中包括众议院议长Elijah Cummings,一名巴尔的摩人。

对不同肤色人种间识别的准确度差异可能加剧种族歧视的指责,微软和亚马逊都声称,自麻省理工学院和ACLU的报告发布以来,公司已经优化了技术对识别不同种族在准确性方面的差异。但是,更准确地识别有色面孔只是技术需要改进的一部分,因为即使完全准确的技术仍然可以用来支持对有色人种有害的执法措施。

对技术本身的改进和完善并不是最重要的议题,如何使用这项技术才更应该被关注。微软和亚马逊提出的解决方案是在技术应用后对面部识别存在问题进行纠正,但这只是亡羊补牢。

人脸识别执法,可行性存疑

5月初,《华盛顿邮报》报道称,警方正在使用面部识别软件抓捕疑犯。一名目击者向警方描述了嫌疑人的外貌,警察据此画出草图上传到亚马逊的Rekognition,并最终逮捕了某人。这一事件震惊了国会听证会上的专家——提交给数据库的草图竟可以被当做逮捕嫌疑人的充分依据。

对此,亚马逊网络服务首席执行官Jassy称,亚马逊从未收到对警方误用技术的投诉。就在今年5月,亚马逊股东投票否决了一项禁止向警方出售Rekognition的提案。亚马逊的一位代表在一份声明中说,「亚马逊从未收到过任何公众投诉,而且地方机构在使用Rekognition方面没有任何问题。」

立法者&制造商:把「危险的」人脸识别关进笼子

为了平衡人脸识别技术的回报与风险,华盛顿州、马萨诸塞州、奥克兰市以及美国立法机构提出了一系列监管建议。众议院监督和改革委员会的共和党人和民主党人举行了几个小时的听证会,并表示两党愿意共同努力来规范这项技术。

Face API和Rekognition软件的制造商微软和亚马逊也对联邦监管表示支持。今年6月,美国排名第一的随身摄录机制造商Axon同意其道德委员会的建议,即不要让Axon相机配备面部识别装置。

去年,微软总裁Brad Smith呼吁各国政府「立法来规范这项技术」。而亚马逊网络服务公司首席执行官Andy Jassy在6月份表示附和,他将这项技术比作一把刀。这位来自世界上最强大的面部识别技术公司的高管想表达:这个东西很危险。

但在呼吁监管方面,微软和亚马逊采取了一个巧妙的伎俩:他们没有就面部识别是否应该被广泛应用进行辩论,而是在讨论这一技术应该如何被应用。

亚马逊在《大西洋月刊》上发表的一份声明中表示,它正在与研究人员、立法者及其客户合作,「了解如何最好地平衡面部识别的益处和潜在风险」,并指出Rekognition具有多种用途,包括打击人口贩卖并找到失踪人员。微软重申Smith的声明,表示支持面部识别法规的建立,包括施行针对滥用行为的规范,以及获得被识别对象的许可。

但一些隐私专家认为这些公司别有用心。罗切斯特理工学院哲学教授Evan Selinger指责微软和亚马逊试图「遏制强有力的监管」。他认为,这些公司努力推动联邦层面的监管,是因为全国性的法律通常代表着底线,与地方性法律相比,它们不太可能对私营公司如何使用该技术进行限制。

目前看来,学术伦理和技术盲区的问题正在逐步解决,人脸识别的「狂奔」之路并不会因此减速。在人脸识别技术大范围应用之前,这可能是我们拥有自己面孔的最后时光。

终有一天,我们的脸将不再属于我们,但在此之前,我们对这项技术的了解决定了我们会成为受益者还是受害者。当科技公司不断地缩小问题的讨论范围,将公共治理转变为服务条款协议,我们能做的,就是在一方设定条款的时候,不要当不感兴趣的另一方,只会简单地说:「我同意」。