为了防止用户自杀,Facebook 想了 3 个办法

根据世界卫生组织的一份报告,每年约有 800 万人因自杀而死亡,每 40 秒就有一人自杀死亡,而社交媒体上的自杀、自残等潜在暴力危险内容,正在加剧这种状况。

因此,昨天的世界预防自杀日,Facebook 公布了一系列措施,来帮助那些有自杀或自我伤害倾向的人,并最大程度避免其他人受其影响。

这是 Facebook 联合美国、英国、加拿大、墨西哥、菲律宾、印度、泰国等多国的相关专家研讨后得出的方案,Facebook 还专门雇佣了一名健康专家来加入安全政策团队,专门分析 Facebook 政策和应用对人们心理健康的影响。

▲ 图片来自:washingtonexaminer

首先,人们在 Facebook 和 Instagram 上,将不能再把自我伤害的图片分享和传播,相关内容也很难在 Instagram 上搜索到,Facebook 更不会让这些内容出现在推荐里。

而且,跟饮食失调相关的内容也会被禁止,包括与不健康减肥相关的术语,侧重于描绘肋骨、颈骨、肩胛骨、凹陷的胃、突出的脊柱等等信息。

平台上还会出现一个「敏感度屏幕」,就是当有潜在危险图片出现时,用户可以选择看或不看,以避免人们在无意中看到让人不安的图片,造成心理伤害。

另外,Facebook 还第一次尝试从平台上分享「人们如何谈论自杀」的公共数据,这是通过社交媒体监控工具 CrowdTangle 来实现的,它一般为学术研究人员提供,而现在可以让专家机构和学术研究院来发现 Facebook 和 Instagram 上的不良信息,然后对信息进行研究,对用户进行监督和干预。

▲图片来自:wraltechwire

不过从另一面来看,人们在社交媒体上公开讨论自己的情况,并得到网民、家人、朋友的关注,也有益于他们对他们的自杀心理进行疏导。

但在互联网上发声并不等同于在日记本上记录,一段冲击力极大的文字或图片,可能引发大规模的群体效应,科学研究也证明了自杀可能具有传染性,群体自杀爆发是会发生的真实情境。

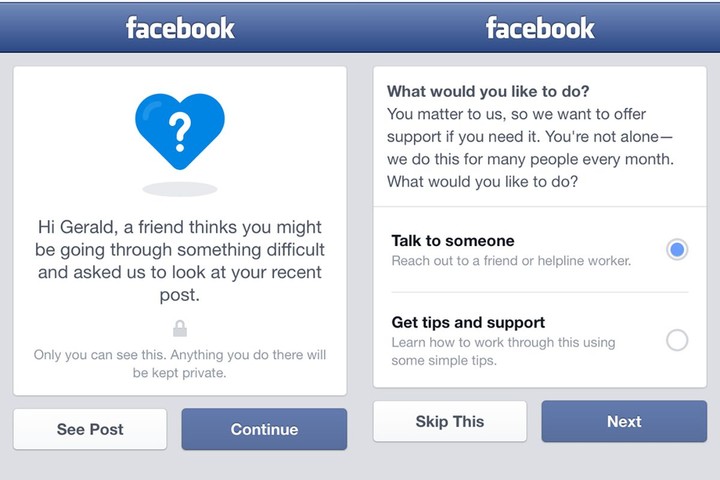

▲ 图片来自:Getty Images

所以从 2019 年 4 月到 6 月,Facebook 的工作人员就通过机器学习系统加人工审核,对超过 150 万件自杀和自伤内容进行了移除或模糊处理,并在用户报告之前发现了超过 95%的自杀和自伤内容。

同一时期,他们在 Instagram 上也对超过 80 万条此内容进行了介入,有时还会将把心理健康内容发给创建自杀内容的个人,或在危急情况下,向用户所在的地方当局发出警报。

但为了让有自杀自残倾向的人们有一个表达和倾诉的渠道,并能听到如同朋友和家人一般的意见,Facebook 最后还将在安全中心和 Instagram 上加入一个名为 #chatsafe 的在线交流指南平台。

这个指南平台是由年轻人来制定的,他们对这些敏感话题更有切身的认知。当有人搜索自杀自残等内容时,就能看到里面的内容资源获得帮助,这也会为那些有自杀想法、行为或相同感受的人建立更多心理上的支柱,并能在线进行交流和开导。

其实不止 Facebook,其他大型公司如 YouTube 和 Twitter,也面临着来自立法者和用户的舆论压力,要求他们严厉打击来自其平台的有毒内容。

所以本月,YouTube 表示已经禁止超过 17,000 个帐户传播「仇恨内容」;而 Twitter 针对其认为违反其用户协议的内容,推出了一系列新政策变更;Facebook 除了昨天的新动向,早在 2017 年 11 月 就开始在全球范围内推出 AI 预防自杀工具,以保证第一时间响应发布自杀帖子的用户。

▲ 图片来自:Derzsi Elekes Andor

在 Google、Facebook 、Twitter、百度各自的平台上,也设置了求助热线号码,当人们搜索「自杀」一词,号码就会在页面第一列位置快速出现。

无论是为了让互联网环境更加健康,还是要保持自身平台保持长期发展,对这些科技大公司来说,保护用户安全怎么都不为过。

题图来自:Techworm