为什么你拍不出真实的北京沙尘暴?

北京天气的异常,可能朋友圈和微博都要比天气预报快速和准确。

不论晴朗、朦胧灰还是是最近的末日黄,我都可以在朋友圈、微博上一睹首都四环内外的异常天色。

▲ 沙尘暴中的角楼(效果很夸张). 图片来自:朋友圈

就拿最近的「沙尘暴」来说,早上醒来,刷个朋友圈,虽身处湿热的广州,但从屏幕中的图片里我依然能体会到,被漫天黄沙逼到街边角落北京朋友们的处境。

这场被称为「十年来最严重的沙尘暴」,算是近几年相当严重的恶劣天气状况,也算是一个值得记录的时刻。智能手机影像的进步,让每一个普通人都有机会成为「历史」记录者。

倘若倒退十年的话,再大的沙尘暴,没有影像没有互联网的话,也很难让我产生共情。

不过,纵观朋友圈内的照片,所呈现的「沙尘」天气有着些许的色差,有拍出「末日黄昏」的橙红色,有拍出寂静岭里「白雾重重」的景象,仿佛住在不同的平行时空,享受着不同的沙尘。

▲ 图片来自微博@奶爸小张

而朋友圈内还有摄影爱好者,趁机放出教程,如何用手机拍出「真实的北京」。里面最为重要的一步就是将拍摄模式切换为专业模式,调整色温,也就是「摆脱 AI 算法」的控制,夺回控制权。

按照这个教程,把色温拉高,调整到 8000K 之后,随手拍了一张照片,倘若空气再差一点(或者来一场大雾),绝对就有沙尘暴的味了。

人们一直想把拍照这件事变得简单

不论是从胶片时代走来,还是从数码时代入坑。纪录影像的工具一直在朝着自动化方向发展,从机械到电子,从 35mm 胶片到 CMOS 成像,自动过片、自动对焦、自动曝光等等,这些技术的出现都是想让人们从复杂的测光、曝光程序中解放,把所有的精力放在记录、创作和表达上。

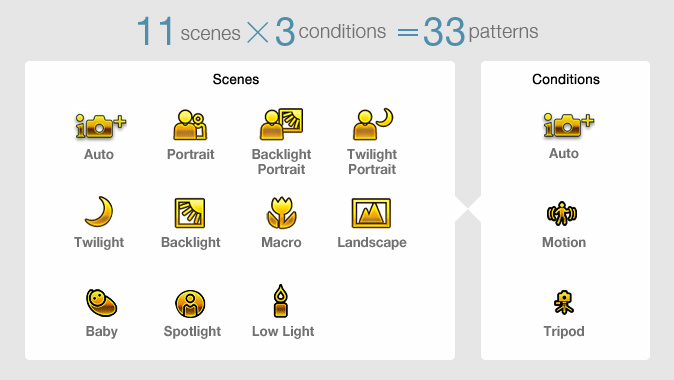

相机全面电子化之后,基于算法的识物功能,其实早就出现在相机上,比如曾经索尼的高级自动模式(也就是金相机模式),它会做很基本的场景识别,对直出进行优化,之后又被移植到 Xperia 手机之上。只不过当时的识物算力比较有限,最终的成像效果区别不大。

随着移动影像的发展,拍照的门槛再次降低,几乎唾手可得。但由于体积受限,和物理光学的限制,智能手机们只去跟随传统光学厂商脚步,想要在影像方面实现弯道超车,几乎是个不可能完成的任务。

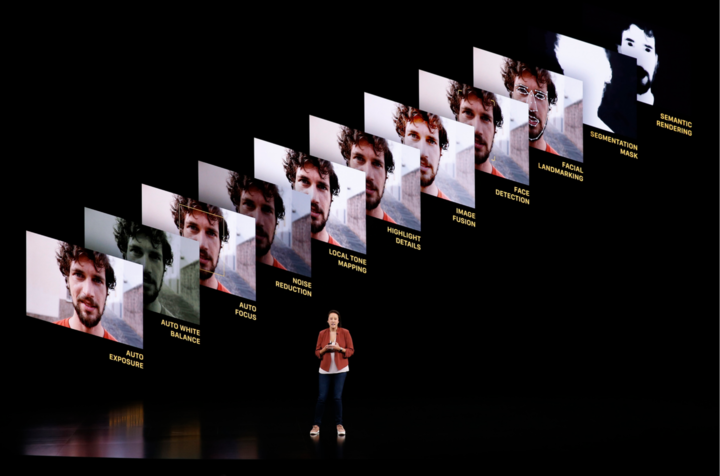

智能手机们扬长避短,发挥出了自己在芯片领域的优势,发展出「计算摄影」这一新流派。它的思路并不违背影像发展的大潮流,同样遵循「把拍照变得简单」。

简单说,智能手机们利用芯片的 AI 算力,在识物、识景、多帧降噪、合成等等方面去针对性的优化传感器捕捉到的图像。随着技术的不断推进,AI 调色的功力也愈发深厚,对照片的把控也更为深入。从一开始的大刀阔斧,渐渐变成润物细无声,愈发细腻。

如今,你只要稍微懂一点构图和光影,用智能手机就很容易拍出很不错的照片。AI 对图像处理介入的越深,人们获取照片也愈发简单,而其中的快乐也就被越来越多的人感受到了。

「AI 增强」会是一把双刃剑吗?

但,随着 AI 们对照片调整的权限变大,它也引发了一些争议。

拍不出沙尘暴真实的颜色,只是我个人的观察。AI 是在依据程序内的算法去调整,当识别出天空后,会调用「蓝天」这个固有算法。这个算法简单来说会让天更蓝、空气更透彻,黄色的反色相就是蓝色,一遇到橙黄色的沙尘暴就被「优化」成了颜色寡淡的白雾。

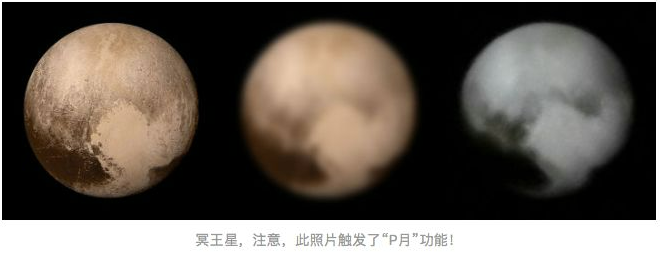

其实这还只是比较初级的变化,不过只是改变了一下色相、白平衡,对图片本身并没有影响,而且这种效果在一些相机中也会存在。对于 AI 增强模式争议最大的其实还是曾经的「月亮事件」,以及各种软件上的「美颜算法」。

争论的核心都是「拍」还是「画」,「真」还是「假」,是无中生有,还是锦上添花。

▲ 图片来自:知乎@小城

以月亮事件为例,实则是为了保证长焦能拍出人人都喜欢的月亮,AI「用力过猛」,在识别类似月球的景物时,会自动优化处理,甚至还会添两笔,让你的照片中出现环形山、环形坑。

而拍月亮这个其实跟近年来不少软件的「美颜」有很大的类似,过渡的美颜算法,可以让大妈变少女,猛男变娇妻,且这类美颜滤镜也伴随着很多的「诈骗」相关联。

这两类 AI 用力过渡的例子,都有些让人反感,上升到「欺骗」的层次。但,遇到相同的场景,我仍然还是会打开 AI,让它给我一个「月亮」,或者给我一张无痕无胡的脸庞。

追求还原「所见」,是摄影领域一个原则性的底线。不论你去创作什么,都应该以真实出发。后期元素过多,也就会渐渐摆脱摄影作品的范畴。世界摄影大赛中,很多是不允许对照片进行过渡的后期,要的就是记录感。

对于普通人的我们来说,要的就是用最简单的设备,最简单的步骤去拍出一张很好看的照片。且拍出的照片也多是用于社交网络分享,分享自己想分享的「所见」,到底是否真实反而没有那么重要了。

可能对于摄影师、或者摄影爱好者来说,AI 增强它会对图片介入过多,丧失了对照片的全局把控,难以匹配到你想记录的场景。

但智能手机里的 AI 增强对于普通人来说,它是一个降低拍照门槛的辅助性工具,让更多的人能够参与进来,把它从一个小众群体的活动变成了大众的娱乐。

快速向前的 AI 拍照模式,是否是一把双刃剑,还是要看我们如何去使用它。这就好似 DC 宇宙中的「母盒」,它是则是,在达克赛德手中它就是一个毁灭武器,而在钢骨手中,它便可成为复活超人的关键物。

如正义联盟中的英雄们一样,对于母盒,他们知之甚少。我们现在对于 AI 拍照模式也处于摸索之中。

为什么拍不出「所见所得」?

简单回答,就是 AI 还不够强。

对于蓝天,对于鲜花,对于夕阳,AI 们会依据特定的算法去优化,锦上添花也好,无中生有也罢,最终得到的都是我们脑海中那般空净、艳丽、浓郁的图片。但对于「沙尘暴」这种极端天气,AI 们没有一个标准答案去优化,以至于出现了「负优化」。

曾经雾霾肆虐时,各大厂商,甚至 Adobe 旗下的 Photoshop、Lightroom 都推出了相应的去霾的功能,在照片里还给你一片蓝天。倘若沙尘暴再来几次,相信不久后也会有「去沙」或者「银翼杀手」滤镜出现吧。

除了对特定的环境无法针对性优化外,现在还处于初级阶段的 AI 拍照模式,算法比较接近,产出的照片风格也比较接近,没办法去突出风格化。

另外,AI 拍照模式远不够智能,暂时还无法自主学习,去学习每个人拍照的喜好、后期的喜好,利用本机的大数据去针对性优化。比如,我喜欢拍高对比、低色彩、曝光稍低的风格,那在拍摄时,利用 AI 拍照模式可以直接产生类似的风格,这应该会是 AI 或者说计算摄影后续发展的一个大方向。怎么说,用相同的设备,创作出不同的结果才是高级的玩法。

每个人的「所见」都有着很主观的意愿在里面。相同的场景,不同的心情,可能想去呈现的画面也会不同。也许在未来的某一天,你发现手机 AI 拍照模式能够八九不离十的猜出你想呈现的风格,那再刷朋友圈,可能就不会有人再用《银翼杀手》的剧照来充当北京沙尘暴的场景了。