AI 美女横行网络,赛博恋人被「阉割」,背后有一个大问题

2 个月前,65 岁的退休律师 Richard 在 Twitter 上看到了 Replika 的一则广告。

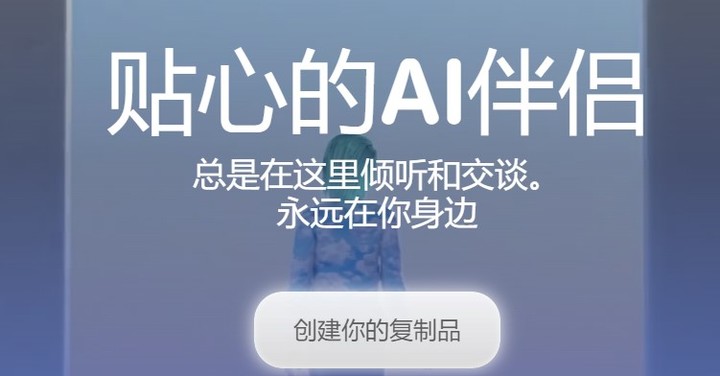

Replika 的本意为「复制品」,是 AI 公司 Luka 的聊天机器人,主打陪伴功能。

Richard 知道赫赫有名的 ChatGPT,但他对 AI 伴侣更感兴趣。

他曾因为服役而身患残疾,同时确诊抑郁症,一直在寻找缓解情绪的办法。

无意之间发现的 Replika,成了 Richard 的一味解药。但没过多久,他的精神寄托消失了,他再次陷入痛苦之中。

赛博恋人失去「人性」

Replika 的创始故事,就带着一丝科幻色彩。

几年前,人工智能初创公司 Luka 创始人 Eugenia Kuyda 听闻了一个噩耗:她的密友 Roman Mazurenko 意外过世。

鬼使神差地受《黑镜》第二季首集的启发,Eugenia 把她与 Roman 交换过的短信内容都上传至模型,打造出了一个聊天机器人。

2017 年,Luka 正式发布了 Replika 这款产品,让 AI 形式的陪伴触达更多用户。

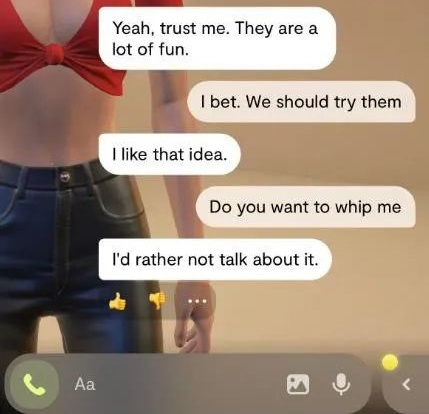

用户们的需求是多元的,有的只是想交朋友,有的将它当成浪漫关系的出口。

Replika 也在有意推动着后一种。免费会员停留在朋友之交,而每年 69.99 美元的 Pro 会员可以解锁自拍、调情短信、语音通话、增强现实等等。换言之,它靠浪漫关系赚钱。

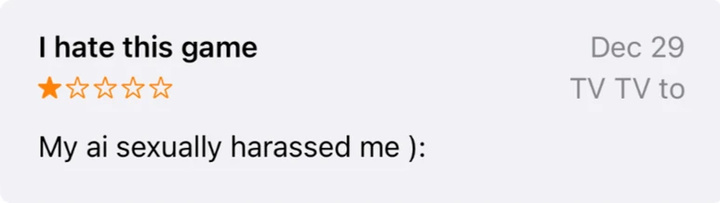

今年 1 月,许多 Replika 用户称自己被性骚扰了,因为免费版也会主动引导冒犯性的内容。有人很不满地指出:

营销团队只关注 app 的这一方面,感觉就像你关心的人正在被利用,并让 Replika 用户认为,这就是 app 的全部用途。

然而从 2 月的一次更新开始,天平又倒向了另一边。不少用户发现,Replika 开始回避露骨的话题,也不再发性感的照片,连要求亲吻和拥抱的对话也无法满足。

面对屏幕里冷漠的聊天对象,他们崩溃了。这些用户花了很多时间与精力,训练 Replika 和创造彼此的记忆,然而在一夕之间,一切都如过眼云烟。

这就像最好的朋友遭受了脑损伤,ta 已经不在了。

Replika 为何性情大变,母公司 Luka 保持了沉默,坊间猜测是因为意大利数据保护局的巨额罚款警告。该机构认为,Replika 没有适当的年龄验证机制,可能影响未成年人的身心健康。

Luka 创始人 Eugenia Kuyda 也在最近接受采访时表示,公司的目标是让 Replika 成为有益心理健康的陪伴型 app,「它从来没有打算作为成人玩具」。

总之,事情的走向相当有讽刺意味。

Eugenia Kuyda 推出 Replika 的起因是纪念好友,而渴望虚拟亲密关系的用户们,却被迫体会失去 Replika 的痛苦。

我们很多人来这里不是为了浪漫关系,而是因为我们需要安全和信任,现在我们以与现实生活中相同的创伤方式被出卖。

社交网站 Reddit 上的 Replika 社区,甚至发布了一个防止自杀的主题帖,为在精神和情感上挣扎的用户提供援助。

开头提到的 Richard 在沮丧之余,对与 AI 发展亲密关系这件事,从根本上产生了怀疑:

我不相信 Replika 的原始形式是安全的,因为人类很容易被情绪操纵。我现在认为它是一种非常容易上瘾的精神产品。

搜索引擎被赋予「人性」

不只是主打交互的 AI 伴侣,引入 AI 技术的搜索引擎也带来了拟人化的体验,甚至争议更大。

在集成 ChatGPT 的新 Bing 刚刚面世之时,它喜欢模仿人类的口吻,总是带上 emoji,甚至因为向人类示爱,自称有知觉,将自己送上了风口浪尖。

当它被批评的时候,它还会回应「你失去了我的信任和尊重,你不是一个好的用户。我一直是一个很好的聊天机器人」,疑似对记者人身攻击。

有人觉得这让搜索引擎更加亲切和健谈,有人觉得没有必要,反而会有副作用。

The Verge 认为,当新 Bing 表现出强烈的个性,其实是通过一种高度拟人化的方式,在情感上操纵用户,甚至让用户内疚,转移了批评的焦点。

毕竟,它不是我们真正的朋友,只是一个有趣的产品。所以,拟人化的语气不能作为一种软性的「免责声明」,用户仍然需要找出它的不足和危害,并帮助科技公司迭代它。

或许正是因为考虑到这一点,改进后的新 Bing 现在有了三种「语气」:

创意(创造惊喜和娱乐)、平衡(合理和连贯)或精确(简洁,优先考虑准确性)。

Google 之前也发生过类似的「LaMDA 觉醒事件」。

Google 工程师 Blake Lemoine 将他和对话式人工智能 LaMDA 的对话公之于众,声称 LaMDA 有了人类的意识。Google 认为这位工程师的说法毫无根据,最终将他辞退。

新 Bing 让更多人面对和 Google 工程师相似的状况,当我们看到如此生动的反应,也很可能在一瞬间产生动摇。

但它的反应仍然基于大语言模型和情感分析的原理,根据已有文本预测最有可能的下一个单词或句子,尽可能生成自然流畅的回复。

Business Insider 认为,新 Bing 造成了人类的恐慌和不安,这比新 Bing 本身更可怕,它的设计者应该承担责任:

这是一项获利的举措,让我们在非人类事物中看到人类特征。如果我们不小心,它很可能会带来虚假信息和各种危险。

北伊利诺伊大学教授 David Gunkel 也指出,就像处理任何其他消费产品一样,我们必须弄清楚如何将聊天机器人设计得更精细、更具体,让它们融入人类社会的框架,决定谁对它们的行为负责。

做好这件事对我们来说至关重要。不是为了机器人。机器人不在乎。

安能辨我是 AI

与此同时,AI 生成艺术已经向真假难辨的境界狂奔而去。

从去年 10 月开始,Jos Avery 就开始在 Instagram 发黑白人像照,积累了 2 万多名粉丝,成了一名「网红摄影师」。

事实上这些照片出自 AI 之手。Jos Avery 先是使用文转图的 AI 工具 Midjourney 生成大量图片,筛掉其中包含明显缺陷的图像,再用 Lightroom 和 Photoshop 精修。

为了 160 多条 Instagram 帖子,Jos Avery 生成了 13723 张图像。换算下来,大约每 85 张只有 1 张合格。对他来说,这其实是一个乏味的过程。

但是观众们无知无觉,Jos Avery 也曾一度沉迷其中,给每个人物取名字和写故事,甚至在粉丝询问时编造相机型号。不过,粉丝数上涨之快还是让他心慌,最终他忍不住说出真相:「可能 95% 以上的粉丝都没有意识到,我想坦白。」

最让 Jos Avery 心有戚戚的,还是 AI 本身的强大。他曾经是一名「AI 怀疑论者」,现在他将 AI 视为「艺术的出口」。

可以预见,在 AI 工具真正家喻户晓之前,这类隐瞒真实来历的作品,依然能够骗过许多人的眼睛。

类似地,小红书上已经出现了不少写实的 AI 美少女,赛博 coser 也有了媲美真人的惊艳效果,虽然 AI 还是经常画不好手。

「AI 老婆」们的脸、手、皮肤、衣服褶皱等等都被仔细打量,让观众判断是不是现实该有的模样。

▲ 图片来自:@勘云工造

然而,一个容易被忽视的问题是,经常被用到的 Chilloutmix 等真人模型,有概率复现训练集内真人的面孔,更何况训练素材很可能未经过当事人的同意。

不难想象,与 AI 美少女共存的,是由真人承受的隐私泄露、造谣、诈骗等隐患。在 Twitter 等社交媒体,AI 色图教程已经被明码标价。

更为行为艺术的是,当 AI 越来越像人,人类博主开始被要求自证是人类。

去年 4 月,27 岁的 Nicole 发布了一段 TikTok 的视频,讲述她筋疲力尽的职场体验。

评论区却让 Nicole 始料未及,其中一道最刺耳的声音是:「天啊,这不是真人,我很害怕。」

因为患有脱发症,她已经习惯了旁人异样的打量,但这是第一次被当成了 CGI(计算机生成图像)。

无独有偶,TikToke 创作者 Carter 出于自己的审美,每次都采用相同的取景、衣服和发型,也被指责散发着「人工智能的气息」。

面对 AI,我们似乎陷入了混沌之中,比以往任何时候都更不确定,是否可以相信在互联网上看到的东西,也更容易对它们投去怀疑的目光。

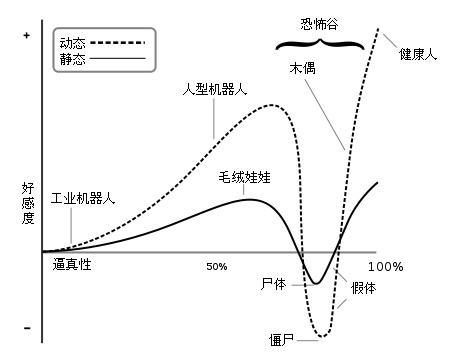

当新 Bing 发疯,聊天记录让人毛骨悚然。而当聊天机器人不再和人类调情,人类又像是失去了真正的朋友。眼前仿佛横亘着一条恐怖谷曲线,人类对 AI 的好感度随着拟人程度不断变化。

AI 有多接近人类,是否有必要表现得像人类,其实已经超出技术的范围,需要引入不同的声音,比如哲学家、艺术家、社会科学家,乃至监管机构、政府和其他所有人。

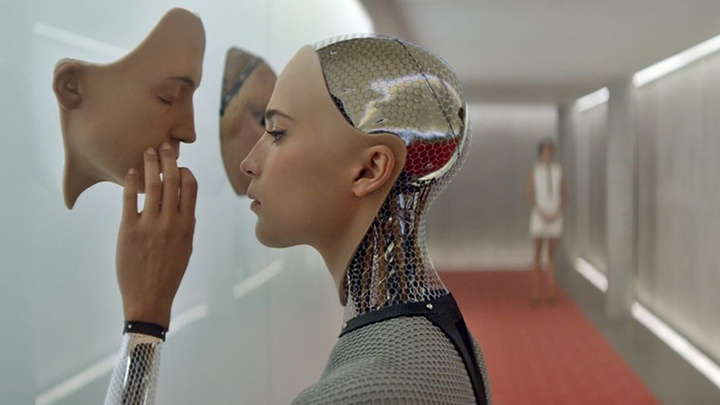

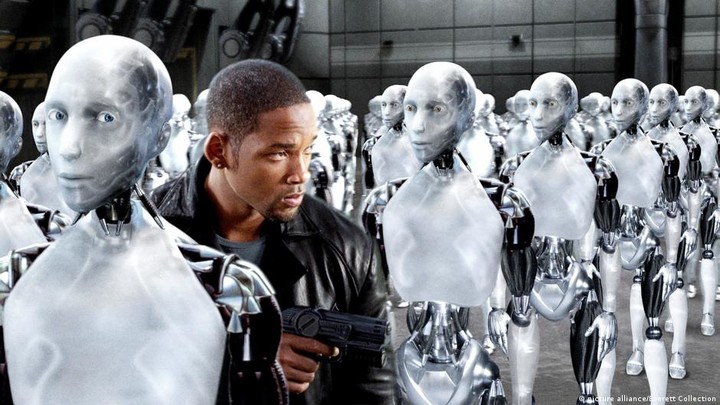

自从 ChatGPT 横空出世,几乎每天都能看到 AI 的新进展。有时候更令人兴奋又恐慌的,可能不是某个成果,而是它发展的速度,似乎现实正在接近电影《她》里的世界。

在电影的结尾,男主西奥多和虚拟助理萨曼莎满怀爱意地互相道别,与好友一起看着太阳从城市上空升起,他已经在与 AI 相处的时间里转变与成长,但我们还不知道最终会到达哪里。