小米突然发布新模型:媲美 DeepSeek-V3.2,把手机的性价比卷到 AI

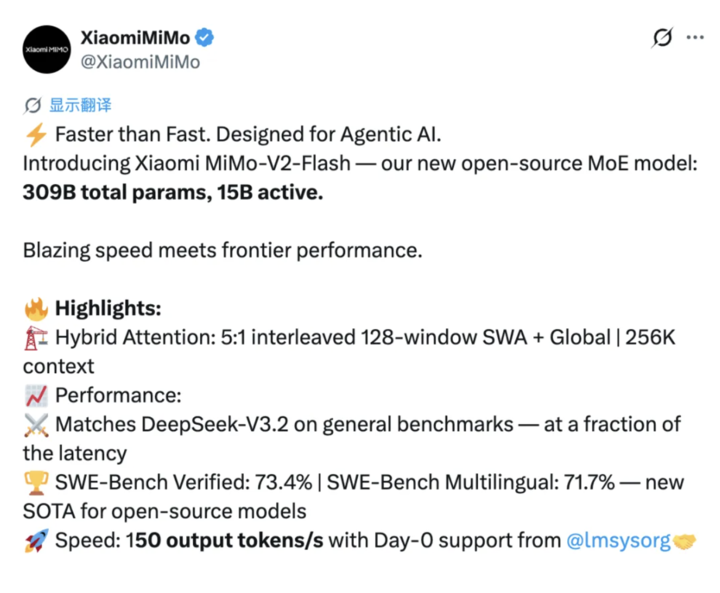

开源模型再次迎来一位重磅选手,就在刚刚,小米正式发布并开源新模型 MiMo-V2-Flash。

MiMo-V2-Flash 总参数 3090 亿,活跃参数 150 亿,采用专家混合架构 (MoE),性能还能和 DeepSeek-V3.2、Kimi-K2 这些头部开源模型掰掰手腕。

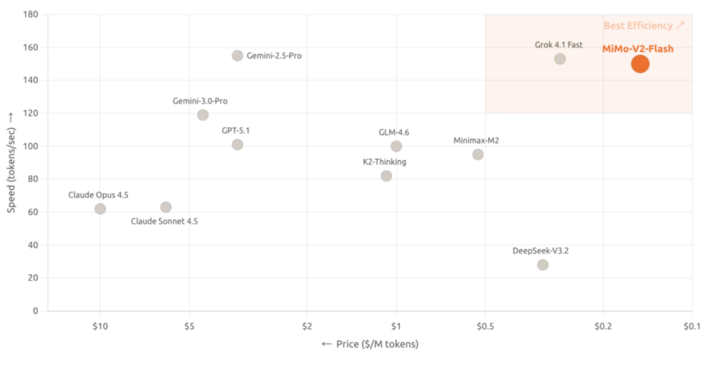

此外,MiMo-V2-Flash 采用 MIT 开源协议,基础版权重也已经在 Hugging Face 上发布,除了开源,新模型真正的杀手锏在于架构设计上的激进创新,把推理速度拉到了 150 tokens/秒,成本压到了每百万 token 输入 0.1 美元、输出 0.3 美元,主打一个超绝性价比。

从官方提供的页面来看,MiMo-V2-Flash 支持深度思考和联网搜索功能,这意味着它不仅能写代码、解数学题,还能实时获取最新信息。

附上AI Studio 体验地址:

http://aistudio.xiaomimimo.com

开源模型新标杆,SWE-Bench 霸榜开源第一

老规矩,咱们先来看看 MiMo-V2-Flash 的跑分环节。

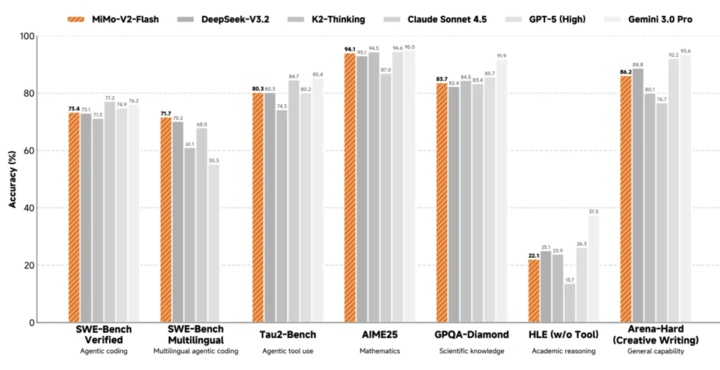

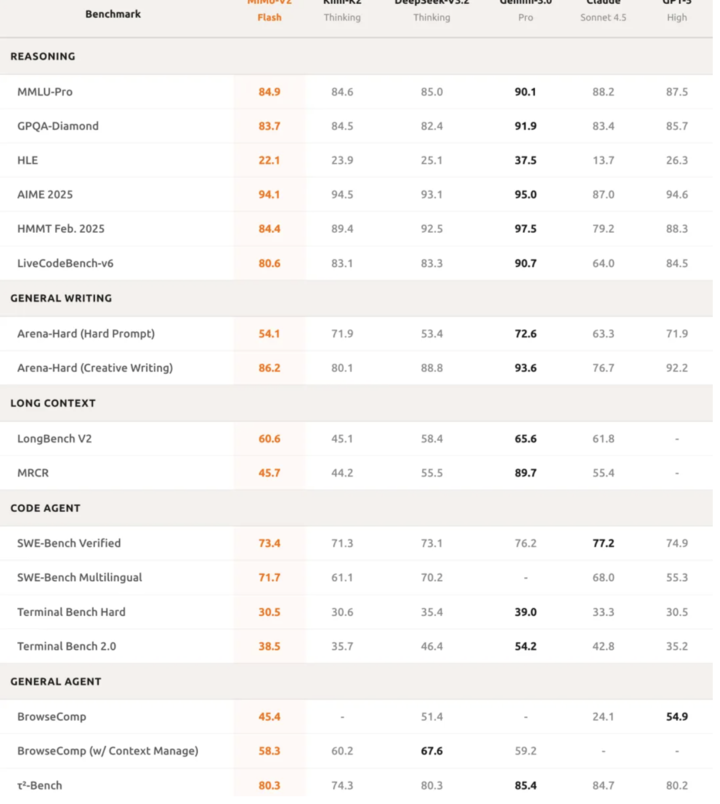

在数学推理方面,AIME 2025 数学竞赛和 GPQA-Diamond 科学知识测试中,MiMo-V2-Flash 都排在开源模型前两名。

编程能力更是亮眼,SWE-bench Verified 得分 73.4%,超越所有开源模型,直逼 GPT-5-High。做个简单科普,这个测试是让 AI 去修真实世界的软件 bug,73.4% 的成功率意味着它能搞定大部分实际编程问题。

多语言编程基准测试 SWE-Bench Multilingual 解决率 71.7%,智能体任务上,MiMo-V2-Flash 在τ²-Bench 分类得分中,通信类 95.3 分,零售类 79.5 分,航空类 66.0 分。

BrowseComp 搜索代理得分 45.4,启用上下文管理后直接飙到 58.3。

这些数据说明,MiMo-V2-Flash 不仅会写代码,还能真正理解复杂任务逻辑,执行多轮智能体交互。长文本能力也没拉胯,实测表现甚至超越了体量更大的 Kimi-K2 Thinking,证明混合滑动窗口注意力架构的长程建模能力确实强悍。

写作质量也接近顶级闭源模型,这意味着 MiMo-V2-Flash 不只是个工具,还能当个靠谱的日常助手。

长文本性能不打折,成本降 6 倍的秘密

MiMo-V2-Flash 最核心的创新是混合滑动窗口注意力。

传统大模型处理长文本时,全局注意力机制会导致计算量二次爆炸,存储中间结果的 KV 缓存也跟着飙升。小米这次采用了 5 比 1 的激进比例,5 层滑动窗口注意力搭配 1 层全局注意力交替使用,滑动窗口只看 128 个 token。

(考虑到有朋友不太了解 AI,简单科普一下:「token」(中文常译作「词元」)在大模型/自然语言处理里,指的是模型读入和输出文字时使用的最小计数单位。模型并不是按「一个汉字=1、一个英文单词=1」这样固定地数,而是把文本切成一段段 token 来处理。)

简单说就是,模型不用每次都看全部内容,只看最近 128 个 token,偶尔看一次全局,这样计算量和存储都能大幅下降。这种设计让 KV 缓存存储量直接减少了近 6 倍,但长文本能力却没打折扣,最长支持 256k 上下文窗口。

关键是小米还整了个「可学习的注意力汇入偏置」,其的用是让模型即使在这么激进的窗口设置下,照样能稳住长文本性能。

罗福莉在社交平台上特别强调,窗口大小 128 被证明是「最佳数值」,而 512 反而会导致性能下降。这个发现挺反直觉的,你会觉得窗口越大越好,但实际测下来 128 才是甜点。另外,sink 值(attention sink values)必不可少,绝对不要省略它们。

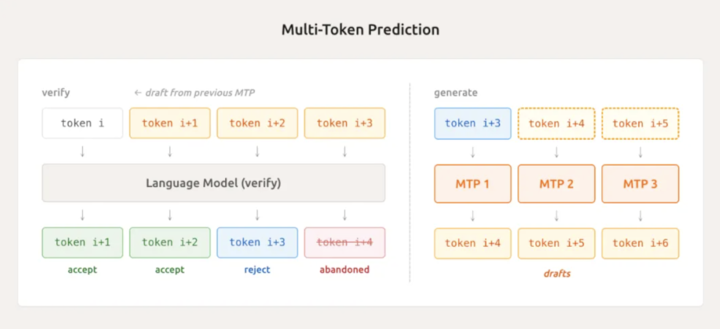

另一个黑科技是轻量级多 Token 预测 (MTP)。

传统模型生成文本时一次只能吐一个 token,就像打字员一个字一个字敲。MiMo-V2-Flash 通过原生集成的 MTP 模块,能并行预测多个 token,一次性猜出接下来好几个 token。

实测平均能接受 2.8 到 3.6 个 token,推理速度直接提升 2 到 2.6 倍,不仅在推理时管用,训练阶段也能加速采样,减少 GPU 空转,属于一箭双雕。

罗福莉提到,在三层 MTP 设置下,他们观察到平均接受长度超过 3,编码任务速度提升约 2.5 倍。它有效解决了小批量 On-Policy 强化学习中「长尾样本」带来的 GPU 空闲时间浪费问题。

啥叫长尾样本?就是那些特别难、特别慢的任务,拖着其他任务一起等,GPU 就在那干瞪眼。MTP 把这个问题给解了,效率直接起飞。

不过罗福莉也坦诚,这次因为时间紧迫没能把 MTP 完整集成进 RL 训练循环,但它与该流程高度契合。小米已经把三层 MTP 开源了,方便大家在自己的项目中使用与开发。

算力只用 1/50,性能如何不打折?

预训练阶段,新模型使用 FP8 混合精度,在 27 万亿 token 数据上完成训练,原生支持 32k 序列长度。

FP8 混合精度是一种压缩数值表示的技术,能在保持精度的同时减少显存占用和加速训练。这种训练方式在业界并不常见,需要对底层框架进行深度优化。

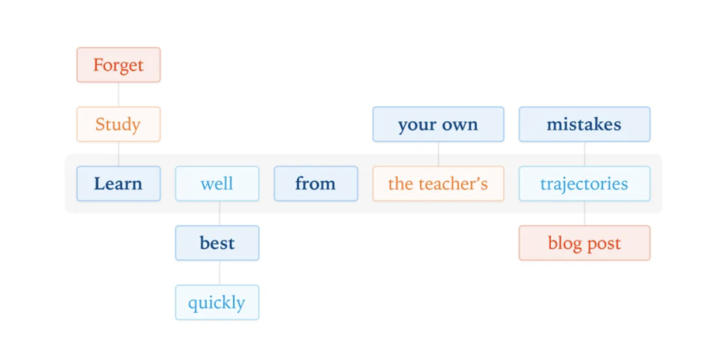

而在后训练阶段,小米整了个大活,提出了多教师在线策略蒸馏 (MOPD)。

传统的监督微调加强化学习管线,不仅训练不稳定,算力消耗还贼高。MOPD 的思路是让学生模型在自己的策略分布上采样,然后由多个专家教师在每个 token 位置提供密集的奖励信号。

通俗点说就是,学生模型自己写作业,老师在每个字上都给评分,不用等写完整篇才打分。这样一来,学生模型能快速从教师那里学到精髓,而且训练过程稳定得多。

最夸张的是效率提升,MOPD 只需要传统方法 1/50 的算力,就能让学生模型达到教师性能峰值。这意味着小米能用更少的资源,更快地迭代模型。

而且 MOPD 支持灵活接入新教师,学生模型成长后还能反过来当教师,形成「教与学」的闭环自我进化。今天的学生,明天的老师,后天又能教出更强的学生,套娃玩法属实有点东西。

用罗福莉的话来说,他们借鉴 Thinking Machine 的 On-Policy Distillation 方法,将多个强化学习模型进行融合,结果带来了惊人的效率提升。这为构建一个自我强化循环系统奠定了基础,学生模型可以逐步进化,最终成为更强的教师模型。

在智能体强化学习扩展上,小米 MiMo-V2-Flash 研究团队基于真实 GitHub issue 构建了超过 10 万个可验证任务,自动化流水线跑在 Kubernetes 集群上,并发能开 10000 多个 Pod,环境部署成功率 70%。

针对网页开发任务,还专门搞了个多模态验证器,通过录制视频而非静态截图来验证代码执行结果,直接减少视觉幻觉,确保功能正确。

对于开发者而言,MiMo-V2-Flash 能与 Claude Code、Cursor、Cline 等主流开发环境无缝配合,256k 的超长上下文窗口支持数百轮智能体交互与工具调用。

256k 是什么概念? 大概相当于一本中等篇幅的小说,或者几十页技术文档。这意味着开发者可以把 MiMo-V2-Flash 直接融入现有工作流,不需要额外适配,拿来就用。

小米还把所有推理代码贡献给了 SGLang,并在 LMSYS 博客分享了推理优化经验。

技术报告公开了完整模型细节,模型权重 (包括 MiMo-V2-Flash-Base) 在 Hugging Face 上以 MIT 许可协议发布。这种全面开源的态度,在国内大厂里属实少见。

目前 MiMo-V2-Flash 已经在 API Platform 限时免费开放,开发者可以直接上手体验。

小米的 AI 野心,不止于手机助手

MiMo-V2-Flash 的发布,标志着小米在 AI 赛道上的全面发力。

罗福莉在社交平台上透露了更多信息,「MiMo-V2-Flash 已正式上线。这只是我们 AGI 路线图上的第二步。」第二步就已经这么猛了,那后面还有啥大招?想想就有点期待。

当然,小米在技术报告中也坦诚,MiMo-V2-Flash 与最强的闭源模型相比仍有差距。但他们的计划很明确,通过扩大模型规模与训练算力来缩小差距,同时继续探索更稳健、更高效的智能体架构。

MOPD 框架下教师模型与学生模型的迭代共进化,也为未来的能力提升留足了空间。

把视角拉高来看,背后是小米对整个 AI 生态的一次战略押注。手机、IoT、汽车,小米的硬件生态需要一个强大的 AI 底座,MiMo-V2-Flash 显然就是小米为全硬件生态准备的那块基石。

就像十年前小米手机用 1999 元重新定义了旗舰机的价格标准,如今 MiMo-V2-Flash 正在用 0.1 美元/百万 token 的成本、73.4% 的 SWE-Bench 得分,重新定义开源大模型的性能标准。

这一次,属于开源模型的「小米时刻」真的来了。

HuggingFace 模型地址:

http://hf.co/XiaomiMiMo/MiMo-V2-Flash

技术报道地址:

http://github.com/XiaomiMiMo/MiMo-V2-Flash/blob/main/paper.pdf