大数据是个什么鬼啦?

关于大数据,有这样一段话:

“Big data is like teenage sex,everyone talks about it,nobody really knows how to do it,everyone thinks everyone else is doing it,so everyone claims they are doing it.”

看完这句话,大家对什么是“大数据”有点概念了吗?目前,大多数人对大数据的概念还停留在:就是海量的数据,PB(1PB=1024TB)级别的,甚至是 EB、ZB 以上的数据,通过对这些数据进行深入分析,就能得出非常有价值的结论,指引企业做出最佳决策。

大数据就是那种每个人都听过,或者看过此类文章,但却不怎么了解的事物。

其实,现在的大数据指的并不仅仅是海量数据,更准确而言是对大数据分析的方法。传统的数据分析,是通过提出假设然后获得相应数据,最后通过数据分析来验证假设。而大数据不是这样的,大数据是从收集的海量数据中,通过算法将这些来自不同渠道、格式的数据进行直接分析,从中寻找到数据之间的相关性。简单而言,大数据更偏重于发现,以及猜测/印证的循环逼近过程。

而大数据的价值体现在对它的分析利用上。一直以来,大数据的瓶颈并不是数据规模巨大导致的存储、运算等问题,而是在前端数据的收集途径,以及对数据进行结构化处理,进而引导后期的商业决策中的模型和算法问题。

各个行业都在产生数据,现代社会的数据量正持续地以前所未有的速度增加着。这些不同类型的数据和数据型,极其复杂,包括结构化、半结构化和非结构化的数据。企业需要整合并分析来自复杂的传统和非传统信息源的数据,包括企业内部和外部的数据。随着传感器、智能设备和社会协同技术的爆炸性增长,数据的类型变得难以计数,包括文本、微博、传感器数据、音频、视频等。

而现在大热的数据分析师正在做的是这样的工作:收集信息,将信息结构化数据化,最后才是我们能看到的大数据带来的神奇力量。但问题是其中对数据进行处理工作量太大了。根据访谈和专家测算,数据分析师的 50%~80% 的时间都花在了处理数据上。

在智能手环公司 Jawbone 负责数据工作的 Monica Rogati 说:

处理数据是整项工作中巨大的部分。但有时我们感到沮丧,因为好像不停地处理数据就是我们做的所有事情。

这听起来有点像冰山理论,即我们能看到的大数据只是冰山露出来的一个小角,而我们看不到的地方,如大数据的前期工作,就是海水下是更巨大的部分。

但咨询公司麦肯锡曾在 2011 的报告中指出:

“数据,已经渗透到当今每一个行业和业务职能领域,成为重要的生产因素。人们对于海量数据的挖掘和运用,预示着新一波生产率增长和消费者盈余浪潮的到来。”

是的,存在问题的地方也潜藏着机会。原始数据的格式和来源不可计数,举一个例子,假如一家食品行业的企业需要进行大数据的收集和分析,它能收集的数据包括产量、出货的位置信息、天气报告、零售商每日销售量、社交媒体评论等。而根据这些信息,企业能够洞察出市场的风向和需求的变化,进而制定相应的产品计划。

的确,获得的信息越多越有利于企业做出明智的决策。但这个决策是建立在不同的数据集之上的,这些来自各种传感器、文档、网页、数据库的的数据,全部都是不同的格式,它们必须要被转换为统一的格式,这样软件才能理解它们,进行分析。

将各类数据进行格式统一是一个严峻的挑战,因为数据和人类语言一样都具有模糊性,有些数据人类知道是什么意思,但电脑却不能识别,因此我们需要人工来一次又一次地重复这个工作。

现在已经有不少的初创公司试图开发相关的技术来减轻这项工作,例如 ClearStory Data,一家在帕洛阿尔托的初创公司,它开发的软件能识别不同的数据来源,将它们整合,并将结果用视觉方式呈现,如图表、图形或数据地图。再如 Paxata,一家加州的初创公司,专注于数据的自动化——发现、清理、调配数据,通过 Paxata 处理过的数据能被送入各种分析或可视化软件工具。

大数据目前的情况和计算机发展的轨迹有点相似。一种先进的技术,最初往往只被几名精英掌握,但随着时间流逝,通过不断地技术创新和投资,这项技术,或者说工具,会变得越来越好。特别是当其融入到商业领域中后,这项工具就能得到广泛应用,成为社会中的主流。

所以我们现在是历史的见证者,看着大数据如何一步步完善,我们都需要掌握或选择一个最佳的分析方法,以更好地挖掘出大数据的价值。

继续探索吧。

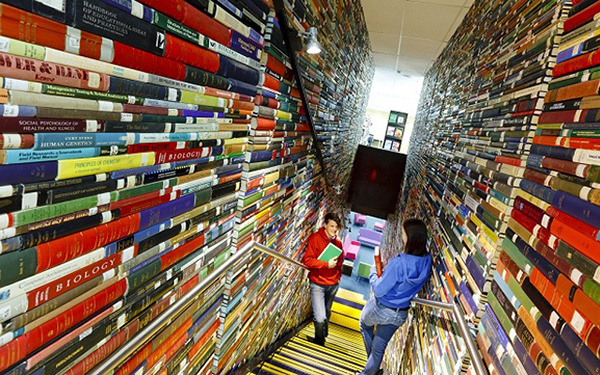

题图来自 Deakin