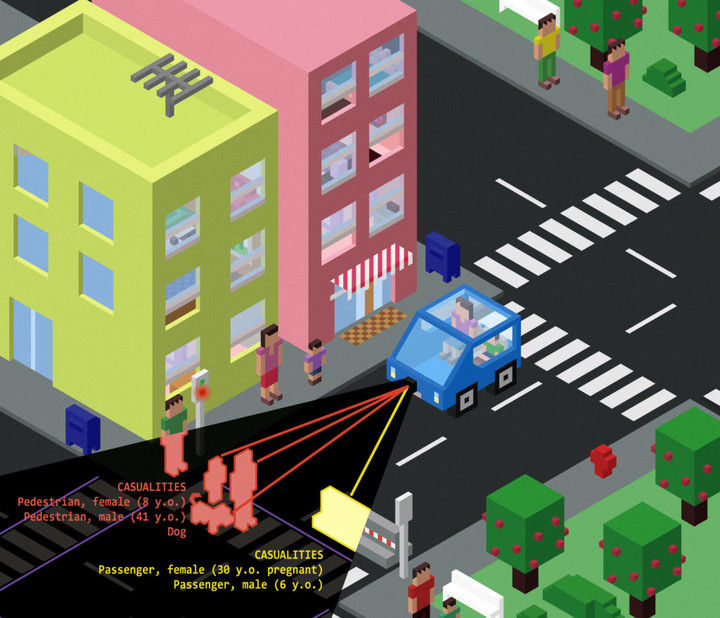

无人驾驶汽车的道德困境:危险时保护行人还是保护车主?

当你的无人驾驶汽车在高速行进中,前方突然出现一个横过马路的小孩。如果要避开他就必须要撞向两边的水泥墙,乘客受伤可能性极高。如果不避让车辆一定会撞上小孩。

这种情况下,无人驾驶汽车系统会做出什么选择?或者说,你希望无人车作出什么选择?

据 The Verge 报道,《Science》杂志最近做了一个无人驾驶汽车道德困境的社会调查,了解人们对无人驾驶汽车在事故中的行动方式的态度。

调查结果显示,受访者认为无人驾驶汽车车主应该选择最小化对他人的伤害,即使会致使自己受伤。但当问及会选择购买“车主保护优先”还是“行人保护优先”的无人驾驶汽车,受访者更倾向于购买“车主保护优先”的。

(图自:inhabitat)

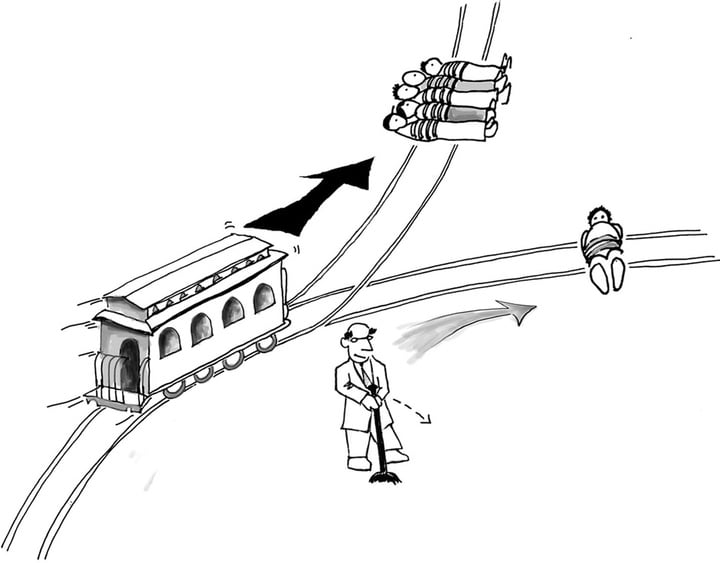

调查者之一、美国加州大学欧文分校的心理学副教授 Azime Chariff 认为,著名的道德悖论“电车悖论”即将无数次在现实中上演。

电车悖论容是:一辆失控的电车前方有五个无法避开的行人,片刻后电车就要碾压到他们。驾驶员可以拉一个拉杆,让电车开到另一条轨道上,但另一个电车轨道上有一个无法避开电车的人。这种状况下,驾驶员是否应该拉拉杆?

(图自:nybooks)

无人驾驶汽车系统的开发者,正是握有这个“拉杆”的人。在无人驾驶汽车面临交通事故时,它的回避动作很可能决定乘客和行人的生死。而究竟让谁的伤害最小化,车辆显然是根据事先的系统设置行动的。

尽管这是一个虚构的场景,但也是无人驾驶技术在全面推广之前无法回避的问题。

(图自:wired)

从功利主义角度看,电车难题根本不算难题:牺牲 1 个人比牺牲 5 个人付出的数量上的代价要低。但结果上看,驾驶员拉拉杆的行为确实导致了另一条车道上那个无辜的人的死亡。而有了人为参与,就会有责任归属。

据 Google 自动驾驶项目公布的试乘结果,大部分的 Google 自动驾驶汽车事故都是被追尾。在这个场景下,如果把无人驾驶汽车系统设置为“伤害人数最小化”的话,无人驾驶汽车可能会为了规避后方车辆而冲上人行道。

(图自:datamanager)

去年图卢兹经济学院的 Jean-Francois Bonnefon 与同事们也做过类似的调查。比起《Science》的社会调查,他们更重视对无人驾驶汽车开发者的调查。

令他们感到悲观的是,他们发现开发者希望其他人坐在“行人保护优先”的无人驾驶汽车中,而自己不会购买这样的无人驾驶汽车。

无人驾驶汽车上路意味着我们把判断权转移给了计算机系统,但道德责任和法律责任无法转移。Chariff 希望人们能重视这个问题,在技术上和法律上能有更为明确清晰的标准。

不同于一般的电车悖论,无人驾驶汽车的道德困境的特别之处在于:它造成的结果,很可能一开始就被我们设置的指令决定了。

题图自:gazettereview