VR 线下体验馆之痛——如何选择最为合适的室内定位系统?

编者按:本文转载自转载自微信公众号 VR 价值论(vr-value),转载时已获得作者授权。

VR 线下体验带来的一大副产品就是,所有人都在说 “室内定位”!可真正系统了解过室内定位的人,太少了。本文将从实操的角度告诉你,七大定位方式,到底优劣何在,如何扬长避短。干货满满,值得收藏细读。

你将了解到:

- 室内定位系统的现状到底是什么样?

- 每一种定位方式的原理及优劣是什么?

- 好的定位方案应当以怎样的标准作为自己的目标?

本期由来自 VR 行业资深从业者王锐为你分享:如何选择最适合你的室内定位方式?

撰文:王锐,编辑:VR 价值论

现有的 VR 体验馆构建还缺少了最重要的一环,就是廉价而灵活准确的定位方案。本文将据此阐述一些已有方案的优劣:

缺失的一环

虚拟现实刮起的风暴如今已经愈演愈烈。

从形形色色的头盔和眼镜,到各种奇思妙想的交互设备,再到内容制作和建立体验馆的尝试,越来越多的 VR 相关从业者和创业者都将 The Void,Zero Latency 等前辈作为自己下一步赶超的目标,发出了开发 VR 主题公园,或者 VR 主题体验解决方案的宣言。

然而,从宏观的角度来看, 整个行业也并非发展的一帆风顺 :

VR 头盔和眼镜的水准参差不齐,VR 对系统配置的要求很高,相关设备随身穿戴不易,而移动端设备的渲染则多半力有不逮;而针对体验馆的交互内容如何制作,互动方式如何设计,也有诸多不甚明朗的地方。

除此之外,VR 体验馆的构建却还缺少了最重要的一环,就是廉价而灵活准确的定位方案。

这里所说的定位,就是确定体验馆中的参与者在场馆中的绝对空间位置,并反馈到所有参与游戏的玩家和游戏服务器上,进而执行群体游戏所必需的各种游戏逻辑。

例如,当一位玩家靠近树林的边缘时,一头蓄谋已久的饿狼会猛然扑出来;又比如多位玩家展开一场虚拟现实的真人 CS 大赛,互相射击与开展战术。

如果玩家在游戏场地内的位置无法得到有效识别,那么相应的乐趣和复杂度自然也就少了很多,也许只是来一场第一人称的定点射击游戏而已。

而定位的精度和速度也绝对不容忽视,20cm 的误差也许就决定了射出的子弹是否能穿透虚拟敌人的胸膛,而定位本身带来的延迟,同样也会给虚拟现实玩家的现场感带来巨大的影响,甚至成为 3D 晕动症的帮凶。

然而,纵观现在市面上形形色色的 VR 空间定位方案,却并没有哪家能够提供足够成熟稳定的技术实现,亦或者用巨大的成本以及灵活度的丧失作为代价,构建并不成功的 Demo 作品。

这样的程度恐怕还远远不能称之为解决方案,也远远无法满足众多体验馆从业者的胃口。那么,好的定位方案应当以怎样的标准作为自己的目标?整个行业缺失的救世主又是否已经到来呢?本文将尝试对此略加阐述。

(一)体感摄像头

去年底,日本新宿的繁华地段进行了为期仅一天的 VR 体验,通过头戴 Gear VR 显示一个虚拟雪山场景,同时搭建了实体吊桥道具,并通过风扇和冷空调来模拟寒冷的山巅环境。体验者在吊桥上战战兢兢地前进,最终在场地的终点位置拿到属于自己的奖品——来自经销商的一杯热饮。

这个体验游戏的复杂度并不高,收效却十分显著。而其中不可或缺的一环就是判断玩家在吊桥上行走的位置,然后对 Gear VR 中渲染的场景做出对应的处理。而在同一个宣传视频中,我们不难发现这样一丝端倪:

很显然这是一台微软的 Kinect2 体感设备,它可以通过 TOF(飞行时间)计算的方法,获取传感器射出光线遇到物体反射后的相位差,从而得到设备与实际场景之间的距离值,也就是深度值(depth) 。

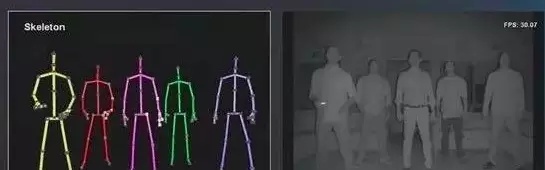

由此形成的深度图像不仅可以用来判断物体相对体感设备的位置,还可以进一步得到物体的点云数据,甚至是角色的骨骼信息。

最重要的是, Kinect2 本身只是 XBox One 游戏机的可选外设,因此要买到它并且用来做 VR 内容的简单空间定位,绝不会花费太多成本。

不过,物美价廉的对立面就是差强人意的性能参数,30fps 的刷新频率必然让人能够比较明显地感受到定位结果的延迟(虽然这种延迟相比头盔的延迟来说,给人的影响更小),并且 Kinect 的视场角只有 60 度左右,最大识别范围一般来说为 3-4 米。

在这个区域内可以识别最多 6 个人的位置信息,并且他们在 Kinect 的视场范围内不能有太多的重叠,以免漏测(如上图所示)。

显然,这些苛刻的限制条件让我们很难想象出一个比爬雪山喝咖啡更复杂的游戏了,不过至少这是一个不错的开始。

(二)光学定位与图像识别

有一则去年的新闻,在大多数 VR 从业者耳中应该不会陌生:澳大利亚的 Zero Latency 成为了全世界第一家虚拟现实游戏体验中心,它占地 400 平方米左右,由 129 个 PS Eye 摄像头组成,同时支持 6 名玩家同场进行游戏……

没错,这个体验中心相比之前的 VR 应用,其最大的卖点就是可以在虚拟空间中自由行走。而 PS Move 设备(包括 PS Eye 摄像头,以及装备了标记光球的 Move 手柄)则是这一技术的核心所在。

如之前的游戏效果图所示, 不同颜色的光球在 PS Eye 摄像头中可以呈现出显著不同于背景画面的图像,从而方便我们通过计算机视觉(CV)算法将它提取出来 。

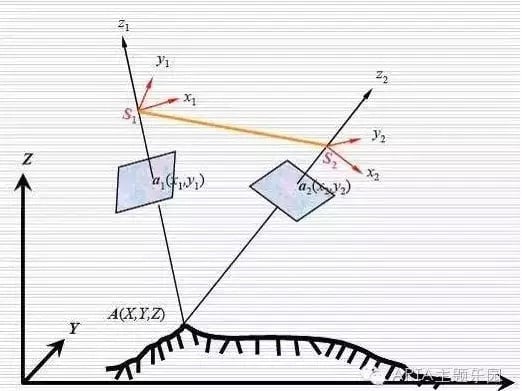

当然,仅有一个 PS Eye 摄像头的话,是无法得到玩家的三维空间信息。此时需要有不止一个摄像头去捕捉玩家的光球在屏幕空间的位置,然后通过空中三角测量算法,取得玩家在世界坐标系当中的真实位置。

这里自然又带出了两个不小的问题 :

- 如何准确而稳定地从摄像头画面里判断和区分不同的光球(标记点);

- 如何知道摄像头本身在世界空间的位置和姿态,从而正确推算玩家的位置和姿态。

为了解决这里所述的第一个问题,已经足够让无数开发者绞尽脑汁、前赴后继了。通过颜色来区分标记点的方案当然是可行的,不过如果摄像头里出现了另一种类似颜色的干扰物呢?或者现场就是一片花花绿绿的环境怎么办?

这种时候,误识别恐怕是很难避免的。因此 ,一批光学动作捕捉供应商站了出来,他们在理念与问题看待方式的不同使他们进行了分支研究。

一种是深挖主动式光学,一种采取了被动式光学。

采用被动式光学的一方选择采用红外摄像头作为识别的替代方案。

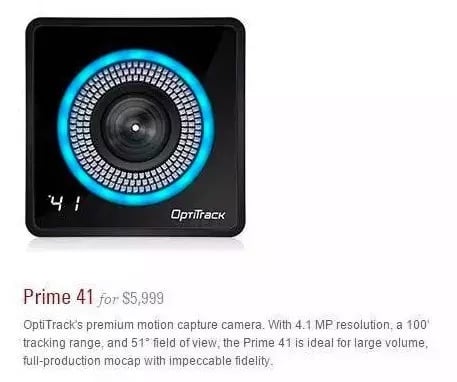

这里当然首推老牌的 OptiTrack,他们采用了帧速率大于 100Hz 的专业摄像头,并且采用了全局快门系统,因而有效避免了高速运动的物体在画面上出现运动模糊的现象。

它在摄像头的周围采用红外 LED 进行补光,并且采用高反射率的材质来制作玩家佩戴的标记点。

因为红外摄像头本身已经屏蔽了大部分的可见光信息,因此标记点在画面中就会显得分外明显。 除非有人用另外的红外光源来进行干扰,否则几乎不可能出现误判断的情形。

根据目前已知的一些信息,包括 The Void 主题公园,以及诺亦腾的 Project Alice,都是采用了 OptiTrack 的空间定位方案,这也无疑证明了这种方案的可靠性。

只是与之相对的,往往是高昂的成本(如下图,一台摄像头的价格都是以数万人民币计算的,而构建一个规则空间起码需要 4 台这样的摄像头,以及软件系统)。

不过,既然使用了不发光的标记球替代 PS Move 的光球方案(这样的另一个好处是,不用考虑怎么给标记球供电的问题),那么如何区分标记球的 ID,进而区分游戏中的多个玩家呢?

方法也有多种,例如通过对反射率的调整,让标记球在摄像头画面中显示不同的亮度;或者采用不同的组合方式,让一组光球在画面中呈现出唯一的组合形态,如下图所示:

而之前所说的第二个问题:如何知道摄像头本身在世界空间的位置和姿态?

事实上是通过预先标定(calibration)的方式来完成的。体验馆的搭建者预先将每台摄像机安装到固定的位置,然后逐一观察它们的画面显示。

通过已知位置姿态的一些标记物来推算每台摄像机的位置姿态,并且保存下来。这一过程无疑是繁琐而枯燥的,尤其当你需要动辄配置上百台摄像机的时候。

而设置完成之后,如何避免摄像机被再次移动,或者因为场馆结构问题而发生震动和偏移,这又是每一位开发者所不得不面对的设备维护难题。

不过,因为光学定位方法具有相当的准确度和稳定性,通过摄像头参数的调校也可以达到很低的延迟,并且在理论上可以扩展到无限的空间, 因此它也确实成为了目前很多国内 VR 体验馆搭建者的首选。

然而,通过标记点来识别多名玩家还是具有很大的局限性,因为标记点不可能无限组合下去,两组标记点靠得过近的话(例如背靠背作战的两位玩家),也很容易发生误测或者无法识别的情形。

此外,过于复杂的场馆环境也会让标记点更容易被障碍物遮挡,从而发生漏测问题,因此目前我们所见的多家采用光学定位的体验馆,都是在一个空旷的规则房间内进行游戏的。

而另一方深挖主动式光学的人们,则利用 LED 光点的频率与群组方式进行物体识别,使得每个 LED 光点都有自己独特的 ID,从而解决颜色区分受干扰的问题。

国内的 VR 乐园 ARTA,采用的就是基于美国 NASA 的空间定位技术,配合主动式光点频率与群组的方式,实现主动式动捕。

不过,这种技术明显的优势在于,其打破了被动式动捕的弊端,可以无限叠加,LED 光点越多动作捕获越细腻,因为主动式不会存在被动式遮挡方面的尴尬问题,可以实现自由拥抱,跳舞,交易交互等高遮挡性动作。

又因其光点亮度,可以无视阳光,可实现室外与室内的双重运用。这样突破了空间限制,也可以任意指定控制器(如我们可以给马桶搋子绑定光点,而在游戏内就可以变成骑士手握的圣剑)。

众所周知,在同时间段内主动式光从 LED 光点发出直接被摄像头接收,而被动式则以摄像头红外,传输到反光球,再由摄像头接收,反馈到终端。这导致主动式的运算效率更快,且没有大量无用信息干扰,这也是被动式获取大量干扰信息后,终端需要猜想导致画面或动作变形的主要原因。

当然世界上不存在绝对的无瑕疵,主动式的缺点为电池的续航,因为光点自发光所以电池续航能力在 6-8 小时,采用这种方式的乐园,其内容体验单局游戏需要做好时间控制,以此来支撑全类体验馆与主题公园的使用。

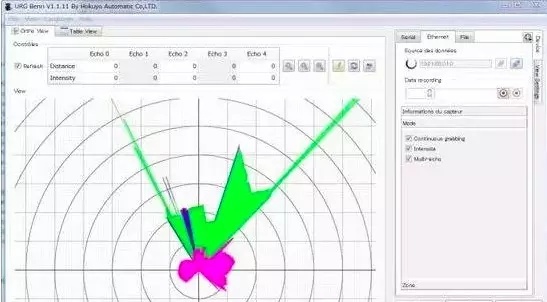

(三)激光雷达

激光本身具有非常精确的测距能力,其测距精度可达毫米,一般常见的是日本 HOKUYO 北阳电机和德国 SICK 西克等专业领域的大厂所产的二维激光雷达。

二维的意思也就是这样的激光雷达所发出的光是一个扇形平面,而各种用来做测绘用途或者建筑业用作三维重建的三维激光雷达,则是二维激光雷达又加了一个维度做旋转,从而得到三维空间的结果。

激光雷达包括一个单束窄带激光器和一个接收系统。

激光器产生并发射一束光脉冲,打在物体上再反射回来,最终被接收器接收。接收器准确地测量光脉冲从发射到被反射回的传播时间,即 TOF(Time of Flight)。 因为光脉冲以光速传播,所以接收器总会在下一个脉冲发出之前收到前一个被反射回的脉冲。

鉴于光速是已知的,传播时间即可被转换为对距离的测量。因为是以光速为尺子来测量的,所以激光雷达的精度一般都相当的高,在室内场合下用,误差都在毫米级别。

二维激光雷达实际上也是由一维的单束激光器在一个旋转底座上旋转起来所形成的扇面,一个二维激光雷达可以以自已为中心,以几十米为半径画扇面进行测量,所以如果在这个区域内有人活动的话,激光雷达就可以精确的知道一个人的位置并输出给电脑使用。

当然,激光雷达通常也可以用做机器人研究的避障传感器。

旋转底座旋转的快慢也是分很多规格的,因此激光雷达也会有扫描频率区分,正常来说,几十赫兹的扫描频率足够我们在 VR 当中做位置探测来用了。

但是激光雷达的工作原理对元器件要求高,通常又是工作在非常严苛的条件下,本身就要求防水防尘和数万小时无故障的高可靠性,因此生产成本并不便宜。

此外,扫描频率越高,探测距离越远(也就是发射功率越大)的激光雷达,价格也就越贵。所以二维激光雷达的价格就已不菲(近万元到数万元不等),而用作测绘的机载三维激光雷达就不是一般人能问津的了(几十万至百万)。

除了价格因素,激光雷达用作定位还存在一个主要的问题是: 因为从激光器发出的是一个扇形光,所以如果有一大堆运动物体互相拥挤着在一起的时候,互相会有遮蔽,后边的物体处在前边物体的 “阴影区” 当中,导致探测不到。

而且激光雷达只能测距,不能识别物体 ID,因此,就算不考虑价格因素,也比较适合单人情况下玩耍,如果想要群体的话,还是得采用其他方案。

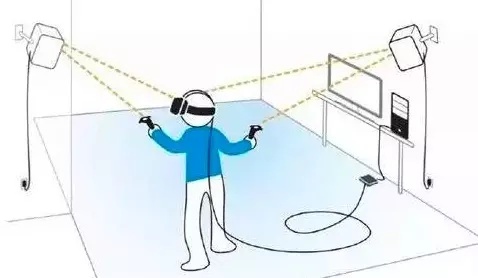

(四)HTC Vive:Light House

这段时间里,HTC Vive 的发售成为了整个业界的一大新闻,而它所采用的一种不同于光学的定位方式也是人们津津乐道的地方。

HTC Vive 包括三大部分,本身布满了红外传感器的头盔和手柄,以及用作定位的 Light House。 游戏者预先将 Light House 布置到一个空屋子的两个角落中,这两个 Light House 相当于两个固定的激光发射基站 ,如下图所示:

Light House 的后盖打开后,里面这样的:

那片密密麻麻的 LED 就是用来同步的光束。两个圆柱体则是旋转的一字激光器,一个是 X 轴扫掠,另一个是 Y 轴扫掠。两个激光器有固定的 180 度相位差,也就是说,A 亮的时候 B 不亮,B 亮的时候 A 不亮。

而手柄和头盔上都有固定位置安装的光敏传感器,这套系统的具体工作流程分为三步:

- 同步 :LED 灯板整体亮一次,手柄和头盔的传感器一起被照射,作为同步信号。

- X 轴扫描 :横向的一字激光器照射手柄和头盔上的光敏传感器。

- Y 轴扫描 :竖向的一字激光器照射手柄和头盔上的光敏传感器。

头显和控制器上安装了很多光敏传感器,在基站的 LED 闪光之后就会自动同步所有设备时间,然后激光开始扫描,此时光敏传感器可以测量出 X 轴激光和 Y 轴激光分别到达传感器的时间。

换句话说,激光扫掠过传感器是有先后顺序的,因此头显上的几个传感器感知信号的时间存在一个先后关系,于是各个传感器相对于基站的 X 轴和 Y 轴角度也就已知了。

而头显和手柄上安装传感器的位置已经提前标定过,位置都是固定的。这样根据各个传感器的位置差,就可以计算出头显和手柄的位置和运动轨迹了。

Light House 最大优势在于,它需要的计算量非常少。这就不像 CV 视觉系统那样需要先成像,然后通过软件将成像中的特征分辨出来,成像细节越丰富,需要的图像处理能力就越高。

Light House 使用的仅仅是光敏器件,无需成像,也就不涉及到大量计算和图像处理,避免了性能损耗和不稳定的可能。

另一方面来说,计算量大往往也就意味着延迟会更高,而且无法经由嵌入式处理器来完成运算。而 Light House 因为运算量小,因此嵌入式系统可以自己计算和处理,再直接将位置数据传输到 PC 上,节约了大量耗费在传输和处理上的延时。

不过,虽然 Light House 是迄今为止体验最好的 VR 交互定位设备,但是因为激光对人眼安全照射功率的限制等问题,它能够覆盖的距离比较有限,大概也就是 5M* 5M 见方的一个区域,并且不能有过多的遮挡物导致接收不到信号。

并且这种设备的安装调试还是比较繁琐的,对于一般用户来说可能还是比较困难。

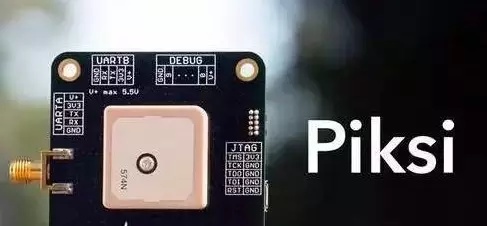

(五)RTKGPS

实时差分 GPS 技术至少有两个部分组成:在基站上安置接收机,对所有可见的 GPS 卫星进行连续观测,并将观测数据通过传输设备(比如数传电台,Wi-Fi,以及公用 3G/4G 通信网等等),实时地发送给用户观测站(流动站)。

而在用户观测站上,同样通过 GPS 接收机接收 GPS 卫星信号,同时还通过无线电接收设备,接收基站传输的观测数据,然后通过相对定位实时地解算用户三维坐标,其动态定位精度可达 1cm-2cm。

这一技术不仅可以用作测绘,也可以用于军事用途。它的高精度特性可以用于联合收割机等大型农用机械的精确导航,从而在大机械生产和精耕细作之间达到完美结合;而在国内,一个相当广泛的民用场景则是驾校考杆……

在 RTKGPS 出现之前,测绘行业为了获得一个精确到厘米的坐标,需要用普通 GPS 设备接收数据然后进行大量的离线计算。

而 RTKGPS 的出现大大发展了许多新应用场景,例如无人机。RTKGPS 原本属于专业领域,使用者寥寥且售价也非常高,不过近些年来已经有越来越多从业者将这项技术变得更亲民,例如下图这块开源 RTKGPS 套件:

不过,RTKGPS 毕竟是 GPS,必须在户外才能够使用。这对于通常计划设置在室内或者大商场中心的 VR 体验馆来说,无疑是一大不利的消息。

不过室外的极重度 VR 体验也绝非没有先例,例如下文链接中的视频曾一度红遍各大媒体和朋友圈(但是真的是高度危险,绝不要自行尝试)——《戴上 VR 头盔开赛车,炫酷到没朋友》。

这原本是某汽车大厂牌和某润滑油一起搞的一次公关活动,赛手带上 OculusVR 头盔,同时车上装载了高性能电脑,从而完全体验到在虚拟空间当中漂移的乐趣。

而这个冒险活动之所以能够成功,其中一大原因就是采用了 RTKGPS 来完成定位,这样才能比较精确的知道车与驾驶员的位置,并且安排对应的虚拟内容呈现(以及避免车手乐极生悲跌出场外)。

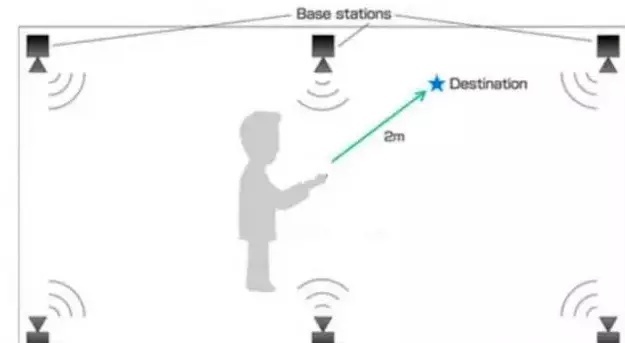

(六)UWB

UWB 定位技术属于无线定位技术的一种,这一技术(Ultra Wide band)也被称为 “超宽带” 定位,它是一种利用脉冲信号进行高速无线数据传输的短程通信技术,而非一般无线通信系统所广泛采用的载波方式。

UWB 定位原理其实也很简单,就是利用信标发出的脉冲到达基站的飞行时间来解算位置,没错,还是我们所熟悉的名字,TOF(Time of Flight)。

不要忘了无线电也是基于光速传播的,因此它的探测精度从理论上可以做到很高。

UWB 最初的定义是来自于 60 年代兴起的脉冲通信技术。UWB 技术的脉冲长度通常在亚纳秒量级,而信号带宽可以达到数千兆赫兹(UWB 限制在 3.1 – 10.6 GHz),这项技术在 1989 年被美国国防部命名为超宽带技术。其特点是大带宽,无载波,低功率。

正因为带宽超大,因此 UWB 技术的穿透性比较好。

相比 Wi-Fi 等技术来说,无线电的多径效应(因为高频信号都是直线传播的,所以会因为建筑的遮挡等来回弹跳分成几路,难以判断)要弱得多,所以这一定位方案精度往往要比传统的基于 Wi-Fi 的 Room-Level 方案(即判断用户在室内的哪个房间)高出不少。

现在成熟的 UWB 定位方案系统甚至可以做到几十厘米,也有个别方案商号称能有 2-5 厘米的精度级别,但是实际在各种不同空间的建筑物室内场合部署的时候,基本上还是达不到这个精度。

毕竟不可能所有的场地都是一个空旷且没有任何遮挡,也没有更多人参与的大屋子。

不要忘记这项技术本身的核心还是通信链路,因此各种设备的通信干扰同时也产生了。

毕竟 UWB 本身还是一种无线电技术,它所覆盖频段内所有的无线通信都会对它有所干扰,并且,尽管它的穿墙性能比别的无线技术更好,但是仍会有较大衰减。而且 UWB 的标准是限制发射功率的,所以现在绝大多数方案都是在 10 米左右有效,如果是室内较大场馆的话,可能还要布设大量的通讯基站。

因此,目前如果采用 UWB 独立定位的方案,恐怕还是达不到重度 VR 体验所需要的定位精度和距离,不过如果可以与其他方式进行数据融合的话,也许有希望解决这一问题。

比如德国著名的 Fraunhofer 研究中心,早就有一种” 黑科技” 产品叫做 RedFir:

在球员双脚的球鞋中安装设备,以及球内放置好设备,同时在整个场地里布设大量的采集基站之后,整个球场就变成了一个高科技虚拟演播室,可以在进行比赛转播的过程中随时进行数据采集和分析,进行可视化的工作。

这样的好事当然也有希望用到 VR 体验当中,只是为了无线传输本身的那些关键问题,恐怕依然要开发者们付出不小的代价。

(七)当红炸子鸡:SLAM

SLAM 的英文全称是:Simultaneous Localization and Mapping,即时定位与地图构建。

简而言之,对于空间内的一个机器人(或者无人机),如果它处在一个完全未知的环境里(比如古墓探险),那么它就可以一面沿着墓道往里走,一面用摄像头或者激光雷达来创建这个墓道的数字信息拷贝(也就是构建地图),这样过一会儿就可以使用刚才创建的地图数据给自己导航使用了。

哦,一些非常高档的扫地机器人,也号称用到了这项技术。

在电影《普罗米修斯》中有这样一个场景,一个拥有激光探测信息能力的无人机(球)被扔出去后,就开始自主获取空间信息。这是一个典型的 SLAM 应用场景。

实际上,从学术定义上来说,机器人在完全未知的环境中从一个未知位置开始移动,然后在移动过程中根据位置估算和自身传感器的数据进行不断地定位和修正,同时建造增量式的地图,这就是 SLAM 方法的基本过程了。

当然,这种方法不一定只服务于机器人,如果是人背负了便携计算设备(或者手机),那么通过 SLAM 同样能在未知环境里创造地图并给自己定位,这就是我们在 VR 场景中迫切需要的功能。

SLAM 算法的数据源是多种多样的,比如用激光雷达扫描的点云数据,也有双目摄像头利用 RGB 图像和立体视觉来生成,或者就是直接使用 Kinect 这样的 RGBD(可见光 + 深度)方案;而实验室级别中甚至也可以见到基于单摄像头和 RGB 彩色图像或者灰度图像来做 SLAM 的算法论文。

从另一个角度来说,如果期望实现基于三维空间的识别技术(而不是传统的二维码或者图片),那么就意味着必须更好更快地应用 SLAM 类的方法,而也是各大 AR 软件和算法开发者(例如 Metaio,不过已经被苹果收购)一直在努力实现的目标。

因为 SLAM 一方面能够给出一个比较精准的空间位置,同时还能做为环境三维特征获取和三维重建的必要手段,进而解决了显示设备里实际场景和虚拟画面叠加时,相互遮挡关系的问题,这样的 AR 场景在将来也许是广泛应用的,也许也是随身可穿戴的一种刚性需求。

如今,SLAM 已经被广泛地应用在 VR/AR 的设备上了,比如微软的 HoloLens 就是典型的 RGBD SLAM 方案。而 Google 的 Project Tange 手机,以及 Intel 的 RealSense 都属于 RGB-D SLAM 的设备范畴。

即使是一直没有多少人见过实物的 “黑科技” 公司 Magic Leap,恐怕也不可能不采用 SLAM 来做为空间定位和虚实遮挡关系判断的基石。

而 SLAM 在高端商用市场上,其实早就有很成熟的案例。例如虚拟演播室摄像机系统 NCAM,它无需传统的电控云台,可以直接架在斯坦尼康稳定器上到处拍摄。得到的相机位置和姿态结果则会实时地反映到内容制作工具当中,从而实现一部动画片或者特效大片当中重要的摄像机走位环节。

当然了,SLAM 技术绝不是没缺点。

首先它依然是基于视觉的识别,信号的采集 / 传输 / 处理过程相对其他技术手段来看,延时情况往往还是难以忽略,而这恰恰是 VR 体验里最不能接受的一点。

另外,SLAM 对现阶段的移动设备来说,计算压力仍然太大,Project Tango 手机和 HoloLens 眼镜为此增加了一块或者多块协处理器,这样自然又带来了电源管理和过热等各种问题,传闻中卡马克也在为未来的 OculusVR 和 GearVR 头盔寻求基于 SLAM 的定位方案,它是否能成为未来 VR 世界主流定位方式,目前还是个未知数。

另辟蹊径,全向跑步机

以上所有的空间定位方案,都是基于同一个大前提,即玩家可以按照自己的意志在场地中自由行走,其行走范围受到场地本身的限制。

如果我们的体验目标是一款在仓库密室里大战僵尸,或者在街口构筑工事迎击强敌的 VR 游戏,那么这样的方案显然总有用武之地;但是如果我们是以一款《GTA5》一样的超级大空间作为目标,或者是可以无限和探索下去的沙盒游戏,那么再大的场地恐怕也不够玩家折腾……

而且场地越庞大,结构和形状越复杂,对应的定位设施安装和维护成本就越高,要保持一个稳定的定位算法和精度也就越困难。

幸好,总有人能够另辟蹊径,比如在人们每天健身常用的跑步机当中,加入除了速度控制之外的方向控制因素,就成了所谓的全向跑步机

(Omni-directional treadmill):

不过设计一款全向跑步机可不是去淘宝选一款带触摸屏和 MP3 功能的跑步机那么简单的事情,这里有两个巨大的问题需要开发者们去思考解决:

- 如何识别玩家在跑步机上运动的速度和方向;

- 如何把跑动的玩家限制在设备中心,或者在他无察觉的前提下把他 “拽回” 设备中心?

上图的 Omnideck 就是一套比较早推出的解决方案,它采用了一组以玩家为重心的径向运动的传送带。当玩家走到任意一条传送带上面时,传感器就会感知到玩家的运动方向和速度,然后带动皮带将玩家送回到中心。

不难想象,图中设备的精度主要取决于这些径向传送带的数量。而一旦增加传送带的数量,则会带来更为沉重的维护成本,传感器精度问题,以及自身重量。

况且在如此巨大的空间内只能容纳一个人游戏,这从营收角度上来看可能也是入不敷出的。因此,很多专注于 VR 行走体验的公司随即推出了一个看起来更为合理的方案,例如下图中的 Virtuix Omni:

Omni 跑步机本身可以看作是一个炒菜用的不粘锅锅底(事实上它的材质确实也就是不粘锅的材质),它的底盘被设计成一个表面凹陷的圆形曲面,并且由很多细小凹槽的光滑径向跑道组成。

上方是一个可调节支架,起到保护玩家和识别下蹲 / 跳起动作的功能,总重量约为 50 公斤,并且用户需要穿上特制的鞋子才能够在 Omni 的跑道上运动——更准确地说,是在跑道上滑动。

这一设计比前者更为轻巧灵便,其关键就在于这种 “脚部在锅底滑动而无法离开中心” 的特点,而凹槽中遍布的传感器系统则会负责随时测量用户运动的方向和速率,从而模拟出玩家在虚拟空间的行进过程。

这一方案从原理上看起来无懈可击,只是穿戴起来比较繁琐,推向家用市场恐怕还有距离。然而,从实际使用者反馈来看,“脚底滑步” 的运动方式显然不会让他们感到舒适。甚至可能是一首儿歌中的感觉:

小老鼠,上灯台,偷油吃……

那么有没有那种不那么笨重,灵敏而准确,跑起来又不会让玩家感到不适的方案呢?也许会有:

Infinadeck 全向跑步机自诞生之日起就吸引了诸多媒体和行业人士的关注,它的基本构想其实并没有非常复杂的地方:采用电机带动皮带轮的方式,使用一整条沿 Y 轴运动的大皮带轮,带动多条沿 X 轴运动的小皮带轮,这样玩家在两个轴向上的运动都可以被识别和记录下来。

而玩家一旦离开了跑步机中心位置,系统就会通过视觉识别或者其它的识别方式发觉玩家的偏移方向和距离,并且启动电机将玩家送回原处。

当然,这样的设计同样有两个不小的难关要闯。

首先是负重问题,如此多的电机和皮带轮被安置在一台设备之上,自身的承重压力恐怕是相当不小,整个非机械结构也不得不用足原料,打造钢铁之躯;总体估算下来,这样的设备难免有上吨的重量,真的搬到家里恐怕只会让楼下的邻居如坐针毡。

其次是玩家的运动感受与设备尺寸的关系,如果设备本身过小,皮带轮周长也就很小,产生的摩擦力也就不同——由此很容易带给玩家一种明显 “被拽回原地” 的感受;而设备过大虽然能够让 “回原位” 的过程变得平滑,却无疑进一步增加了设备体积和重量,让家用级使用成本变得更为难以接受。

Infinadeck 一直在声称要构筑廉价和方便的全向跑步机系统,而他们迟迟没有放出更新的消息,也许也正在受困于这些结构和选材上的难题吧。

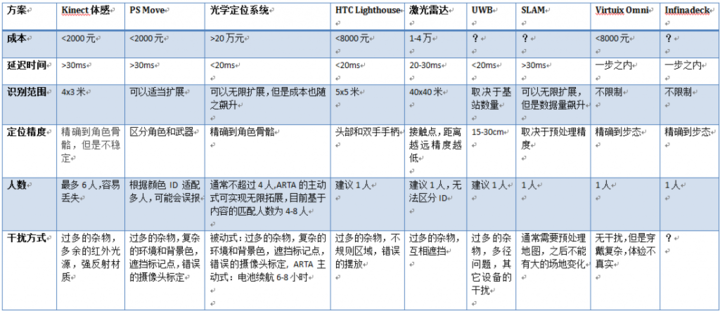

各方案优劣列表

我们简单地总结一下之前提到的各种定位方案的优劣,如下表所示:

结论似乎暂时还很让人沮丧,没有哪个方案可以说同时解决了成本、游戏人数、延迟时间、抗干扰性、以及空间限制这几大问题。

换句话说,虽然笔者历经千辛万苦和各种求知求助,总算集齐了七大武器加上一个额外的 Bouns(跑步机),却依然无法达成那个一开始就存于心中的愿望:VR 虚拟空间行走的体验,难道就真的是一个遥不可及的目标?

幸好,我们看到有足够多的从业者已经为这个目标而开始努力。

笔者体验过上海青瞳的光学定位方案,其低延迟和准确性已经做到了可用的级别,而更低成本的产品研发想必也是这个团队下一步的目标;诺亦腾据传也不满足于目前系统关键部件的高成本和受制于人,开始研究自己的光学定位系统;The Void 更是秘密收了一个专精于 UWB 定位的团队,打算把自己的主题公园定位方案更加精进。

让建造和维护成本更可控,让多人同场游戏不再是关键难题,让你的游戏者不要变得举步维艰,期待未来出现更多接近实际需求的定位方式。

题图来源:youtube