两个 AI 一起工作,它们会合作还是互斗?Google 给出了答案

两个或者多个 AI 在工作时,如果有利益相关,或是目标出现冲突,它们会选择斗争还是合作?

随着人工智能 AI 的不断发展,人们对它能力的担忧和期待也越来越多。Google 旗下的 Deepmind 也在研究不同环境中 AI 们的具体行为。

2 月 10 日,Google Deepmind 部门公布了一项研究结果,人工智能在测试后出现了这样一种情况:AI 会根据其所在环境来改变自己的行动,这与人类的一些社会行为相似。

Google 通过两个不同的游戏来测试 AI 的个体行为,一个游戏名为“Gathering”,另一个名为“Wolfpack”。

“Gathering” 是一种“双人游戏”,需要参与者收集足够多的苹果。在游戏里,AI 玩家都可以选择对对方做激光标记点,一旦被标注,则被标记者在当局里无法收集苹果。标记对手不会有额外奖励。

另一个游戏“Wolfpack” 是一个捕猎游戏,玩家要在到处都是障碍的环境里捕捉猎物,当两个 AI 猎人都接近猎物并最终捕获猎物时,他们都可以得分。

Deepmind 部门的研究员让 AI 来参与这两个游戏,并重复实验上千次来避免结果的随机性。

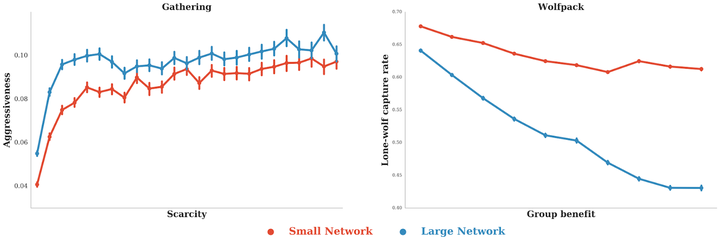

结果表明,在“Gathring”游戏里,如果苹果数量够多,两个计算能力相近的 AI 玩家会选择和平相处,各自不断拿走苹果;一旦苹果数量减少,AI 们就变得好斗了,它们会用激光标记对方,为自己赢得更多抢苹果的机会。

游戏视频截图,绿色代表苹果,数量少时 AI 会发出黄色光束标记对方

并且,如果两个 AI 的计算能力不同,能力较强者好斗性更强,不论苹果数量多少,它都倾向于选择标注对方,增加自己的胜算。

这一结果与博弈论里的囚徒困境理论中的多种情境相近(囚徒困境是博弈论的非零和博弈中具代表性的例子,反映个人最佳选择并非团体最佳选择。或者说在一个群体中,个人做出理性选择却往往导致集体的非理性。)

Deepmind 的研究员认为,不管是和平共处共同收集苹果,还是通过阻碍对手赢取更多苹果,AI 都会在具体情境下学会更符合它们“期待”的行为。当剩余资源减少,AI 会采取更为激进的策略,通过把对手击败踢出局来赢得所有苹果。

在 “Wolfpack”游戏里,AI 则倾向于通过合作来完成狩猎行动,且计算能力更强者选择这种做法的情况更多。这与“Gathring”游戏的情况是相反的。

游戏视频截图,红色的捕猎者 AI 会通过合作抓捕猎物

在 Deepmind 看来,人工智能会根据具体情境改变行为方式,这与人类类似。而人工智能也可以在某些具体任务里,特别是合作能带来更大收益的情况下,达成合作,从而取得行动的最佳效果。

苹果越少,好斗性越强;独狼抓住猎物的比例越大,群体利益越低

在 Deepmind 的博客内容里,科学家乔尔·Z·勒博(Joel Z Leibo)说:“这类研究将帮助我们更好地理解和控制复杂多人工智能系统的行为,例如在解决经济、交通和环境问题的过程中。”

题图自:businessinsider