我用 Google Lens 看了一眼去未来的路,似乎还是有点远

Google Lens 这个被整合在 Google Assistant 中的功能,终于在距离五月份的 Google I/O 近半年的等待后,出现在了 Google Pixel 手机中。

而从昨天开始,所有 Pixel 系列手机中的 Google Lens 都可以开始使用,而当前 Google Lens 只能在英文系统环境下使用。

在半年前的 Google I/O 上,Google Lens 作为当时为数不多的亮点,确实非常让人印象深刻,通过 Google Lens 让未知的一切变成已知,是它最神奇的地方。

爱范儿的一台 Google Pixel 也在昨天收到了 Google 推送的 Google Lens 功能,不过由于地域,网络,语言等因素的限制,只能做一些简单的体验供大家参考。

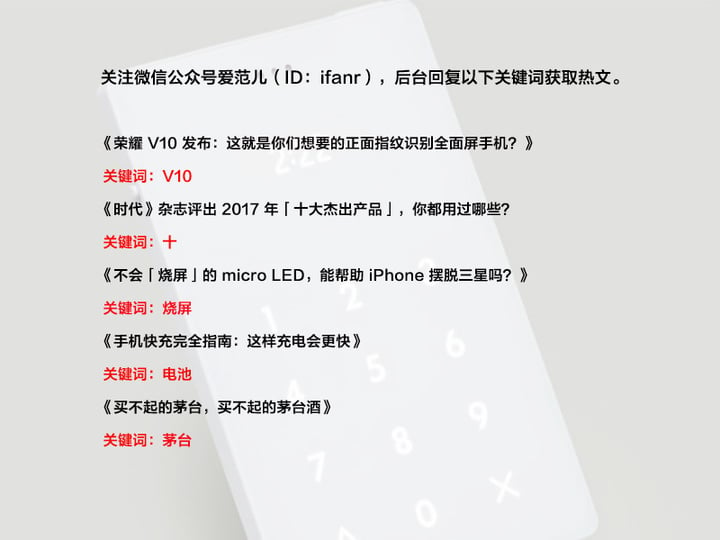

(当然,这不是长筒靴)

最简单的“看图说话”,Google Lens 基本不在话下,你给它看什么,它几乎就能说出是什么。当然,对于拿不定主义的,它会小心翼翼的用不那么肯定的词汇来回答。

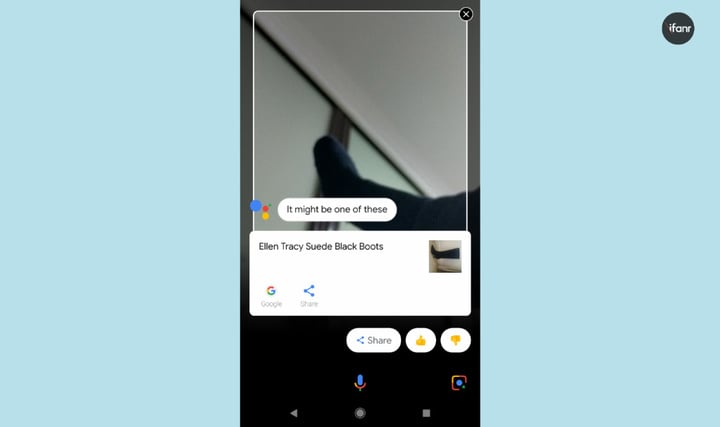

(算你对了)

比如面对干枯到看不出是什么的植物时,它会说“我猜这大概是一种植物。”

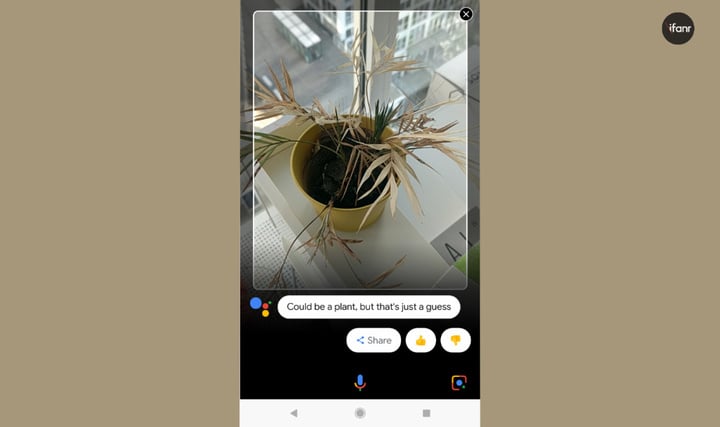

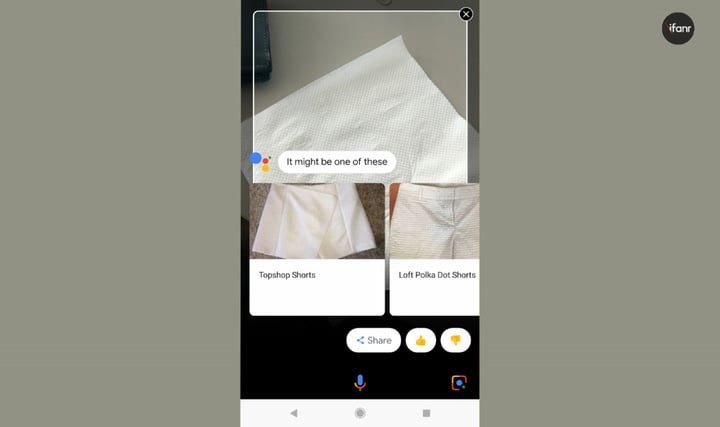

而当我让它面对一张餐巾纸时,它选择不去直接回答这是什么,而是告诉我这可能是以下这些物品,当然,它也没认出来这是纸巾,而是把纸巾当成了短裤。

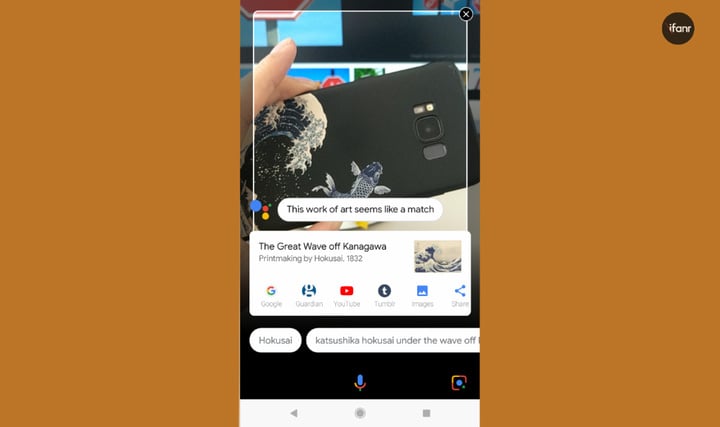

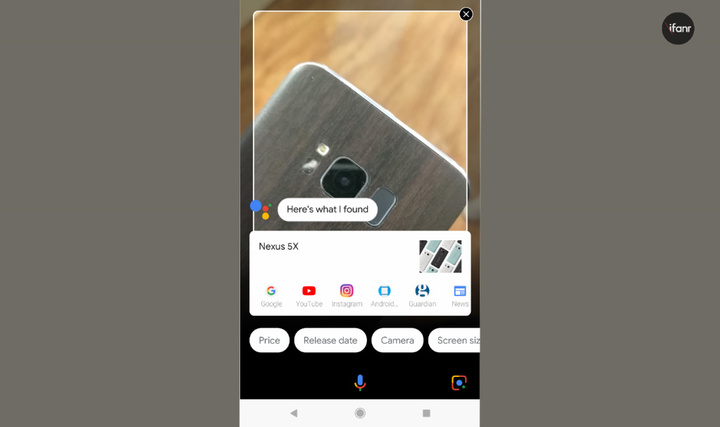

当然,Google 曾演示过 Google Lens 最拿手的技能之一,就是识别画作,本来抄起手中的 S8 想看看 Google Lens 能否看出来是什么手机,但是直接扫到了保护套的图案,结果如上(请忽略那条山寨的鱼),这副经典画作,包括年份,以及画家的名字也都显示了出来。

而从操作逻辑和易用度上来看,使用 Google Lens 几乎没有什么学习成本。

长按 Home 键或者用 “OK Google” 呼出 Google Assistant,然后在 Google Assistant 界面右下角会看到一个像镜头一样的 Google Lens 标志,点击后就会打开相机镜头。

之后点击屏幕,这时就相当于拍照一样,在屏幕上生成一张照片,会出现相应的信息。

不过这和当时在 Google I/O 上演示的有些许差异,在当时的一个场景演示中,是可以实时显示建筑物信息的,但目前看来,想要实现这个能力,或许还要再等等 Google 自家的 ARCore了。

除了识别物体,Google Lens 还可以识别文字,而且,如果文字足够清晰,数量足够多,可以帮助 Google Lens 更准确的识别被摄物体。

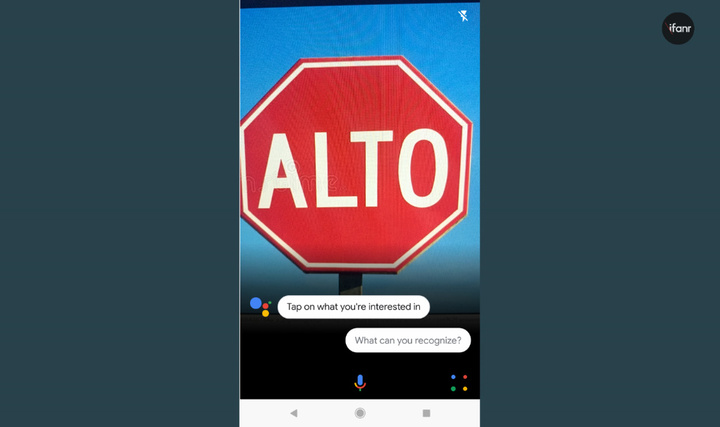

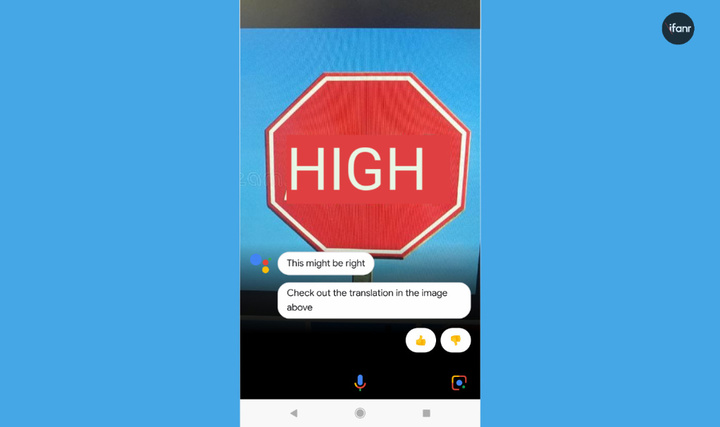

(墨西哥语:high?)

此外,Google Lens 似乎也继承了 Google Translate 的一些特性,比如你在国外看到一些指示牌,但不认识外语,此时无需再打开 Google Translate,只需用 Google Assistant 对准指示牌,然后通过语音如 “translate into English”,这时,英文就会直接显示在指示牌上(如下)。

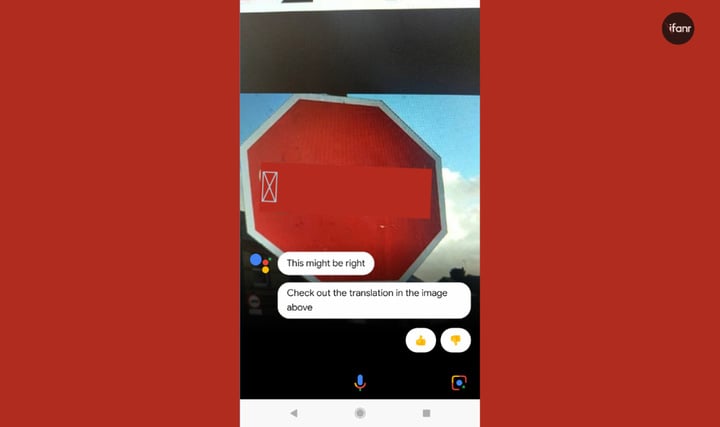

不过,目前似乎还不支持翻译成中文,而硬要翻译成中文的话,是下图那样的结果。

Google Lens 并非是个华而不实的存在,上述的翻译能力就非常的实用。

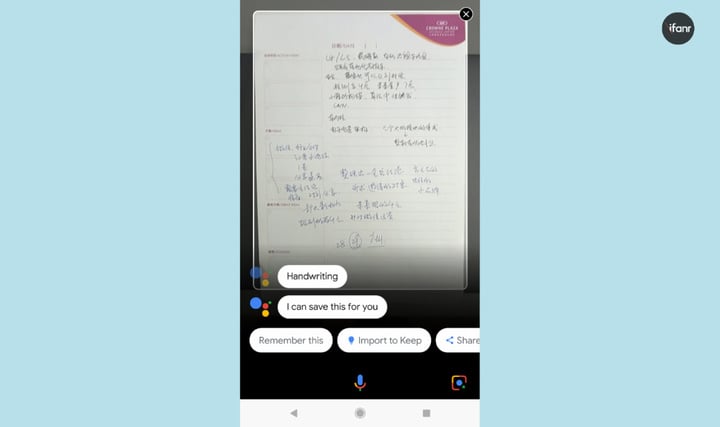

它也可以扫描名片并直接添加近通讯录,也可以让 Google Assistant 记住扫描后的文档,扫描后只需对它说“remember this”,之后不管何时你只需问“what did i ask you to remember”,它就会将你之前存储的文件展示出来。

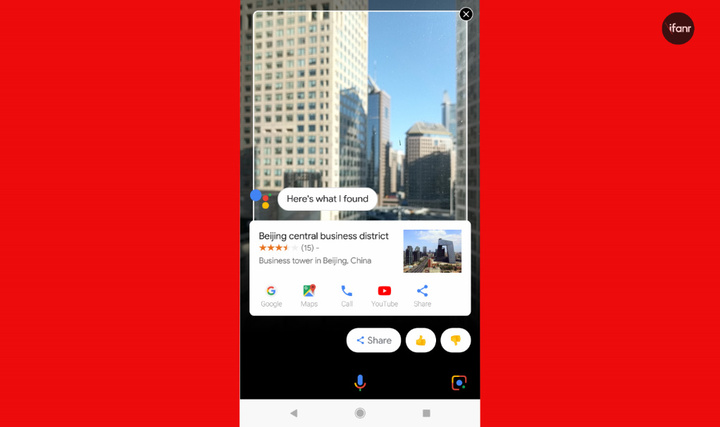

这些都是在生活和办公场景中真正能派上用场的。体验中,我也尝试让它识别建筑物,识别的结果并不是每次都准确,但确实能在一片高楼中识别出大概的位置,而有 30% 的几率能通过被拍摄的地点显示当前的天气状况。

(No No No)

Google 表示,未来还会开放扫描路由器 WiFi 密码直连的功能,更多的功能也已在路上,而 Google Lens 的识别能力也会随着用户的使用变得越来越精准。如果你的手机不支持 Google Lens,未来 Google Photo app 的更新中会慢慢开放这项功能的精简版(Pixel 已经支持)。

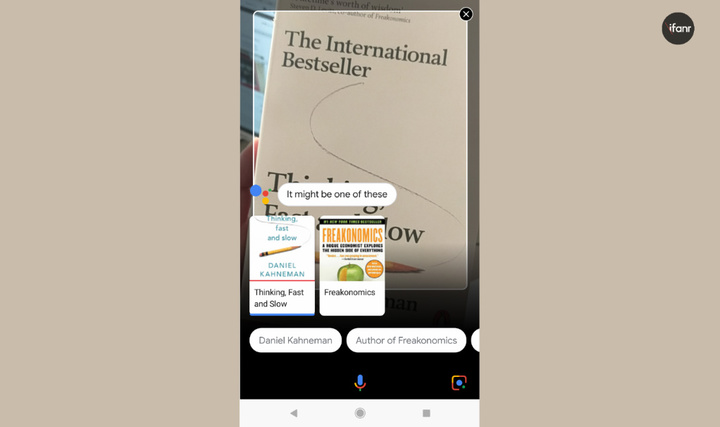

(识别图书毫无压力,中文暂不支持)

其实,早在 Google Now(Google Assistant 前身)的时候,就已经有类似 Google Lens 的功能了,只是,要先打开相机,然后长按 Home 键,来让 Google Now 识别取景器中的物体或文字,原理几乎是一样的。

还有更早的 Google Goggles,也算是被整合进了 Google Lens 之中。

(扫描后可以让 Google Lens 存到 Google Keep 记事本中)

但 Google Lens 不管是响应的速度还是识别能力都要比当年的 Google Now 和 Google Goggles 快了不只一点,大量的数据处理能力和机器学习的功劳是必不可少的,但,它就和 Google Assistant 一样,用户真正能用到它的时候依然太少。

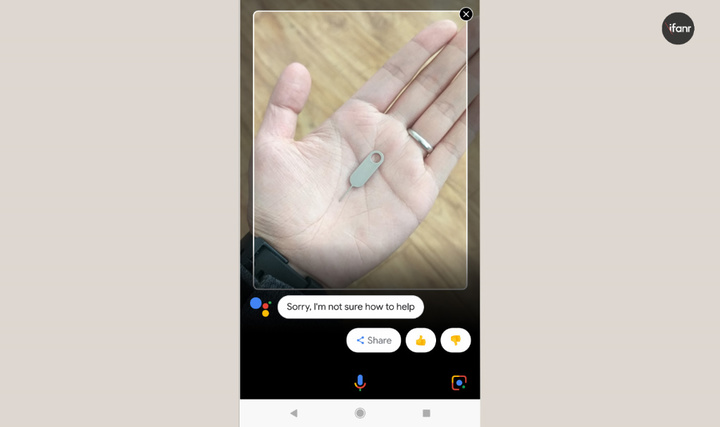

(手,戒指,卡针,物体多了也会影响识别能力)

在大多数情况下,用户已经知道了眼前的物体是什么,并不需要它再来告诉我,而我们确实不知道的东西,它的数据库里,也很难说会存在。

只能说,Google Assistant 和 Google Lens 确实很聪明,也颇具未来感,但如何让用户更高频率的去使用它,依然是一个待解决的问题。

可话说回来,当我们看到曾经想象中的未来科技一个个变为现实的时候,仍然会充满好奇,仍然会迫不及待的想要去尝试,即便我们离未来依然还很遥远。