让语音助手好好说话这项成就,Google 还有些事儿没告诉你

人工智能仍然在不断颠覆着我们对 “黑科技” 这一名词的认知,这是很多人看完 Google 新语音交互技术演示后的感叹。

在上周召开的 Google I/O 大会上,Google CEO 桑达尔·皮查伊(Sundar Pichai)向众人展示了一段日常生活中再正常不过的电话沟通片段:向理发店或是餐厅预约时间。

不同之处在于,这是一段 Google AI 语音助手和真人之间的对话。它实在是太过真实,倘若不是在发布会上,单纯听这段录音恐怕很难分清谁是 AI 人工智能,谁才是真人。

最后,名为 Google Duplex 的人工智能助理出色地完成了往日需要真人实现的电话预约服务,也让我们看到语音助手了下一种演变方向。

借助 AI 技术,人类和语音助手之间的沟通不再是单向的,而是可以很自然流畅地实现多段沟通,就像人与人之间的对话一样。

这种自然,具体体现在以下几个细节:

1. 更加富有情感的变调语气,比如提问句中会有停顿,某些单词则带有明显的拖长音;

2. 哪怕是对方回答的内容稍显混乱,Duplex 也能调及时调整应答内容;

3. 会发出诸如 “嗯哼”、“额…” 这样的语气词;

4. 恰到好处的回应速度。

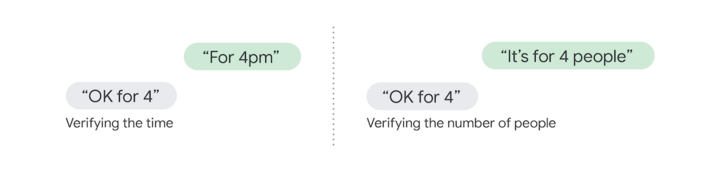

事实上,人类在日常对话中并不会太讲究语序逻辑,有可能会在一个句子中夹杂着多层意思,这一点在 Google 现场演示的两个电话沟通案例中也有体现。如果在中文领域,大量的同声词或是同音字会让情况变得更加复杂。

当然,目前 Duplex 只是在 “电话预约” 这一领域能够自然地和人类交流。Google 之所以会选择这个先行试验领域,也是由于这个场景中涉及的问题不多,对话往往都离不开时间、地点、人数等这类的关键词。而单一环境意味着 AI 能够更加充分地学习该场景下的内容,并进行有针对性地训练。

但是,由于真人对话的语序问题,电话沟通中的许多确定性信息,往往要在几段对话后才会出现,比如 “时间是下周五”→“什么时候?”→“下周五,18 号” 这种关于时间点的反复确认。

语音助手不仅更聪明,连声音都越做越逼真

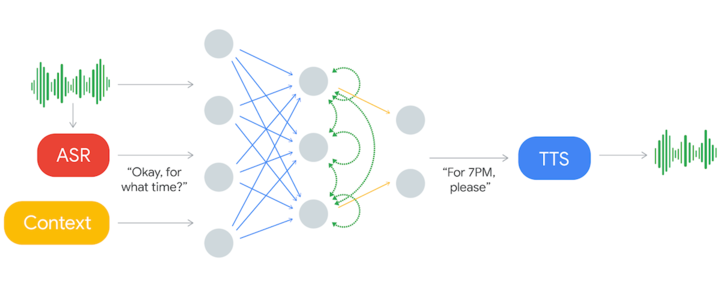

为了准确处理对话问题,我们结合 Google AI 官方博客的内容,简单梳理了一下 Duplex 的处理流程:

1. 依靠 TensorFlow Extended 搭建一个循环神经网络(RNN)模型,并使用匿名通话数据进行了训练;

2. 真人语音会先通过自动语音识别技术(ARS),向 RNN 网络输入文本信息,其中也包含了音频特征和对话历史;

3. 通过 RNN 生成的文本会借助 TTS 将文本转语音,来作为最终应答的内容。

这么看,Google Duplex 和其它很多人工智能在做的事情也很相似。它们都要先通过大量的数据进行分析训练,自己学习处理和识别这些数据,然后再借助合适的模型导出预测结果。

至于大众所关心的 “Duplex 的说话声和人类差不多”,一方面前文也提到,单一领域下 AI 可以进行更深度的学习;另一方面,Google 则是借助了包括 WaveNet 在内的文本转语音技术,让 AI 可以根据不同情境来改变语气和语调,生成质量颇高且细致入微的语音。

(图片来源:CNET)

其中一点很重要的是 “语气词” 的运用,人类在说话的过程中也会思考,其中的停顿往往就会伴随着一些语气词。我们会在 Google Duplex 的应答中听到如此自然的表达,有些是开发人员在训练时刻意为之,有些则是为了能更好地过度多个声音单元。

当然,在应对一些需要快速回应的询问比如 “你好” 时,Google Duplex 可能都不会等待模型运算结果,而是会先给出一个模糊的回答,然后再根据之后的内容配合一个正式回应。

这个手段可以让 AI 的响应时间更快,同时也更加自然——毕竟如果对复杂问题回应太快,听起来可就不像是一个 “人类” 能做到的事。

这种 “拟人声” 的自然语音表达,背后离不开文字转语音技术的进步。现在很多的语音助手,一个句子只是将几个单词的语音拼接在一起,虽然结构本身没问题,但语调基本没有起承转合,听起来就非常生硬。

最典型的例子其实就是我们给 10086 打业务办理电话,大家都知道其中的回应语音都是预设的——那种声音不带任何情感,所以我们都能 “听” 的出来。

(图片来源:Marques Brownlee)

但 Google Duplex 不一样,它发音的清晰度可能比人类都更为标准。

早在 2016 年,Google 和 DeepMind 就向我们展示了名为 WaveNet 的基于深度学习的语音生成模型。由于音频涉及了大量信息,它借助卷积神经网络的层层堆叠和延时连接,以及大量的样本训练,最终生成的原始音频波形在韵律和语调上都表现得非常出色。

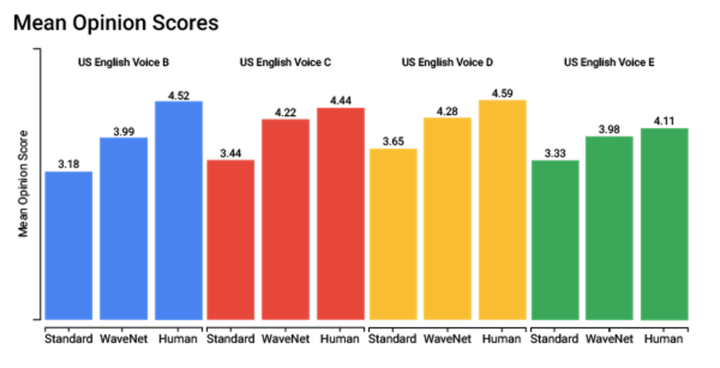

在实际的美国英语语音测试环节中,WaveNet 的声音得分已经非常接近人类的水准,如果再加上句式的准确性因素,可能还不亚于人类。

现在 Duplex 便在文字转语音这一环节中使用了 WaveNet 的语音合成技术。同时,和图像识别、翻译等 Google 云计算平台 API 一样,WaveNet 的文字转语音服务,也成为了当前 Google 云计算服务的卖点之一。

对语音沟通服务有需求的,不仅只是电话预约

根据 Google 的计划,Duplex 会率先在餐馆、理发店等电话预定较多的领域开始进行测试。正如前文所说,电话预约领域涉及的关键词不多,在 AI 的帮助下,可以减少很多 “重复沟通” 的工作。

1. 对商家来说,如果使用了 Duplex 支持的预定系统,哪怕在离线状态下也可以让客户通过 Google Assistant 实现预定。

2. 节假日中有些商家会变更营业时间,这时也可以让 Duplex 在电话询问后再通过 Google 自动更新信息,而不需要商家自己操作,用户也不用反复给商家打电话确认。

3.Google Duplex 完成电话预约的过程是后台全自动的,完成后会直接在手机上提醒用户,这一点对于残障人士来说帮助极大;若是遇到 Duplex 无法识别的任务,则会转交给用户来继续完成。

至于 WaveNet 文字转语音技术,接入 Google 云计算平台则可以运用在更广泛的领域。目前 Google 已经明确了几个实际应用场景:

1. 和智能电视、汽车、机器人、智能音箱等物联网设备进行结合,其中驾驶和客厅这两大场景是目前语音交互的重点关注领域。

2. 打造更为自然的语音表达系统,尤其是一些对电话语音服务有需求的运营商公司,比如刚才说的中国移动 10086。

3. 将文本内容(如资讯和电子书)转换为播客和有声读物,主要看重的还是拟人化的朗读效果。

另外,微软在今年的 Build 2018 开发者大会上也展示了 Cortana 语音助手在多人商务会议场景中的运用。

会上展示了一个圆椎体的音箱产品,它不仅支持人脸识别,而且还可以将多个人的聊天对话转成文字,并支持实时翻译,形成一份完整的会议报告,它甚至还可以解读出会议中的对话内容,对待办事项进行分类,以及提前安排下一次的会议时间和会议室。

虽说这只是一次视频演示,但也证明,AI 语音助手远不止现在问个天气和定个闹钟那么简单。

可既然是机器人,为什么要刻意做得和真人一样?

用人工智能减少人力成本,提升效率,一直是大多数公司都希望实现的事。一方面,我们都希望能够利用自动化手段,将刚才所说重复性、可预测的高度流程化任务,交给机器人甚至是 AI 来完成,让我们可以把精力放在那些更具创造性、不确定性因素更高的工作上,后者是目前人工智能难以取代的。

但另一方面,就和其它 “将人工智能做得神似真人” 的技术一样,Google Duplex 的亮相也引发了新一轮用户对人工智能技术的担忧。

牛津互联网学院的数字道德实验室博士 Thomas King 就表示:“Google 的这项测试其实是精心设计的一个骗局,如果他们假定人类无法区分出真人和 AI 的声音,如果一个接线员认为自己长期都在和一群机器人聊天,那么他的沟通方式还能保持和以前一样吗?也许没有礼貌也没关系?反正更粗鲁也不会伤到人心?这种想法会持续停留在脑海中——哪怕是他接到了一个来自真人的电话。”

也有人认为:“既然原本就是合成语音,为什么要刻意做得和真的一样?任何欺骗的成功实现,都会导致信任的破坏。当信任一旦开始流失,就会全面崩塌。”

类似的争论,我们能在许多国外科技媒体和 Twitter 上看到。大致的态度基本就是:“人类不想被机器人愚弄。”

虽然 Google 已经表示,在正式投入测试后会让 Duplex“表明自己 AI 的身份”,可具体的实现方式我们还不得而知。如果 Google 真打算将这种技术深入到日常生活领域,也无法回避刚才所说的伦理和道德疑虑。

考虑到现在智能音箱势头的火热,语音助手自然也成为各大巨头们角力的重点。可以预见的是,当语音合成技术愈发成熟后,让 AI 助手发出和我们相似的声音已经不是太难想象的事。

可如果你说的期望是和它谈天说地,又要猜到你内心的想法,就现在来看,Google 要面对的大概还不仅仅是技术问题。

题图来源:Newsunleashed