Google 这台最强 AI 手机,凭什么靠单摄就干掉了 iPhone XS?| 硬哲学

剥离技术和参数的外衣,探求设计与人文的本源。

没有太多硬件基因的 Google,对于智能手机产品一直有另一番理解,尤其是在拍照方面。

2016 年 10 月 5 日,Google CEO 桑达尔·皮蔡(Sundar Pichai)提出了由「移动为先」转为「AI 为先」的口号,同日亮相的初代 Pixel 手机就是这个理念的体现。

表面上看,Pixel 使用的摄像头和更早推出的 Nexus 6P 并没有太大变化,大家都是一样的 1230 万像素和 1.55 μm 的单像素尺寸,区别仅仅是加入了相位对焦功能。

但两者却在 DxOMark 上获得了完全不同的评价 —— Nexus 6P 只有不起眼的 73 分,但 Pixel 却凭借 89 分拿下了当时的榜首。

![]()

之后的第二代 Pixel 推出时,Google 也开始把关键卖点放在了拍照上,这款手机的评分涨到了 98 分,一举超过同期的三星 Galaxy Note 8 和苹果 iPhone 8 Plus 再度登顶,DxOMark 当时给出的评语是「创下智能手机相机质量的新记录」。

连续两次拿下榜单首位,加上媒体和用户的好评如潮,开始让 Google 亲儿子手机散发出一种神秘的吸引力。

虽然 DxOMark 的得分仅仅只是一个参考,但其中最让人不解的是,两代 Pixel 手机都仅凭单摄像头就获得了这一成绩,而其它手机基本都是后置双摄,难道 Google 的 AI 算法真的已经强大到能无视物理硬件了吗?

![]()

▲图片来自:Gizmodo

哪怕是在今天,新发布的 Pixel 3 手机也依旧没有采用时下主流的双摄乃至是三摄组合,这种「靠单摄独步天下」的功力,除了 Google 你也很难再找到第二家了。

但现在来看,它确实有这份「任性」的资格和底气。

Pixel 3 的摄像头有多聪明?

在大众用户的认知中,摄影的过程无非就是三个步骤:1)看到自己想拍的东西;2)打开相机按下快门,记录这个瞬间;3)获得一张静止不动的照片。

专业摄影师就不一样了。他们得根据现场的光照情况对应调整快门和光圈大小,选择合适焦段的镜头,拍摄时会考究构图和按快门的时机,拍完还要拿去 PS 或 LR 里后期一下,最终才得出了我们眼中的各种「大片」。

![]()

▲图片来自:Businessinsider

但智能手机的普及改变了这一切,不管是 Pixel 还是 iPhone 或其它手机,手机厂商都在淡化原本只有摄影师才懂的 ISO、曝光时间等数值,这些交给处理器和算法完成就好了,用户只要懂得按下快门,也能拍出一张媲美卡片机的照片。

Google 显然也懂得这个「拍照傻瓜化」的道理,只是比起寻求专用硬件来点亮更多的技能树,它更喜欢利用 AI 和各种堆栈算法来解决问题。

这种思路很有趣,说白了,它希望让机器自己去学习如何才能拍得更好。

![]()

在去年的 Pixel 2 系列中,Google 专门加入了一颗名为「Pixel Visual Core」的定制图像处理单元,这是 Google 与英特尔合作开发的 8 核心协处理器,目的是用来加速各种与 AI 拍照相关的任务,比如 Pixel 系列一贯主打的 HDR+。

而在 Pixel 3 上,这颗 Visual Core 核心也获得了更新,它的处理速度比去年快了 40%,意味着它能对更快地处理各种繁杂的照片源数据,在机器学习的帮助下还让 Pixel 3 解决了一些日常拍照的痛点。

![]()

首先是名为「Top Shot」的照片精选特性,它能够在你按下快门时自动记录前后数秒的影像,有点类似 iPhone 中的 Live Photos,但此时 AI 还会自动将「最佳时刻」打上标签供你挑选,所以就算是你不小心拍到别人闭眼的窘态,也可以选择其它画面作为最终照片。

▲「Night Sight」不仅适用于后置,也适用于前置。图片为 Google 官方样张

至于在伸手看不清五指的场景下,Google 给出的方案是「Night Sight」夜景模式,这个功能的核心还是借助 HDR+ 的连续采样和多帧合成,目的是尽可能地提高照片的亮度,彻底解决「暗光拍不到」的问题。

![]()

为了强调这个模式的出众效果,Google 在发布会上还对隔壁 iPhone XS 进行了一番「吊打」,也不知道苹果此时的心情是怎么样的。

还有一个是「Super Res Zoom」,主要是取景是变焦后图片放大的情况,其实是将一些传统单反中的「像素偏移模式」用在了变焦功能上。

▲ engadget 日本使用 Pixel 3 拍摄的样张,如果放大图中框选的部分…图片来自:engadget

▲ 这是 Pixel 3 放大后的样张。图片来自:engadget

具体来说,Google 抓住了我们取景时都会轻微抖动的小细节,它会在这个过程自动根据手部运动移动感光元件,然后并连续抓拍数张照片,再借助算法进行合成。

在这个方式下,每个像素都可以获得足够的 RGB 信息,最终便能实现一张拥有超高解析力的照片。

按照 Android Central 的说法,哪怕是放大 8 倍,Pixel 3 的变焦照片仍然能保持和 Pixel 2 上 2 倍变焦的清晰度。这意味着就算没有独立的长焦镜头,Pixel 3 仍然可以拍出不亚于光学变焦效果的照片。

Google 延展的不止是拍照的广度,还有拍照的深度

我们已经看过所有能选择的镜头组合,单纯加一颗摄像头对我们而言并没有好处。

在 Pixel 3发布会后,Google 的产品副总裁 Brian Rakowski 这样说道。在他看来,Pixel 手机已经能通过传感器获得足够多的信息,之后再通过机器学习等方式,同样能产生用户所需要的照片。

本质上看,Google 是在尝试用「计算摄影(Computational Photography)」的概念,为传统摄影引入 AI 机器学习等高级算法,等同于是对分辨率、光照、对焦点和景深等这类图像信息进行一次重新梳理,以此突破单摄像头的物理边界。

打个比方,以 Pixel 2 中的 HDR+ 为例,表面上看你用手机拍照只是打开取景器再咔嚓一声,可暗地里摄像头在你打开取景器后就开始采集工作了,这些数据会实时保留在手机缓存中,并最终被合成算法所调用。

除此之外,Google 还将图片分割成一个个独立的方块,保留高动态范围和细节的同时,也会尽可能地去除模糊、鬼影和噪点。

![]()

还有像前文提到的「Top Shot」这种「先拍后选」的模式,其实也受到了计算摄影思维的影响,它们都是在用户无法感知到的底层去实现。

DPReview 近期采访了 Pixel 的相机产品经理 Isaac Reynolds 以及计算摄影主管 Marc Levoy,他们表示,为了保证零延迟快门的体验,当初 Pixel 2 的安全快门值设为了 1/15 秒,这样哪怕是在最糟糕的暗光环境,HDR+ 也可以保证在 0.6 秒内对最高 9 张图像进行合成;若是光线充足状态下则可以缩短到 150 毫秒。

很显然,用户是不会感知到这些后处理流程的,呈现在我们眼前的只是最终的成品照。

而在 Pixel 3 上,用于「Super Res Zoom」变焦模式的合成图像会高达 15 张之多,而「Night Sight」夜景模式更是牺牲了零延迟快门。

它和一些国产手机的超级夜景一样,需要你在按下快门的同时保持机身稳定,此时相机会捕捉最高 15 张照片并进行合成,每张照片的快门速度最低为 1/3 秒,由此来获得接近 5 秒曝光效果的照片,其中因手抖而糊掉的照片也会被自动剔除。

不仅如此,考虑到黑暗环境下的糟糕光源,「Night Sight」拍摄出来的照片也会借助机器学习来实现自动白平衡。

![]()

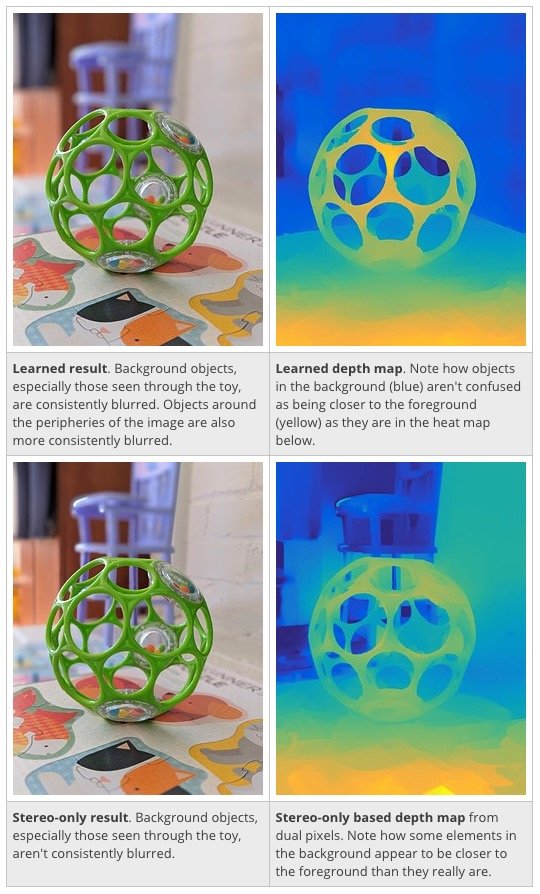

另一个不得不说的是自 Google Pixel 2 时代就备受好评的人像模式,虽然这款手机并没有配备双摄像头,但依旧可以拍出不输于同期双摄旗舰的虚化照片。

实际上,它借助的是摄像头传感器的 PDAF 双像素特性,来捕获左右两种视觉图像,从而得到简单的深度信息,然后再依靠图像分割技术,对图像轮廓进行精准定位。

在这个过程中,Google 花了不少心思训练了一个神经网络模型,它会根据深度信息分辨出照片中哪些部分属于人物,哪些部分是属于背景的,毕竟只有分清前景和后景,算法才能对正确的区域进行虚化处理,最终才能合成一张浅景深的照片。

▲上图为机器学习参与后的深度信息图,下图则是单纯基于双像素和立体算法的深度信息图,背景椅子的部分可以看到明显的差异。图片来自:DPReview

在今年的 Pixel 3 上,Google 对深度映射算法又做了新的调整,通过机器学习来获取更精准的深度图。

从上面的对比图中也能看到,如果只是单纯基于双像素和立体算法,碰到像掏空的玩具球、玻璃杯或是有网格栏杆这类前后景模糊的场景时,深度信息很可能会识别出错。

但在机器学习参与后,整个虚化效果和范围就跟以前不一样了。

有了 AI 拍照,能让 Pixel 手机变得和 iPhone 一样流行吗?

Google 是靠搜索和工具业务起家的,本质上不是一家硬件公司,即使是 Pixel 手机,它的整个重心都是围绕服务和 AI 展开的。

所以在历届 Pixel 发布会上,最出风头的仍然是 Google 的软件服务。演讲人不会对配置做太多的介绍,更多会去强调那些「只有 Pixel 手机才能用上的功能和服务」,这其中就有各种 AI 拍照的身影。

▲图片来自:Post and Courier

但面对苹果、亚马逊等巨头公司的步步紧逼,Google 又不得不做硬件,就像 Google 的硬件负责人 Rick Osterloh 所说的那样,他要找到更多的方法让 Google 智能助手出现在人们面前。所以你不仅能看到 Pixel 手机,还有各种音箱、耳机与平板电脑。

这并不是一个主流的玩法,在很多人看来,智能手机是一门硬件生意,推动消费者每年换手机的动力来自更好看的外观、更强的处理器和更多的摄像头,各种手机产品的横评也只是硬件参数的对比,而无法量化的软件只能一笔带过。

毕竟,除了 iPhone,其它主流手机都是用 Android 作为底层,跑同样的 apk 应用,也唯独只有硬件能做出比较大的差异。

可 Pixel 手机依旧和其它 Android 不一样,这是 Google 亲自参与的,只有它能够将 Android 系统改造成自己想要的东西,不然你也不会看到那么多基于底层的拍照算法。

在 AI 加持下,没人能猜到 Pixel 手机还能带来多少我们所不知道的玩法。

▲ 图片来自:Nagisa Ichikawa

但 AI 并非无所不能,Pixel 3 上依旧有只能靠硬件来实现的特性。比如说新加入的 800 万前置广角镜头,就是专门用来拍多人集体照和大场景自拍的,这两种场景都没办法靠传统的自拍镜头实现。

还有那颗 Visual Core 核心,如果没有它的协助,Pixel 3 的 AI 拍照也无从谈起。

归根结底,手机中的 AI 仍然要依靠足够的计算力来驱动,没有优秀的硬件做基础,软件体验显然得打个对折。

但 Google 显然在为手机摄影带来另一种发展方向,这也给那些原本就有强大物理硬件加持的同僚们更多启示。当然,也无疑让消费者们对手机拍照有了更大的期待。

题图来源:Nagisa Ichikawa