不要相信 AI 情感识别

情感识别是一个热门的新领域。

亚马逊、微软、IBM 等科技公司纷纷在卖它们的「情感识别」算法,用语音分析、肢体分析、步态分析,到眼动追踪等各种方式,来分析人们的情绪状态,不过其中最受关注的,还是面部识别。

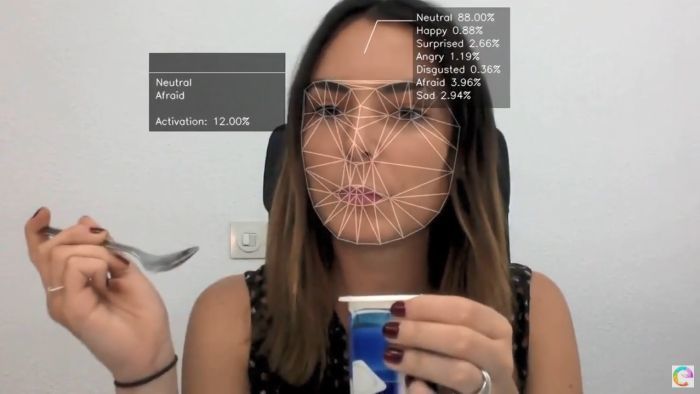

▲亚马逊能从图片猜测一个人的身份,性别,年龄和情绪状态. 图片来自:纽约时报

面部识别情感是科学家们至少争论了 100 年的话题。但是过去一个世纪几乎没人对情感研究做过全面评估。

所以情感科学领域来自不同理论阵营的 5 位杰出科学家,审查了 1000 多份不同的科学论文,开始了一项为期 2 年的数据检查研究。

从面部动作中推断人类情感是不可靠的。

总的来说,他们认为目前对于面部情感的表达和感知方式,存在以下三种误解:

一是同样的情感并不总是以同样的方式表达,二是同样的面部表情不能表明同样的情感,三是不同文化和背景的面部感情表达都不同。

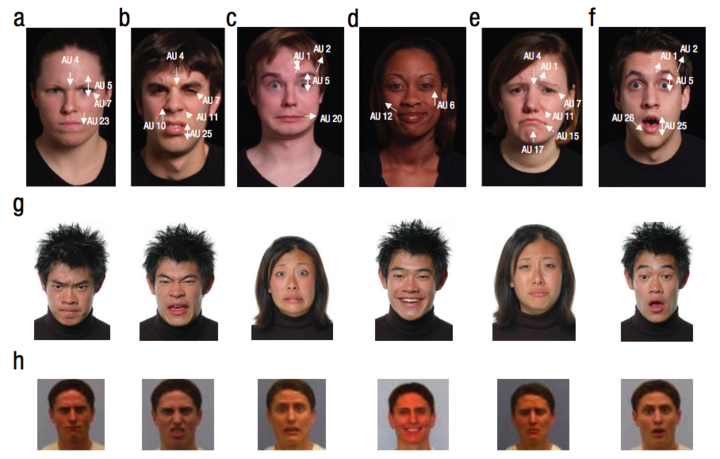

▲ 图片来自:情感研究实验室

科学家之一 Lisa Feldman Barrett 说道:

数据显示,当人们生气时,只有不到 30%的时间会皱起眉头,所以愁眉苦脸并不一定是愤怒的表现,只是愤怒的表达之一。更多时候人们皱眉只是他们正困惑、专注做事情,或者闻某样气体。

人们会愤怒地嘶喊,也会高兴地流泪,会在爱慕之人面前假装漠不关心,也会在春风满面的时候计划一项阴谋。这些情感太过复杂,甚至就算是把人们的面部表情放在你面前,你也看不出这是哭、是笑、是惊,还是只是单纯地爽:

▲英国汽车制造商 Jaguar Land Rover 开发的驾驶辅助装置识别技术. 图片来自:Jaguar Land Rover

在一些针对面部表情与情感之间的相关性研究中,也存在着和人们生活中真实情况不符的缺陷。

当研究中参试者被要求表达感情时,他们往往会从既定俗成的面部情绪,以达到大家普遍认为的愤怒、厌恶、恐惧、快乐、悲伤、惊喜等表情共识。

一些大公司承认了情感表达的微妙之处很难判定。比如微软就表示它们的软件分析情感主要「认准八大核心情绪状态」。但把情绪归类,实际上有点刻板印象。

▲较普遍的六种情绪类别:愤怒,厌恶,恐惧,快乐,悲伤和惊喜.

还有一些公司尝试了更多可能性,在该领域技术领先的公司 Affectiva,表示它们不限于面部表情识别情绪,还收集了更多指标评定,去年他们就让面部识别和语音分析结合,来判断驾驶员的情绪,但所有的指标加在一起如何平衡也有待考量。

需要引起注意的是,在面部情感识别尚未完全达到理想效果时,它已经进入我们生活了。

当它利用不准确的标准,达成不严谨的决策,就可能对人们造成一些真实的伤害。已有公司在招聘时以此判断应聘者是否能胜任工作,这可能会导致某人屡屡失业,或求职时刻意伪装;在法庭中法官用面部表情判断嫌疑人是否犯罪,可能会直接导致一场死刑。

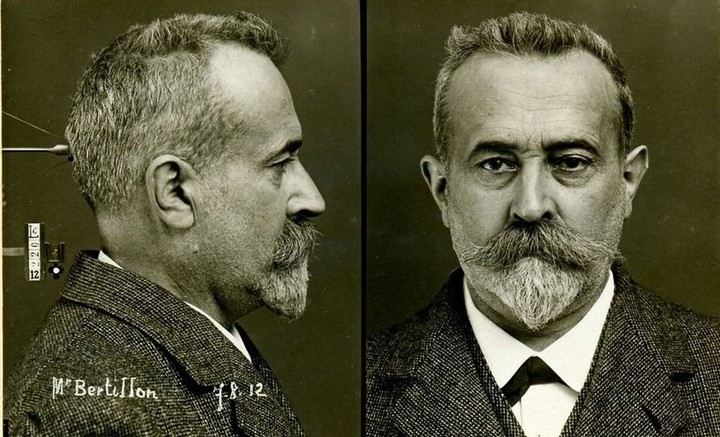

▲法国警察和面部分析先驱 Alphonse Bertillon 靠该技术识别屡犯者. 上图为 Alphonse Bertillon 示范大头照.图片来自:纽约时报

AI Now Institute 的一份报告也认为该技术正在「以不道德和不负责任的方式应用」:

这些简单类别的算法可能会重现过时的科学范式的错误。

但需要肯定的是,在我们未来生活中,情感识别可以预见地会越来越重要。

车上的面部识别情感技术,可以识别到我们驾驶时正在犯困或焦躁的情绪,然后提醒我们更加专注和平静,以减少事故的发生。

手机上能够面部识别情感的话,就能根据我们的状态,让我们刷社交媒体时收到更符合心境的内容,而对商家来说,他们也希望能以此衡量我们对广告的反应,给我们进行更准确的产品推荐。

▲Affectiva 公司的市场研究.

另外,情感失控在当代网络上,随时都可以掀起一场波澜。而面部识别情感或许能在人们想发出一条言语暴力的攻击时,收到平台的提醒:

你这条消息可能会让一万人受到心理伤害。

事实上,整个自动化的情感识别行业正在迅速崛起。

全球情感识别和情感分析软件市场研究报告预测该市场在 2018-2023 期间将以 60.25%的复合年增长率增长,美国公民自由联盟 (ACLU) 指出,2025 年情感识别软件的市场预计将在广告营销、驾驶出行、智能机器人等领域达到至少 38 亿美元。

▲ 图片来自:ACLU

但随着市场需求越来越大,不管情感识别的技术会不会更加先进,从而达到精准识别人们内心的情感,我们都最好用更批判的目光看待它。

因为对情感错误理解的算法可能会使偏见更难以发现,而且更深一层的忧虑正如 AI Now Institute 报告所说:

它会严重引发令人不安的道德问题——即将个人真实性格和情感的仲裁者,定位在个人之外。

毕竟谁也不想未来走在路上,人人脸上都是蒙娜丽莎的微笑。

题图来自:Inverse