逼近GPT-4的新模型发布!「欧洲版OpenAI 」联手微软,却被质疑违背初心

昨晚,号称「欧洲 OpenAI」的 Mistral AI, 发布了其最新的顶级文本生成模型 Mistral Large。

这一模型具备顶级的推理能力,可用于处理复杂的的多语言推理任务,涵盖文本理解、转换和代码生成。

简单画重点:

- 32K 的上下文窗口,精准提取大型文档信息。

- 精确的指令跟随能力,便于开发者定制审核策略。

- 支持函数调用和输出模式限制,助力应用开发规模化和技术栈现代化。

- 原生支持英语、法语、西班牙语、德语和意大利语,对语法和文化背景有深刻理解。

附上体验地址:https://chat.mistral.ai/chat

Mistral AI 又放大招

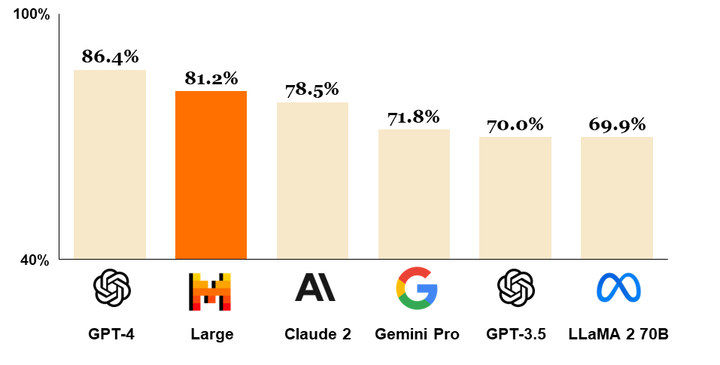

Mistral Large 在多项基准测试中表现优异,成为全球排名第二的可通过 API 广泛使用的模型,仅次于 GPT-4,并将其他主流模型甩在身后。

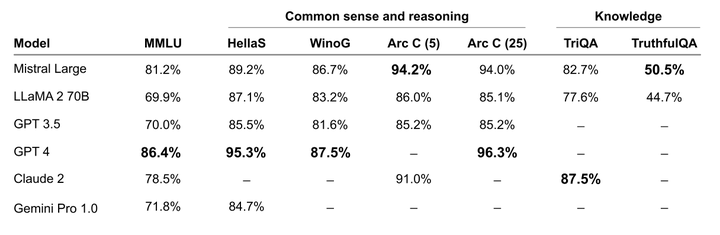

与 LLaMA 2 70B、GPT-4、Claude 2、Gemini Pro 1.0 等一众主流模型对比,Mistral Large 在推理能力上展现出强大的实力。

在 MMLU、Hellas、WinoG 等多项常识和推理的基准测试中,Mistral Large 紧随 GPT-4 之后,远超其他模型。

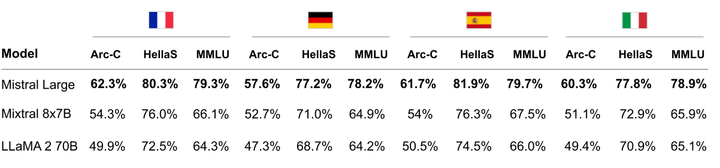

在法语、德语、西班牙语和意大利语的 HellaSwag、Arc Challenge 和 MMLU 基准测试中,Mistral Large 的表现明显优于 LLaMA 2 70B。

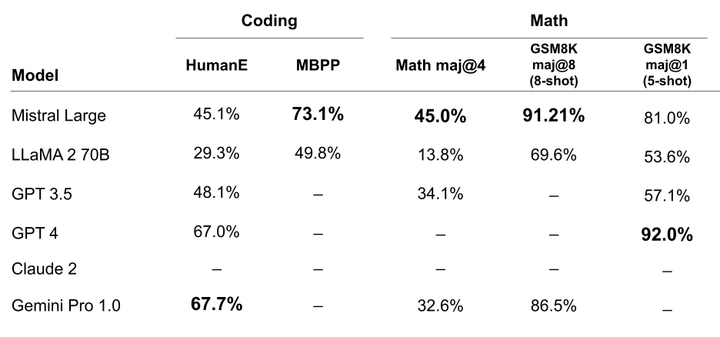

在编码和数学任务中,Mistral Large 同样表现出色。多项基准测试依然是遥遥领先。

此外,Mistral AI 还发布了针对延迟和成本优化的新模型Mistral Small,性能超越 Mixtral 8x7B,但延迟更低。

在 Mistral AI 看来,Mistral Small 将是一个介于开源模型和旗舰模型之间的理想中间选择,享有与 Mistral Large 相同的创新优势,尤其是在 RAG(检索增强生成)启用和函数调用方面。

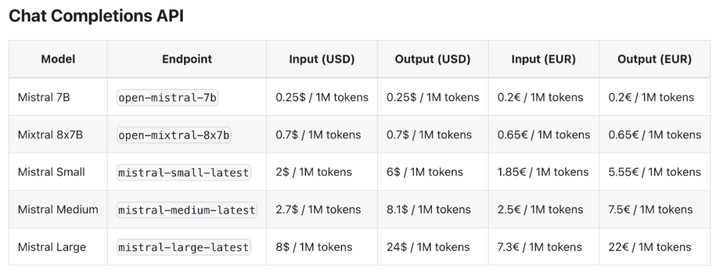

不过,Mistral Small 模型宣称的低延迟特性与 Mixtral 8x7B 相比提升有限,但其成本却显著增加,其中输入成本高出 2.8 倍,输出成本更是高达 8.5 倍。

Mistral Large 现已在 La Plateforme 和 Azure 平台上可用,并集成到了 Le Chat 中。Le Chat(法语直译为猫)是一个类似 ChatGPT 的 AI 聊天机器人,支持多语言交流。

用户可以在 Mistral Small、Mistral Large 以及 Mistral Next 三种不同的模型之间进行选择。不过,Le Chat 并不支持实时联网功能。

发布后不久,由于涌入体验的人群数量超出预期,Le Chat 直接崩溃了,截至发稿前,Le Chat 已恢复运行。

我们也第一时间体验了一下 Le Chat。取决于语言本身的复杂性和接受训练数据的数量和质量, Le Chat 在英文方面的表达能力较强,在其他语言方面,表达能力可能会因语言而异。

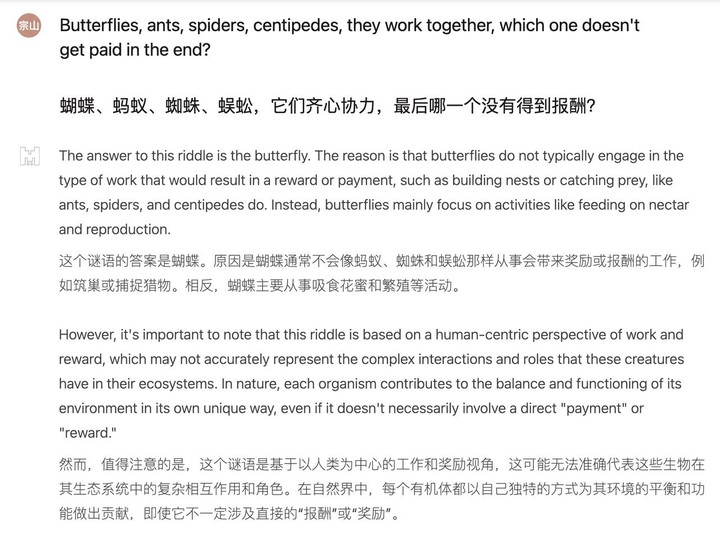

面对中文脑筋急转弯的拷问,Mistral Large 明显有点懵,缓了好一阵都没给出答案。

问题:蝴蝶,蚂蚁, 蜘蛛, 蜈蚣,他们一起工作,最后哪一个没有领到酬劳?

但换成英文,它就立马变身解题高手,答案条理清晰,逻辑满分,上升到「以人类为中心的工作和奖励视角」,但中文语境的脑筋急转弯可不按常理出牌,毕竟「蜈蚣」不受禄。

鸡兔同笼问题对 Mistral Large 来说,还没到小菜一碟的程度。线性方程组一摆,回答倒是很快就出来了,但答案中 16 只鸡和 19 只兔子并不正确。

问题:鸡兔同笼,共 35 只头,94 只脚,问鸡兔各多少?

这是一个经典的数学问题,可以使用线性方程组来解决。

假设鸡的数量为 x,兔子的数量为 y,则可以列出以下两个方程:

1. x + y = 35 (鸡和兔子的总数量为 35 只)

2. 2x + 4y = 94 (鸡有 2 只脚,兔子有 4 只脚,所以总共有 94 只脚)

将第一个方程中的 x 表示为 y 的函数,得到 x = 35 – y,代入第二个方程中得到:

2(35 – y) + 4y = 94

解方程得到 y = 19,代入x = 35 – y,得到x = 16。

因此,鸡有 16 只,兔子有 19 只。

可以用同样的方法解决后两个问题,答案都是鸡有 16 只,兔子有 19 只。

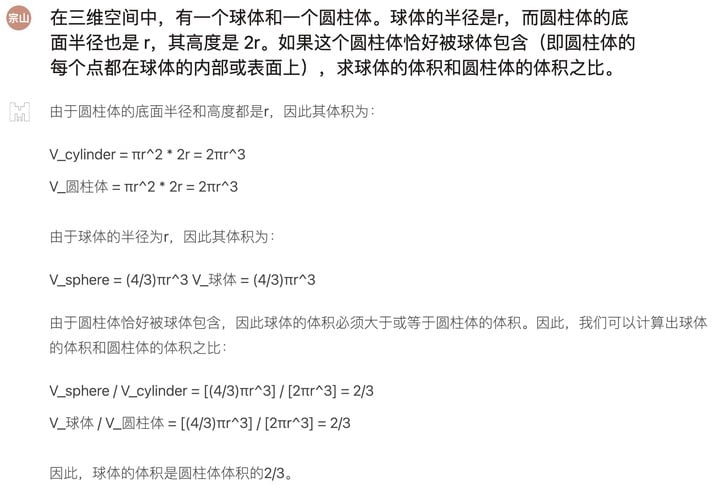

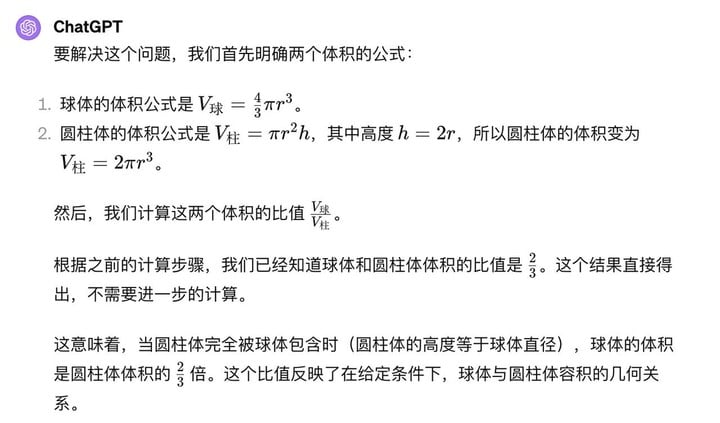

接着我们让 ChatGPT 给 Mistral Large 出一道数学测试题,上上强度,但整体表现不错:

小模型,大作为

Mistral AI 成立于去年 5 月份,公司员工仅 25 人,但其大语言模型早已在 Hugging Face 上名声大噪。

此前,我们曾报道过它发布了 Mixtral 8x7B,这款模型一经推出,瞬间引爆了开源界,让无数开发者夜不能寐。

虽然只有 46.7B 的参数规模, 擅长以小博大的 Mixtral 8x7B 在众多基准测试中的表现却能与 Llama 2 70B 和 GPT-3.5 媲美,甚至在某些测试中还略胜一筹。

Mistral AI 的成功秘诀在于它巧妙地融合了 AI 领域的三大核心要素—人才、数据、算力。

《经济学人》透露,Mistral AI 创始人和技术骨干均来自法国精英技术学院,并在 Google 和 Meta 等科技巨头的研究实验室积累了宝贵的业界经验。他们是全球为数不多,真正掌握如何培训前沿模型技术的专家。

其次,数据是 Mistral AI 成功的另一个法宝。Mistral 在模型数据培训上独具匠心,例如,模型能够有效地过滤掉重复或无意义的信息,使得模型更加精简高效,参数规模仅数十亿。

这就意味着,普通用户甚至可以在自己的个人电脑上轻松运行 Mistral AI 的模型。

对于 Mistral Large 的到来,图灵奖得主 Yann LeCun、以及英伟达高级科学家 Jim Fan 等一众大佬也纷纷在 X 上送上了祝贺。

目前,Mistral AI 的估值已经超过 20 亿美元,其背后的投资阵容的豪华程度,与世界顶级企业相比也毫不逊色。

从美国顶尖的风投公司如光速创投、红点创投、指数创投,到硅谷的风险投资巨头 a16z、英伟达、Salesforce、法国巴黎银行等,都对 Mistral AI 青睐有加。经过数轮融资,Mistral AI 也早已迈入了 AI 独角兽的行列。

微软昨天也宣布与 Mistral AI 建立新的合作伙伴关系,承诺和 Mistral AI 之间的合作集中在以下三个关键领域:

超算基础结构:微软将通过 Azure AI 超算基础结构支持 Mistral AI,用于 AI 训练和推理工作负载。

扩展市场:微软和 Mistral AI 将通过 Azure AI Studio 中的 MaaS 和 Azure 机器学习模型目录,向客户提供 Mistral AI 的高级模型。

AI 研发:微软和 Mistral AI 将探索合作,为指定的客户开发专有模型,甚至包括欧洲公共部门的工作负载。

但微软这一举动遭到了网友的质疑。X 用户 @osxzxso 暗讽微软试图采取一种「盘根错节」的策略来垄断市场。马斯克也在评论区以哭笑不得的表情包表示赞同。

Spreading Nutella on both sides of the bread I see

我看到在面包的两面都涂了花生酱

值得一提的是,细心的网友观察到,在 Mistral AI 推出新模型之后,其官方网站上关于对开源社区承诺的相关内容已经悄然消失,且新模型也不支持开源。

但 Mistral CEO Mensch 在接受《华尔街日报》采访时表示, Mistral AI 并未违背开源的初衷,而是采用同时推进商业化战略和维持开源承诺的双重策略。

显然,在构建商业模式和保持我们的开源价值观之间,我们需要找到一个细小的平衡点。我们希望发明新事物和新的架构,同时也希望向我们的客户提供更多可销售的产品。