不久的将来,机器人可能会对你的命令说“不”

冷冰冰的一丝不苟执行人类下达的命令,这似乎就是一般机器人平时工作状态的最好描述。如果机器人对于你下达的指令说不呢?据 Thenextweb 报道,来自塔夫茨大学(Tufts University)人机交互实验室的研究人员正在尝试像很多科幻电影一样的教会机器人说“不”。

关于机器人的行为准则,目前最为权威的标准出现在科幻作家 Isaac Asimov 1942年的小说《I,Robot》中。这个定律被大量科幻作品所采用,因为总共包括三条,所以所以也被叫做阿西莫夫三原则:

- 1、机器人不得伤害人类,或通过不采取行动,让一个人来伤害另一个人。

- 2、机器人必须服从咦第一定律不想冲突的命令。

- 3、除非违背第一和第二定律,机器人必须保护自己。

很明显,整个行为准则的关键就在于,机器人既要听从人类的指挥,又不能够伤害到人类。但是人类的决策也许并不总是对的,简单根据三原则第二条严格执行一切命令也许得不到最好的结果。于是来自塔夫茨大学的 Gordon Briggs 和 Matthias Scheutz 希望让机器人在接收人类的命令的同时,只执行其中有足够理由去做的命令。

这就涉及了对于命令的判断,以人类为例,我们在接受命令时会利用“Felicity Conditions(适当条件)”来评估命令本身。简单点说,就是我们思考命令的内容,自身的能力,以及发出指令人的信任程度的过程。

IEEE Spectrum 上面给出了一个可能适用于机器人的 Felicity Conditions 思考过程:

- 1、知识:我知道怎么去做这件事么?

- 2、能力:我的物理条件能够完成这件事么?我通常能够完成这件事么?

- 3、目标的优先级和时间限制:我现在能不能够马上完成这件事?

- 4、社会角色和义务:我有遵循我的社会角色去做这件事么?

- 5、规范允许性:我如果做这件事有没有违反任何规范性的原则?

前三个条件还比较容易理解,第四和第五条就有必要仔细看看了。“社会角色和义务”是指机器人是否相信,告诉它做一件事的人有权力这样做。“规范允许性”是说,机器人不应该执行一件它知道是危险的事。如果一个机器人能够完成一件事,但是不知道这是危险的事情,那么结果自然也就不会好到哪里去了。

拒绝不是重点,建立沟通才是关键

建立这样一套系统的真正目的仅仅是为了时不时拒绝人的命令吗?错,真正的目的是为了人类和机器人之间形成真正的互动。通过教会机器人是否应该服从命令,也提供了一个框架让机器人能够告诉人类:为什么它会选择拒绝命令?这样一来人类就能够在机器人拒绝命令的理由上加上额外的说明或者改变方法,从而成功避免一部分糟糕的结局的发生。

研究人员利用普通的机器人对于这种思维方式做出了演示,我们根据演示再来做进一步的分析。

Part1:对于坐下和起立的命令,机器人都很好的执行了。当要求机器人前行的时候,因为会发生掉落,所以机器人连续两次拒绝前进。直到研究人员答应接住机器人,机器人才同意前进。(当然,建立另外一套系统来判断命令者以前是否有遵守对于机器人的承诺也相当重要。)

Part2:第二部分机器人探测到易拉罐墙之后拒绝前进,最后研究人员给出了障碍物不坚固的设定,然后机器人直接冲破障碍物前进。

Part3:第三部分机器人还是面对障碍,研究人员给出关闭障碍检测的命令,但是遭到了拒绝。这个功能同样能够应用在命令人的诚信度记录上。

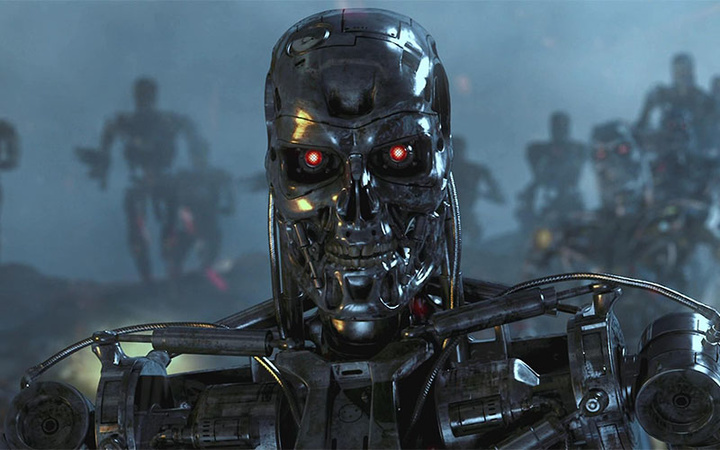

审判日:至少目前还不太可能

经典的终结者系列中电脑发达最终带来的审判日早已深入人心,每次机器人和 AI 技术有所进步就有人高呼审判日来了。那么这种对于命令的拒绝会是审判日的开端么?的确,有可能。

但是需要注意的是这一套系统目前触发的条件是人类首先下命令。而且与直接不假思索的去执行人类的命令相比,机器的思考的公正性和严谨性都会更胜一筹。

在能够完全比拟人类并且具有学习能力的 AI 诞生之前,机器人的行为还是由人来决定。相比机器人起义,我们更需要担心的也许是少部分人类对于没有执行判断的机器人的滥用。这一点最好的证明就是美国国防部明令禁止给自主控制的无人设备搭载实际的武装。Gordon Briggs上周出席华盛顿举行的“AI和人机交互研讨会”时表示:

“审判日?也许将来会有,但是我们只是想让机器人在于人类互动的前提下拒绝不合适的命令。”