制糖工厂正式发布 2026 款硬糖 C³,代际升级,重新定义三口快充头

耳机上为何长出了摄像头?|AI 器物志

2026 年 ChatGPT 要加广告了,最懂你的 AI 都开始出卖你

刚刚,高中辍学生创办的 AI 公司,被英伟达花 1400 亿「收购」了

大声 | 11-28 15:14

大声 | 11-28 15:14

我们在打造南网的电鸿,行业的电鸿,生态的电鸿,更是开辟未来的电鸿。

M5 Macbook Pro 首发体验:可能是最接近「游戏本」的一次

4:42

最适合记录生活的小相机!Insta360 GO Ultra 上手体验

2:34

iPad Pro M5 首发体验:eSIM 升级,但还有更多

1:21

视频|正面对决!大疆 OSMO nano 和影石 GO Ultra 怎么选?

04:53

视频|戴上眼镜,起飞!影翎 A1 全景无人机首发评测

04:33

视频|大疆首款扫地机实测:占领天空后,又来统治地板?

05:39

视频|这台全景相机,让我重现《F1》飞车镜头

04:22

视频|买前必看!2025 年 AI 眼镜怎么选?

03:05

视频|小米 MIX Flip 2 首发体验:升级点,都在点上

03:39

在开发者大会,华为给每个「走得慢的人」留了座位

06:43

手机影像的风向标!华为Pura 80 Ultra 影像实测

10:19

视频|鸿蒙电脑,靠国产软件能用起来吗?

5:11

专访苹果副总裁:AI 时代,苹果如何设计 Mac?

09:08

视频|你见过物理外挂吗?这就是!

09:51

拍港风夜景人像大片,只用一部 OPPO Find X8 Ultra!

06:39

视频|华为 Pura X 一周感受:这是最佳的折叠屏形态吗?

03:41

视频|卖 399 的 AI 键盘,到底有没有用?| 明日打假办

02:23

M4 MacBook Air 真机速看:蓝色西装,性能暴徒

2:25

视频|首发实测:10 万块的顶配 Mac,能跑满血版 DeepSeek 吗?

3:41

iPhone 16e 首发评测:信号好续航强?和 iPhone 16 比比看

05:16

“每日咖啡”的创始人李尚儒是一位97年的独立开发者,法律专业出身的他,自己一个人一台电脑开发鸿蒙,凭借“每日咖啡”等鸿蒙应用已实现稳定每月六七万的收入。李尚儒表示,选择鸿蒙是因为它没有“历史包袱”、技术新颖、市场潜力巨大。在鸿蒙这片“蓝海”中,小产品只要足够精致新颖,也能成为大爆款。他感受到的,是鸿蒙生态对独立创作者的平等与扶持,这也让他能够专注于创意实现。

“每日咖啡”的创始人李尚儒是一位97年的独立开发者,法律专业出身的他,自己一个人一台电脑开发鸿蒙,凭借“每日咖啡”等鸿蒙应用已实现稳定每月六七万的收入。李尚儒表示,选择鸿蒙是因为它没有“历史包袱”、技术新颖、市场潜力巨大。在鸿蒙这片“蓝海”中,小产品只要足够精致新颖,也能成为大爆款。他感受到的,是鸿蒙生态对独立创作者的平等与扶持,这也让他能够专注于创意实现。

“一封来信,一份使命”,驱动着小宇宙鸿蒙项目的负责人李会洋。一位准宝妈的“万字来信”,那句“不能没有小宇宙”的依赖,让他毅然决然拥抱鸿蒙,立下“非做不可”的信念。应用上线后用户量翻倍增长的曲线,是对这份真诚最好的回馈。

“一封来信,一份使命”,驱动着小宇宙鸿蒙项目的负责人李会洋。一位准宝妈的“万字来信”,那句“不能没有小宇宙”的依赖,让他毅然决然拥抱鸿蒙,立下“非做不可”的信念。应用上线后用户量翻倍增长的曲线,是对这份真诚最好的回馈。

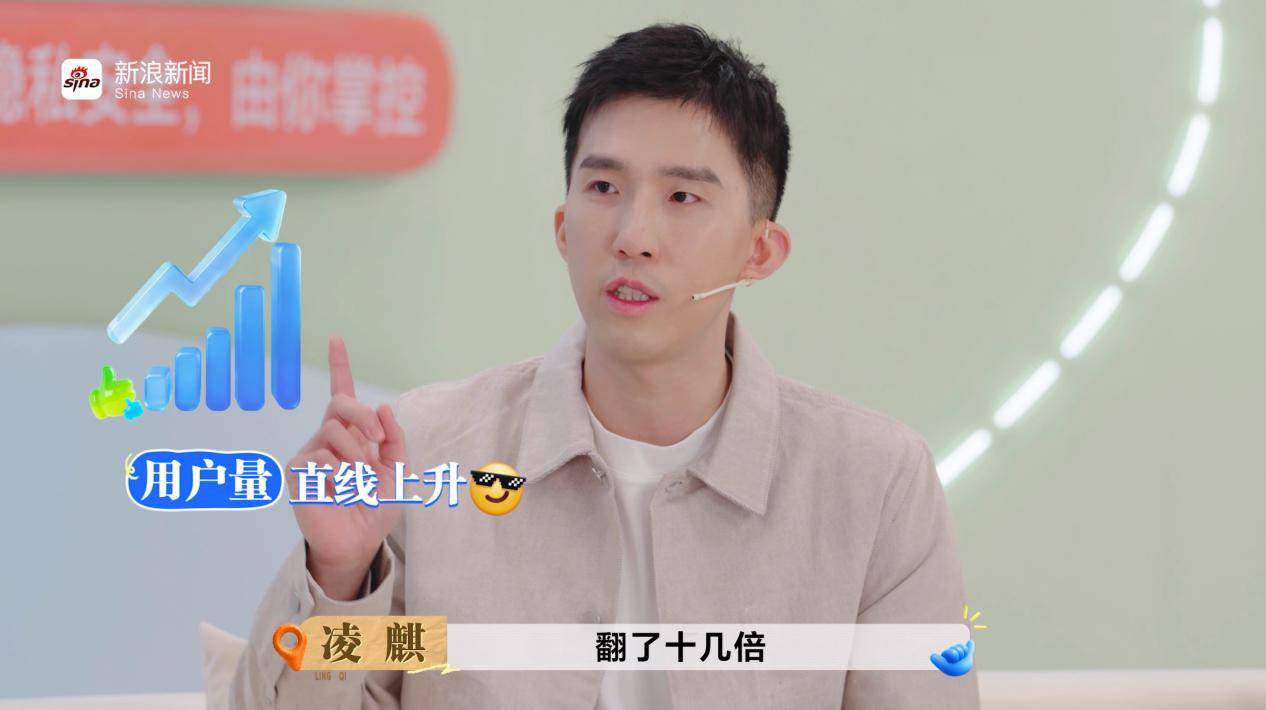

“圆周旅迹”的开发者凌麒则在鸿蒙上实现了其他平台无法提供的功能。他的旅行规划应用,在鸿蒙上借助“碰一碰”分享、多端协同等独家创新特性,解决了用户跨平台找攻略、组队规划的痛点。同时获得了鸿蒙生态丰富资源和扶持,极大推动了产品创新与用户连接。“我们本来打算自己去铺路的,结果发现鸿蒙早就帮我们准备好了高速公路。”凌麒说道。

“圆周旅迹”的开发者凌麒则在鸿蒙上实现了其他平台无法提供的功能。他的旅行规划应用,在鸿蒙上借助“碰一碰”分享、多端协同等独家创新特性,解决了用户跨平台找攻略、组队规划的痛点。同时获得了鸿蒙生态丰富资源和扶持,极大推动了产品创新与用户连接。“我们本来打算自己去铺路的,结果发现鸿蒙早就帮我们准备好了高速公路。”凌麒说道。

Canva可画的中国区总经理王可辛则看到了更远的未来,加入鸿蒙是其全球化战略的关键一步。她与鸿蒙团队的交流,更被一种“并肩作战”的使命感点燃。她坦言:“有些合作像甲乙方,但和鸿蒙,更像为同一目标解决难题的战友。”而创始人的那句“Do it”更是对鸿蒙生态最好的信任与肯定,不仅在国内获得机会,也为未来跨端、国际化体验进行了尝试。他们的加入,展现了鸿蒙在全球范围内的吸引力和潜力。

Canva可画的中国区总经理王可辛则看到了更远的未来,加入鸿蒙是其全球化战略的关键一步。她与鸿蒙团队的交流,更被一种“并肩作战”的使命感点燃。她坦言:“有些合作像甲乙方,但和鸿蒙,更像为同一目标解决难题的战友。”而创始人的那句“Do it”更是对鸿蒙生态最好的信任与肯定,不仅在国内获得机会,也为未来跨端、国际化体验进行了尝试。他们的加入,展现了鸿蒙在全球范围内的吸引力和潜力。

不得不说,鸿蒙生态不仅承载了技术创新,更汇聚了丰富的生活场景:工作间隙的播客收听,创意设计工具的即时呈现,旅行记录的社交互动,日常生活的点滴记录……这些看似平凡的体验,正是生态活力的真实体现,也让“在一起 就可以”的理念得以落地。

数字见证了鸿蒙这片舞台的吸引力:截至目前,搭载HarmonyOS 5和HarmonyOS 6的终端设备已突破3200万台,日增超过10万台。鸿蒙应用市场可搜索应用及元服务数量突破35万,联合超过2.3万款应用打造70多项鸿蒙创新特性。正是这一个个鲜活的数字,见证了生态因开发者而丰富、因合作而强大。

在鸿蒙的舞台上,每一开发者都是主角,每一次灵感闪现都可能成为改变体验的起点。这正如鸿蒙星光盛典所传递的核心理念一样“在一起,就可以”,当技术的边界被不断突破,当创意与真实生活深度交汇,一个由无数个体共同托举的生态正在生长。它不仅孕育应用与产品,更孕育信心与未来,让创新不再孤行,让可能持续发生。

不得不说,鸿蒙生态不仅承载了技术创新,更汇聚了丰富的生活场景:工作间隙的播客收听,创意设计工具的即时呈现,旅行记录的社交互动,日常生活的点滴记录……这些看似平凡的体验,正是生态活力的真实体现,也让“在一起 就可以”的理念得以落地。

数字见证了鸿蒙这片舞台的吸引力:截至目前,搭载HarmonyOS 5和HarmonyOS 6的终端设备已突破3200万台,日增超过10万台。鸿蒙应用市场可搜索应用及元服务数量突破35万,联合超过2.3万款应用打造70多项鸿蒙创新特性。正是这一个个鲜活的数字,见证了生态因开发者而丰富、因合作而强大。

在鸿蒙的舞台上,每一开发者都是主角,每一次灵感闪现都可能成为改变体验的起点。这正如鸿蒙星光盛典所传递的核心理念一样“在一起,就可以”,当技术的边界被不断突破,当创意与真实生活深度交汇,一个由无数个体共同托举的生态正在生长。它不仅孕育应用与产品,更孕育信心与未来,让创新不再孤行,让可能持续发生。

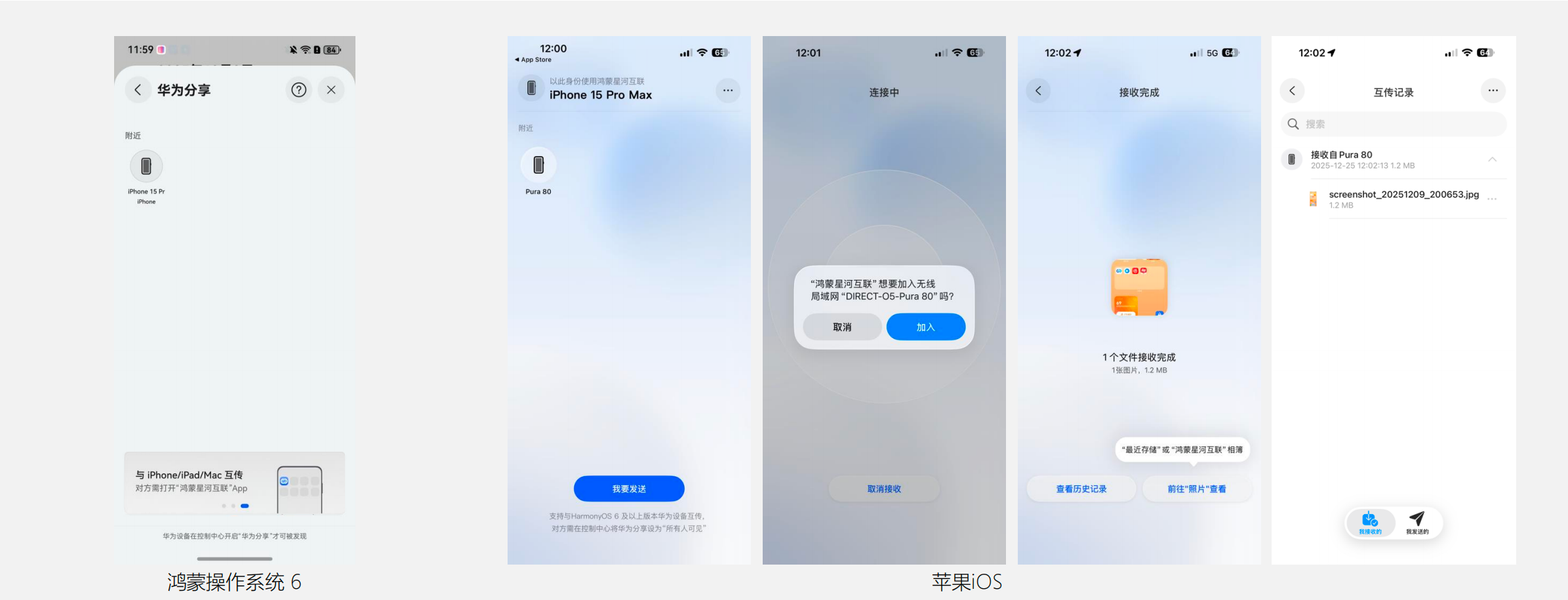

如果两台设备是在同一个局域网,例如在家中、咖啡厅这样的地方,并且都连接在同一个 WiFi 下,那么鸿蒙星河互联会优先使用局域网来传输文件;如果是在户外没有 WiFi 的情况下,那么鸿蒙星河互联就会以连接华为设备 WLAN 的方式完成互传。

正如前文所述,华为设备和苹果设备之间可以互传动图、视频、文档、通讯录等文件,不但支持大文件传输,也支持文件多选的传输,非常方便。

既然跨设备互传的底层依然是「华为分享」,那华为设备原本的多设备并发能力也完整保留。也就是说,从华为设备端发文件时,最多可同时向 4 台苹果设备进行传输。

这也就意味着,你用华为手机拍到的演唱会图片和视频,不用再排队等待「点名发送」,可以一口气分享给 4 个拿 iPhone 的朋友——速度更快,现场也更省事。

可见,HarmonyOS 6 带来的最大变化,是让跨生态互传真正回归「本该如此简单」:大文件无损传输、不需要网盘当中间商、更不用耗流量,直接高速直连,把过去那套繁琐的中转流程一刀切掉。

如果两台设备是在同一个局域网,例如在家中、咖啡厅这样的地方,并且都连接在同一个 WiFi 下,那么鸿蒙星河互联会优先使用局域网来传输文件;如果是在户外没有 WiFi 的情况下,那么鸿蒙星河互联就会以连接华为设备 WLAN 的方式完成互传。

正如前文所述,华为设备和苹果设备之间可以互传动图、视频、文档、通讯录等文件,不但支持大文件传输,也支持文件多选的传输,非常方便。

既然跨设备互传的底层依然是「华为分享」,那华为设备原本的多设备并发能力也完整保留。也就是说,从华为设备端发文件时,最多可同时向 4 台苹果设备进行传输。

这也就意味着,你用华为手机拍到的演唱会图片和视频,不用再排队等待「点名发送」,可以一口气分享给 4 个拿 iPhone 的朋友——速度更快,现场也更省事。

可见,HarmonyOS 6 带来的最大变化,是让跨生态互传真正回归「本该如此简单」:大文件无损传输、不需要网盘当中间商、更不用耗流量,直接高速直连,把过去那套繁琐的中转流程一刀切掉。