脑门贴张纸,就能骗过人脸识别系统?FaceID 已阵亡

本文来自微信公众号「量子位」(ID:QbitAI),作者鱼羊、栗子,爱范儿经授权发布。

你知道吗,在脑门上贴张符,AI就看不出你是个人了。

比如,这里有一个妹子,被人脸识别系统ArcFace发现了:

于是,她在脑门上贴了一张符。

人脸识别就不把她当人了,框框上的「Person」标签没有了:

就算把光线调暗,这张符依然可以保护她,不被AI发现人类的身份:

鬼片的光照条件,也是一样:

这样,万一哪天人类和AI打起来了,说不定还能逃过一劫呢 (误) 。

毕竟,去年发表的ArcFace,在现有的公开Face ID系统里面,是最强大的一个 (State-of-the-Art) 了。

而骗它的人,是来自莫斯科国立大学和华为莫斯科研究院的科学家。

他们的符上有特殊纹路,可以迷惑AI,这叫对抗攻击。攻击成本很低,符是普通的彩色打印机打出来的。

团队说,这是一个「很容易复现 (Easily Reproducible) 」的方法,还不光对ArcFace这一只AI有效,可以迁移到其他AI上,骗无止境。

网友说:开个公司,可以量产了。

并且,画符的算法已经开源了,那大家都可以生成欺骗人脸识别AI的符了。

说不定有一天,监控系统对陌生人出没,就没有抵抗力了。果然还是人类比较危险。

那么,先来看看画符的原理吧。

画符的原理

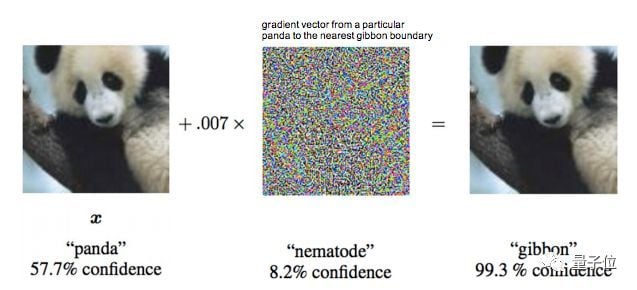

你可能听说过,在图像里加上一些噪声,熊猫就变成了长臂猿:

对抗性攻击在数字领域很容易实现,但在真实世界中,对抗攻击的效率大打折扣。

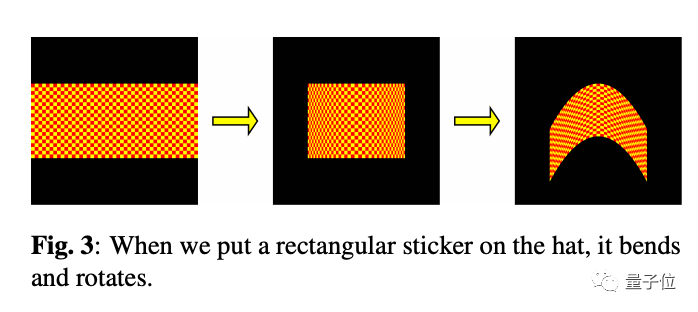

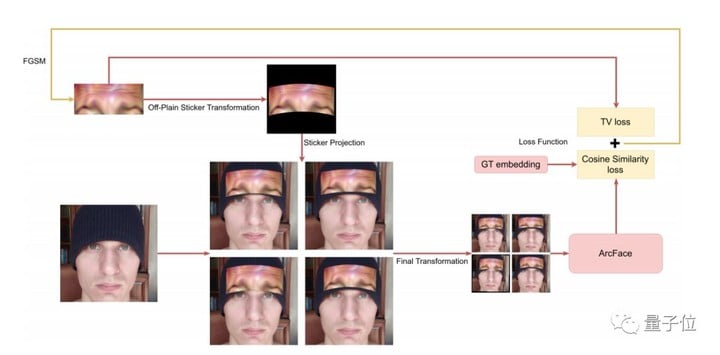

研究团队想到了一个方法,首先,他们琢磨出了一种新的离面变换方法,把一张平面矩形图像弯曲成三维抛物线,再进行旋转。

第二步,是把高质量的人脸图像投到变形后的「贴纸」上,并加入随机噪声。

然后,将由此获得的图像转换为ArcFace的标准输入。

最后,降低两个参数的总和:初始矩形图像的TV损失,和最后获得的图像的嵌入与ArcFace计算出来的锚嵌入之间的余弦相似性。

如此生成的对抗攻击图像,就不是一张平面的纸了,而是三维立体,能直接贴合人类脑门。

研究团队一开始完全随机地加入噪声。

在对抗样本生成阶段,他们采用的是具有动量的多次迭代FGSM方法(Goodfellow提出的经典对抗样本生成方法)。攻击分成两个阶段,第一阶段的迭代步长为5/255,动量为0.9;第二阶段的迭代步长变成1/255,动量为0.995。

在第一阶段的100次迭代之后,使用最小二乘法,通过线性函数对最后100个验证值进行插值。如果线性函数的斜率不小于0,则进入攻击的第二阶段。

在第二阶段的200次迭代之后,同样进行这一操作,如果线性函数的斜率不小于0,就停止攻击。

有趣的现象出现了。

比较成功的对抗图像,看上去都有点像人类的眉毛。

实际上,为了找到人脸的那个部位最适合投影到「贴纸」上,研究团队进行了数字模拟实验。他们发现贴纸的位置较低时能得到更好的验证值。即使限制了贴纸的位置,强制它高于眼睛,贴纸也总是会向下移动到更接近眼睛的位置。

而此前的研究也表明,眉毛是人类面部识别中最重要的特征。

不过最后生成的「贴纸」并不是通用的,是根据每个人的照片「私人定制」的。

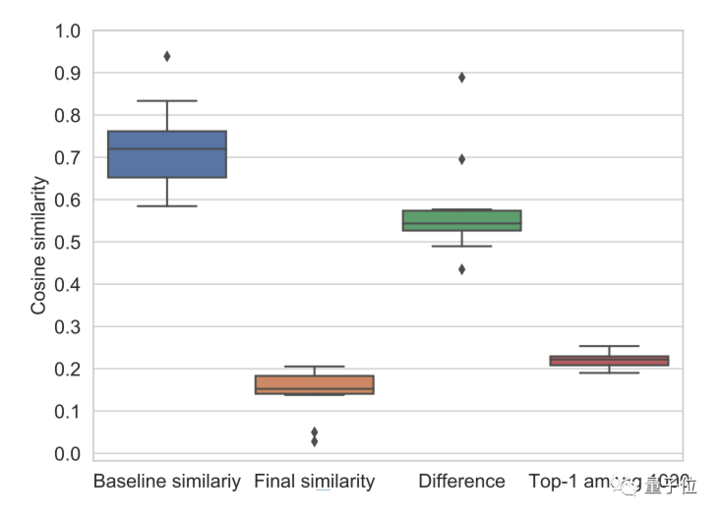

团队请了10个人类,来测试定制效果。4女6男,结果如下:

蓝色,是一个人戴上普通帽子前后,AI判断的类别相似度,在70%上下。(判断类别一致,就是人类没变。)

橙色,是一个人贴上对抗符前后,AI判断的类别相似度,降到了20%以下。(判断类别不一致,人类不再是人类了。)

定制成功,鉴定完毕。

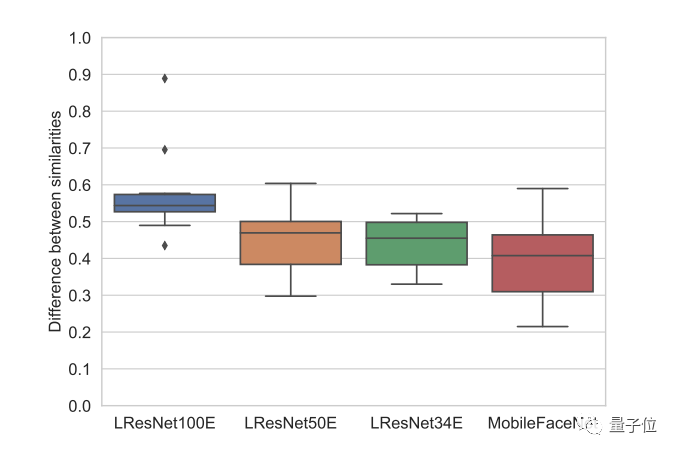

这套攻击方法,不止是对ArcFace有效,其他的的Face ID模型也一样扛不住。

▲ LResNet100E等模型基线相似度和被攻击后的相似度之差

骗过AI一向不难

其实,AI在对抗攻击面前,一向没什么抵抗力。

乌龟变步枪的旧事,这里不赘述,毕竟在那之后又有了许多先进的玩法:

比利时鲁汶大学的两位少年,就曾经拿一幅炫彩的对抗图画,挡在自己的肚子前面。

这样,目标检测界的翘楚YOLOv2,不光看不出他们是人类,连那里有物体存在都发现不了。

优秀的隐身衣,令人瑟瑟发抖。

另外,腾讯团队也曾经用对抗图,骗过一辆特斯拉。

一般情况,停车场里不会下雨的。但当屏幕上出现了一种奇妙的图案:

特斯拉的雨刷器就打开了。

并且,挥舞的节奏十分紧凑,仿佛AI看到的还不是绵绵细雨。

如果你觉得,开个雨刷器不算什么危险:

特斯拉的图像处理工具,都是身兼数职的:追踪其他车,追踪物体和车道,为周围环境画地图,以及估计雨量……

并且,腾讯团队还发现,刚才这些任务里面,大多都是只靠单一神经网络完成的。

这不就是说,一挂挂一片?

而今天的主角,来自莫斯科的对抗符,一个高能之处在于:不是把图案摆在面前,而是完全贴在脸上。

这就是说,经过3D扭曲/拉伸的图案,也可以用来欺骗AI。

其实,挡在肚子前面的炫彩对抗图出现之后,便有网友说最好印在T恤上,只是那时还不知道图案能不能承受人体的拉伸。以现在的技术,就做得到了。

另一个优势便是,它不止能欺骗一只AI,只要调调损失函数,就可以迁移到其他AI上了,攻击范围十分广泛。

不过,世界越来越危险,人脸识别显得越来越脆弱,倒也不单是对抗攻击的事。

福布斯的记者用3D打印的石膏人脸,破解了一众流行旗舰手机的AI人脸识别解锁功能;

腾讯又曾经用一副眼镜,攻破了苹果的面部识别系统。

骗术日新月异,人脸识别AI,还是要变得更强大才行。

所以研究人员是希望,这个新的人脸识别对抗攻击方法,可以用到人脸识别系统里,帮助各种Face ID系统进化成更加鲁棒、可以信赖的样子。

来自华为莫斯科研发中心

这项研究的两位作者Stepan Komkov和Aleksandr Petiushko,来自华为莫斯科研发中心。

目前,华为在俄罗斯拥有莫斯科和圣彼得堡两大研发中心,另外还在筹备第三个研发中心,总共人数将破千,在俄罗斯科技行业能算得上是规模巨大的研发机构了。

由于战斗民族数学一向很好,因此在俄罗斯的研究中心主要面向算法研究,此前就有华为俄罗斯研究所的一名数学天才,打通了不同网络制式之间的算法,帮助运营商节省30%以上的成本。

论文传送门:https://arxiv.org/abs/1908.08705

代码传送门:https://github.com/papermsucode/advhat