科学家造了个“噩梦机器”,这种 AI 会把人活活吓死吗?

编者注:本文部分图片可能会引起读者不适。

万圣节来临之际,麻省理工学的科学家们也应景地推出了一款能吓人的 AI——噩梦机器(Nightmare Machine)。

AI 开始学会吓人了?

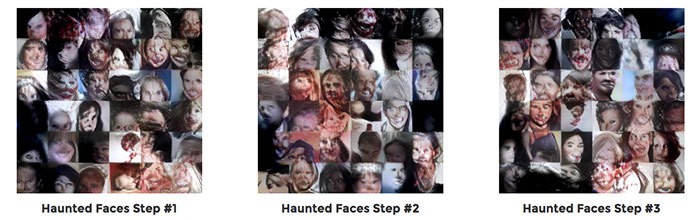

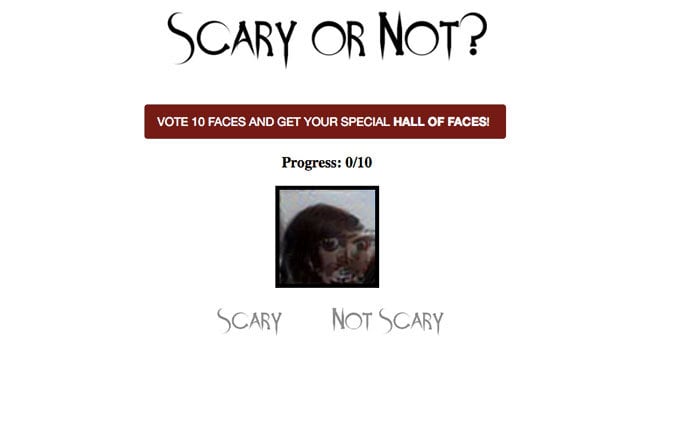

虽然名字听上去很可怕,但噩梦机器的原理并不复杂,就是通过各种算法让计算机生成恐怖图片,计算机再根据用户的反馈判断恐怖程度,不断学习。

也就是说,让用户来告诉 AI 哪些画面会带来恐惧感,比如更多的牙齿、更浅的皮肤、更深的背景等。

在进行了足够多的机器学习后,理论上 AI 能够产生足以让人见之色变的图像。除此之外,研究人员还使用了 Google Deep Dream 的原理,让 AI 给各地著名景点加上了诡异的效果。

图片来自:Nightmare Machine 官网

从目前的效果来看,这个 AI 的学习能力相当不错,比如官方 Instagram 放出来的这张布拉德‧皮特的恐怖照:

图片来自:Nightmare Machine Instagram

如果你感兴趣,也可以登陆“噩梦机器”的页面进行投票,给 AI 上上课。

说到能吓人的 AI,就不能不提到这方面的鼻祖——Google Deep Dream,这货从今年 6 月起就开始了制造噩梦了。

图片来自:The Verge

Deep Dream 是基于 Google 的图片生成技术(已开源),AI 在获取图片后,通过各层神经网络的处理,最后生成一件扭曲的后现代风格作品。

AI 会不会把人吓死?

然而,当 AI 开始学会吓人时,可能有人会担心:这是否意味着 AI 掌握了恐吓人类的技能,会吓人的 AI 算不算一种威胁?

事实上,无论是 Google 的 Deep Dream 也好,MIT 的噩梦机器也好,它们所涉及到只是与图像处理有关的算法,与“恐怖”无关。

图片来自:Deep Dream 官网截图

在 Deep Dream 中,图片经过卷积层时,第一层网络会识别出边缘、角等基础特征,经过层层变形(大概有 10-30 层),到了最后一层,这些基础形状已经被严重扭曲,特征也被放大,因而生成了类似抽象画的图像。

噩梦机器则用到了两项技术:风格转变(style transfer )和生成性对抗网络(generative adversarial networks)。

这两项技术去年才以论文的形式发表,前者主要是有关卷积网络自主收集图像数据的学习,后者则是基于艺术元素创作艺术图像的深层神经网络系统。

图片来自 Nightmare Machine 官网截图

此外,噩梦机器对于恐怖的判断,也需要依靠人类的反馈而进行学习,换句话说,目前的 AI,还在“人类控制”之下,远谈不上威胁。当然,仅凭三名科学家,就能够在短短一年内完成从理论到实际的应用,足以证明 AI 研究的飞速发展。

然而,你或许会质疑:没有自主意识的 AI ,要如何把握“恐怖”的分寸,万一把人吓死怎么办?

从“噩梦机器”页面中“含有恐怖内容,并非所有用户都适合观看”的提示可以看出,麻省理工的科学家们显然也考虑到了这个问题,但似乎也没有很好的解决办法,制作者也只能是尽到提醒义务,这与恐怖电影或是“鬼屋”游戏的做法类似。

图片来自 Nightmare Machine 官网截图

毕竟每个人对恐怖的承受能力不同,要知道即使是在人与人当中,因用力过猛把对方吓出毛病甚至导致死亡的事情也时有发生,如果 AI 已经发展到能够把握尺度的地步,那我们或许真的该担心了。

至于 Google 家的 Deep Dream,说是噩梦,倒不如说是“梦境”更合适,因为它只是将各种元素进行扭曲变形,也谈不上恐怖,比如像这样的:

图片来自:Deep Dream

还有像这样的:

图片来自:Deep Dream

以当前 AI 的发展来看,担忧它学会吓人似乎有些小题大做,毕竟它充其量也就是生成几张让人不适的图片而已。

题图来自: Nightmare Machine 官网