要看穿 AI 的内心戏?人类要走的路还长着呢

如今我们可以把很多事情丢给 AI 去做,例如人脸识别、语言翻译、开车等,然而,这又引发了一个新问题产生——AI 是如何做出这些决定的?

普通计算机运行的都是人类编写好的算法,但 AI 不同,我们通过输入大量的数据来训练一个 AI,例如各种英文与中文译文,由 AI 自己“学习”得出其中的对应关系。

(图片来自:QZ)

由于机器并不是使用自然语言来处理信息,这就导致我们很难理解 AI 究竟是如何得出这些结论的。因此,近来也出现了“算法问责制”的呼声,更容易地理解机器生成算法的过程已经被放到了首要位置。

为此,美国乔治亚理工学院的研究人员培训了一个 AI,它能够在玩《青蛙过河》 (Frogger) 游戏时用英语解释它的决策过程。

(注:《青蛙过河》 是一款 80 年代的经典街机游戏,玩家需要引导青蛙穿过危机四伏的河流,将其一只一只引回家。)

(图片来自:Codegolf)

事实上,这个 AI 并不是真正在讲述它所做的事情,而是预测在相同情况下,人类会如何描述这些现象。简单来说,就是研究人员给了 AI 一些词汇,让它将信息处理过程的那些字符“翻译”成人类可理解的文字。

具体是这样做的:

录制人类玩《青蛙过河》的游戏过程,并对玩家进行录音,将其转录成文本→将这一文本与人类玩家在游戏过程使用的算法相关联→设计一个单独的算法,让 AI 把看到的游戏算法与人类的语言对应起来。

比如,当 AI 写道“正在等待一个可以跳跃的地方好让我喘口气”时,实际上它可能不是真的在等可跳跃点,只不过是它在游戏中正好处于与人类玩家类似的场景,所以用了这些词汇对此进行描述。

就目前的研究进展来看,这个 AI 仍然只是一个概念的证明,研究人员表示它还需要专门的训练才能用于其他任务的执行,但至少表明人类在探索 AI 思考过程中迈进了一小步。

理解 AI 的决策逻辑对于快速定位错误以及完善 AI 的能力有着重要意义。比如当 Google 照片应用错误地将黑人标记为大猩猩时,工程师往往难以很快确定问题到底出在何处。如果能了解其决策过程,事情就会简单得多。

因此,除了乔治亚理工学院外,还有不少大学对这一课题展开了研究。

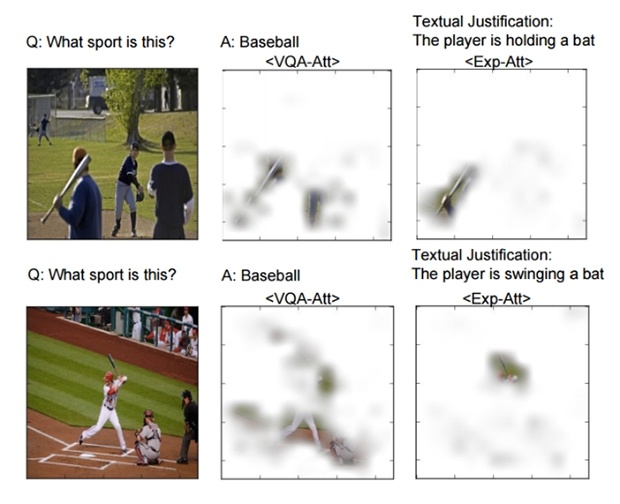

加利福尼亚大学伯克利分校和马克斯普朗克信息学研究所则提出了另一种研究方法,称之为“指向和对齐”(pointing and justification),训练 AI 以两种方式分析数据,一种用于回答问题,一种则回顾用于该决策的数据。

(图片来自:QZ)

麻省理工大学则是从模仿人类推导过程出发,让 AI 从中啤酒评级网站提取人类的评论文字(是否提取了气味、颜色等字样),以此为依据对啤酒打分,将结果与人类的评级进行对比,以探索 AI 是否有类似于人类的推导过程。(现在,AI 除了告诉你答案,还能解释为什么)

当然,以上这些都只是初步的研究,要了解 AI 复杂的决策过程,人类要走的路还很长。

题图来自:KNOAH